En este artículo vamos a ver con un poco más de detalle cómo funcionan los sistemas de enfoque por detección de fase en las cámaras de fotos.

Nos vamos a centrar sobre todo en el sistema que utilizan las cámaras réflex (sensores especializados, independientes del sensor de imagen).

Introducción

Recomiendo leer previamente estos artículos

- Qué es la distancia focal de un objetivo

- Enfoque y profundidad de campo

- Funcionamiento de una lente simple (modelar un objetivo fotográfico)

- Cómo funciona el enfoque automático en las cámaras

Hay muchas formas de conseguir un sistema que enfoque de forma automática.

Los sistemas activos tienen un principio similar al radar: se envía algún tipo de señal y se recoge y procesa el eco, la parte que refleja la escena y vuelve al emisor. Y a partir de ahí se puede determinar la distancia al objeto que se quiere enfocar.

Dentro de los sistemas de enfoque pasivo podríamos organizarlos en los que se basan de alguna forma en la paralaje y los que se basan en la detección de contraste.

Los sistemas de detección de fase que vamos a ver aquí están basados en técnicas de paralaje: a partir de dos puntos de vista diferentes se puede estimar la variación del ángulo relativo y a partir de ahí se puede calcular la distancia por trigonometría (técnicas de triangulación) o al menos se puede saber con cierta precisión cuándo se consigue el enfoque.

Sistema de enfoque en cámaras réflex

Los sistemas que utilizan técnicas de detección de fase para buscar el enfoque se suelen denominar sistemas PDAF de forma genérica. PDAF son la siglas de Phase Detection AutoFocus.

Todos se basan en un principio similar.

Para entenderlo mejor vamos a ver el sistema PDAF que utilizan las cámaras réflex (su sistema principal para fotografía, que es el que usa la cámara cuando utilizamos el visor óptico)

Las cámaras réflex digitales (y algunas cámaras réflex analógicas) utilizan un sistema que se conoce como: Through The Lens Secondary Image Registration Phase Detection Autofocus.

Sí, el nombre da miedo.

Vamos a desglosarlo para entenderlo mejor:

- Through the Lens (TTL)

Quiere decir que el sistema utiliza la imagen que recibe a través del objetivo principal. No hay objetivos secundarios (p.e. algún tipo de sistema binocular) - Secondary Image Registration

Quiere decir que no utiliza la imagen (óptica) principal que proyecta el objetivo sobre el plano del sensor.

Dicho de otra forma: este sistema no está integrado en el sensor de imagen o situado en el plano del sensor. Está situado en otra parte. Ahora veremos dónde. - Phase Detection Autofocus

Se utiliza un mecanismo de detección de fase (se mide la fase entre dos señales) para determinar si el objeto de interés está enfocado o no.

¿Dónde está el sensor de enfoque automático en las réflex?

Esto tiene que ver con lo de Secondary Image Registration.

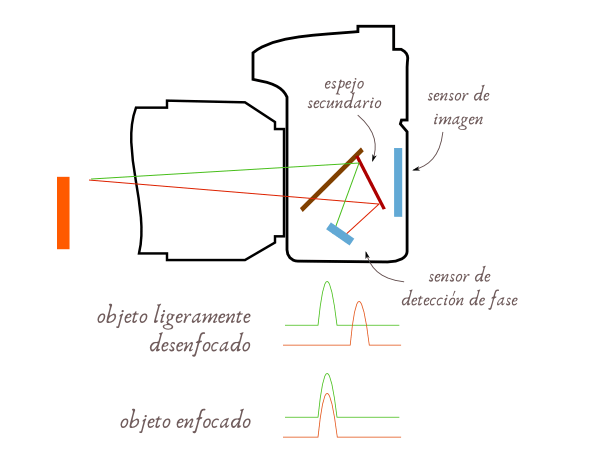

El chip que se encarga de la detección y toda la óptica asociada está situado en la parte inferior de la cámara.

Normalmente queda escondido por el espejo principal, pero lo podemos intuir en el interior, en el ‘suelo’ del interior de la cámara, al levantar el espejo (si tienes una réflex y quieres echar un vistazo al módulo no fuerces el espejo para levantarlo de forma manual, la mayoría de las cámaras réflex tienen una opción del menú que permite levantar el espejo para cuestiones de mantenimiento).

El espejo principal de las réflex no refleja toda la luz hacia el visor, es translúcido.

Una parte de la luz atraviesa el espejo principal y llega a un espejo secundario situado debajo del principal.

Y desde ese espejo se refleja hacia el módulo de enfoque.

Un esquema muy muy simplificado para entenderlo visualmente:

Por lo tanto, el módulo de enfoque recibe una copia de la imagen proyectada por el objetivo. La otra ‘copia’ va hacia el visor óptico a través del espejo principal.

Y cuando se levanta el espejo, la imagen principal se proyecta en el sensor o la película.

Cuando el espejo está levantado, tanto el visor óptico como el sistema de enfoque por detección de fase principal dejan de estar operativos.

El módulo de enfoque, que en el esquema he representado como un ‘sensor de detección de fase‘, es en realidad un conjunto de muchos elementos, que incluye una parte óptica compleja, el chip con los sensores, electrónica asociada, etc.

Principios básicos del enfoque por detección de fase

Estos sistemas que integran las réflex son muy complejos. Nos iremos haciendo una idea a lo largo del artículo.

Para entender el principio de funcionamiento voy a describir un sistema de juguete, una versión muy simplificada de los sistemas reales. Y más abajo hablaremos de un módulo real.

Vamos a suponer unas cuantas cosas:

- Vamos a usar una lente ideal (en el sentido de que puede ser todo lo grande que necesitemos)

- Por el momento no tendremos en cuenta el diafragma ni la apertura efectiva del objetivo

- No voy a usar lentes adicionales ni espejos. Este sistema de juguete sólo nos va a servir para enfocar, no para recoger la imagen principal (no serviría para hacer fotos)

- Nuestro sistema sólo tendrá un punto de enfoque, el punto de enfoque central, para simplificar las cosas.

Partimos de una situación en la que tenemos un objeto enfocado, el objeto naranja que aparece en la figura de abajo: su imagen se proyecta sobre el plano donde se encuentra el sensor de imagen (el sensor principal de la cámara).

Paralaje

Para calcular distancias o hacer estimaciones por paralaje necesitamos dos imágenes de la escena, que vengan desde dos puntos de vista diferentes.

De partida sólo tenemos una única imagen, la que proyecta el objetivo.

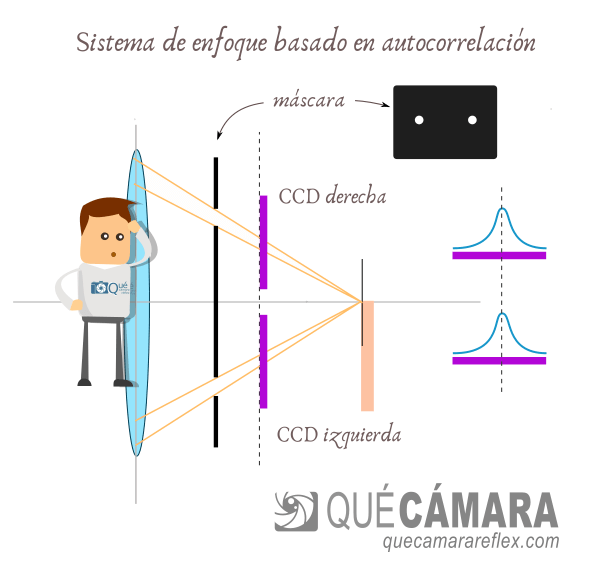

Para tener dos imágenes desde dos puntos de vista situados a cierta distancia podemos usar una máscara.

La máscara en este caso es una pantalla totalmente opaca que dispone de dos agujeros pequeños separados entre sí.

La luz, la imagen, sólo puede pasar a través de esos pequeños agujeros.

Ten en cuenta que el sistema de enfoque sólo necesita ver la imagen de una zona muy pequeña de la escena, la que corresponde al punto de enfoque que tengamos seleccionado.

Detrás de cada agujero vamos a colocar un sensor de imagen especializado.

Sensores CCD

Normalmente son sensores CCD (en lugar de CMOS), pero para nuestro razonamiento es indiferente.

Es un sensor especializado porque no ve una imagen bidimensional, sino que ve una única dimensión.

Imagina que es una fila de celdas fotosensibles.

Cada celda recogerá una cierta cantidad de fotones y generará un valor numérico (de forma similar al funcionamiento del sensor de imagen).

Aquí no hay ningún misterio.

Señales en fase – Autocorrelación

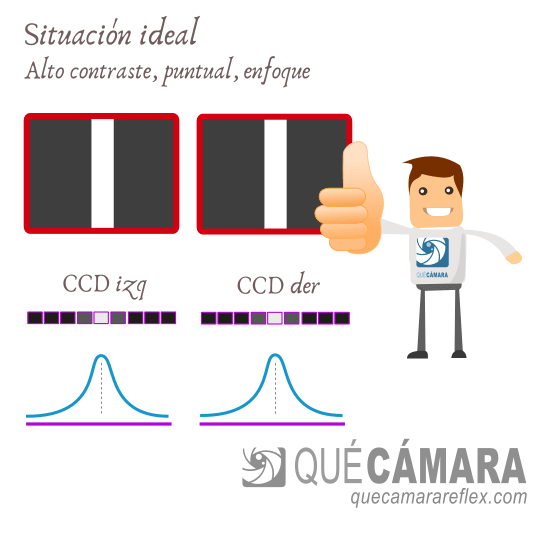

Imagina que tenemos ajustado el sistema de tal forma que cuando tenemos enfoque perfecto la imagen de cada agujero se proyecta justo en el centro de su sensor correspondiente.

Hemos elegido una configuración horizontal. Un sensor (y agujero) a la izquierda y el otro a la derecha, separados por una cierta distancia.

Y aunque en el dibujo utilizo como referencia un objeto naranja, vamos a suponer inicialmente que estamos tratando de enfocar una cartulina negra con un punto blanco en su centro.

Tenemos el punto de enfoque justo sobre el punto blanco.

Bajo esas condiciones, cada sensor verá una imagen de ese punto blanco, situada justo en su centro.

NOTA: Nuestro sistema de juguete no utiliza lentes adicionales, así que en este caso los sensores CCD ven una versión borrosa del punto, desenfocada, incluso cuando la imagen estaría enfocada en el plano del sensor (de imagen). Esto es anecdótico y no influirá en nuestro razonamiento. He dibujado una señal del sensor con forma de lóbulo para indicar que no es un punto perfecto. En una situación del día a día con escenas reales tampoco se van a generar señales perfectas.

Lo importante aquí es que la imagen del CCD de la izquierda es exactamente igual que la del CCD de la derecha.

O al menos tienen una correlación muy alta.

La correlación nos da una idea del parecido entre dos señales.

Si las dos señales son exactamente iguales (forma y posición) decimos que están en fase.

Fuera de fase / desenfoque

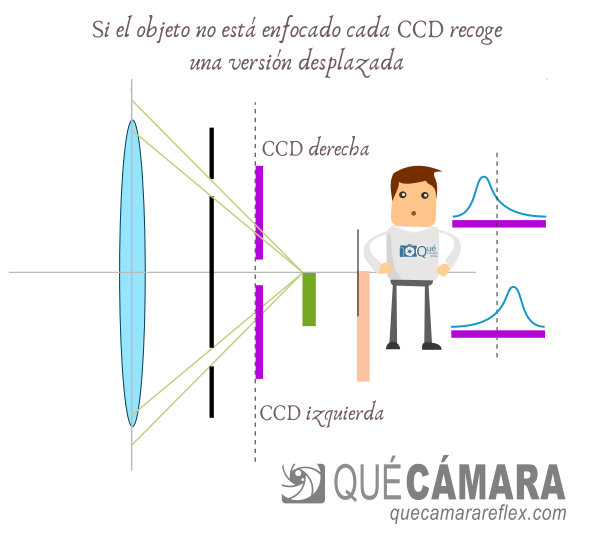

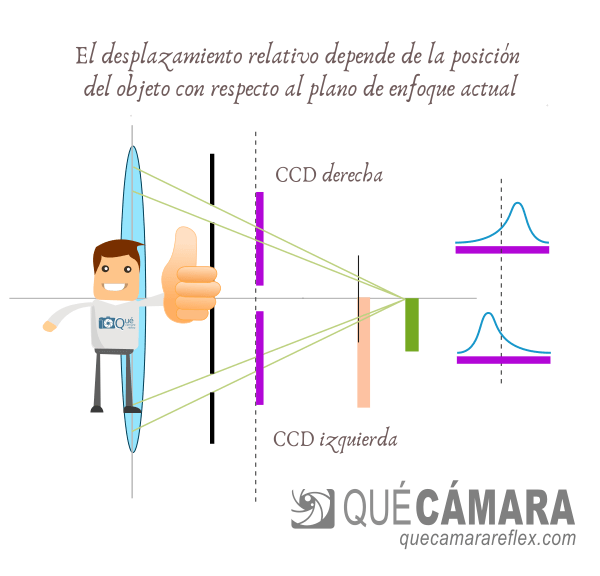

¿Qué ocurre si movemos el objeto que teníamos enfocado?

Es decir, si ponemos el objeto más alejado del plano de enfoque actual o si lo ponemos por delante de dicho plano.

Para verlo más claro he dibujado la imagen que proyectaría un objeto verde, que está por detrás del objeto naranja que nos sirvió como referencia para enfocar inicialmente.

Pero como antes, para facilitar la interpretación de las señales, imagina que en la base de ese objeto hemos colocado una cartulina negra con un punto blanco en el centro, que es la zona que trataremos de enfocar.

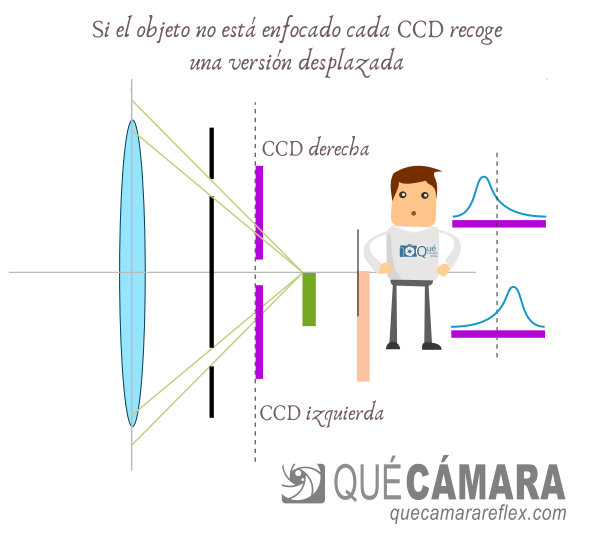

Por geometría podemos ver que las imágenes del punto blanco que ven los sensores CCD se desplazan con respecto al centro (forzadas por los agujeros de la máscara).

Las señales que generan ahora los sensores ya no están en fase.

Como teníamos el sistema calibrado para la situación de enfoque, sabemos que ahora estamos apuntando a algo que no está en la posición del plano de enfoque actual.

Lo más importante de esta técnica es que analizando las señales de los sensores podemos saber si el objeto está por delante o por detrás del plano de enfoque.

Y también tenemos la posibilidad de triangular la distancia exacta: por lo tanto sabemos en qué dirección tenemos que mover la lente de enfoque y cuánto tenemos que moverla.

Esto último (estimación de distancias) puede ser más complejo porque las pequeñas diferencias de fase habría que trasladarlas a diferencias en ángulos por ejemplo y luego aplicar trigonometría, y luego determinar para cada objetivo el recorrido de las lentes de enfoque, etc.

Pero incluso sin hacer esto, nuestro sistema de juguete podría ir desplazando simplemente la lente en la dirección correcta, a velocidad constante si es necesario, hasta llegar al punto en que la diferencia de fase se anula.

Además, cuando las señales están en fase sabemos a ciencia cierta que hemos llegado al enfoque perfecto. No hace falta llegar por prueba y error como ocurre con los sistemas basados en detección por contraste.

Receta para hacer en casa

Se puede probar perfectamente cómo funciona esta visión binocular resultante al colocar una máscara.

Si tienes un objetivo antiguo, con enfoque manual y anillo de apertura manual, puedes hacerte una pequeña máscara con cartulina negra y un par de agujeros pequeños (1 o 2 milímetros de diámetro) situados no muy lejos del centro.

Puedes pegar con un poco de celo la máscara a la parte trasera del objetivo (sin que toque la lente trasera para no ensuciarla o rayarla). Y puedes usar otra cartulina como pantalla de proyección (donde estarían los sensores CCD)

En una escena con mucha luz, por ejemplo si apuntas hacia una lámpara de casa, verás que cuando mueves el anillo de enfoque del objetivo, las imágenes proyectadas por los círculos de la máscara se alejan entre sí o se acercan.

También lo puedes probar fácilmente utilizando la cámara, pero ten cuidado de no dañar nada:

Si tienes una cámara sin espejo, un objetivo analógico antiguo y un adaptador para ese objetivo, puedes colocar la máscara, con un poco de celo, en el interior del adaptador.

Ahora montas el objetivo en tu cámara. Cuando enciendes la cámara verás como dos imágenes solapadas de la escena (necesitarás hacer el experimento con una escena muy bien iluminada, porque la máscara actúa como un diafragma muy cerrado) y también verás posiblemente zonas que están más iluminadas que otras.

Lo importante es que si usas una máscara horizontal (los dos agujeros colocados en horizontal) cuando muevas el anillo de enfoque verás que las dos imágenes solapadas se desplazan lateralmente y llega un momento en que coinciden perfectamente, lo podemos apreciar mejor con las líneas verticales de la escena.

Y si colocas la máscara con los agujeros en vertical, verás que las imágenes solapadas se desplazan verticalmente (lo puedes apreciar mejor con las líneas horizontales de la escena)

Como en este experimento usamos el plano del sensor como referencia, cuando las dos imágenes solapan perfectamente aseguramos el enfoque. Incluso podrías hacer una foto y verías que la zona de la escena donde solapaban perfectamente las dos imágenes aparecerá enfocada.

Lógicamente no es un sistema muy práctico, porque perdemos casi toda la luz y además la máscara crea patrones con zonas más claras y más oscuras.

¿Qué efecto tiene la apertura?

En nuestro sistema de juguete no hemos tenido en cuenta la apertura.

Pero fíjate por ejemplo en este esquema que habíamos visto en el apartado anterior:

Al proyectar hacia atrás los rayos que pasan por los agujeros de la máscara vemos que vendrían desde fuera de la lente.

Nos daba igual porque en el sistema de juguete supusimos una lente ideal, con un diámetro enorme si hace falta.

En el mundo real no ocurriría eso.

El ángulo de los rayos de luz que llegarán a cada sensor de enfoque está limitado por la apertura efectiva del objetivo.

Los rayos que superan un determinado ángulo nunca llegarían al sensor CCD y por lo tanto sería mucho más difícil conseguir una señal válida, que pueda servir realmente a los algoritmos que las analizan.

La apertura del objetivo nos va a limitar de varias formas:

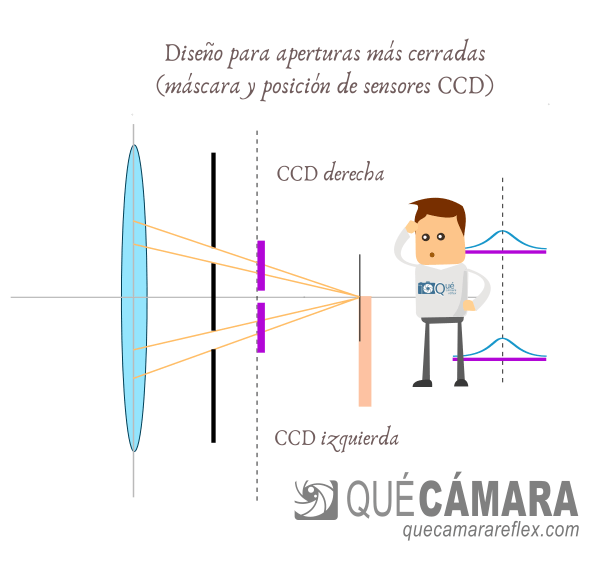

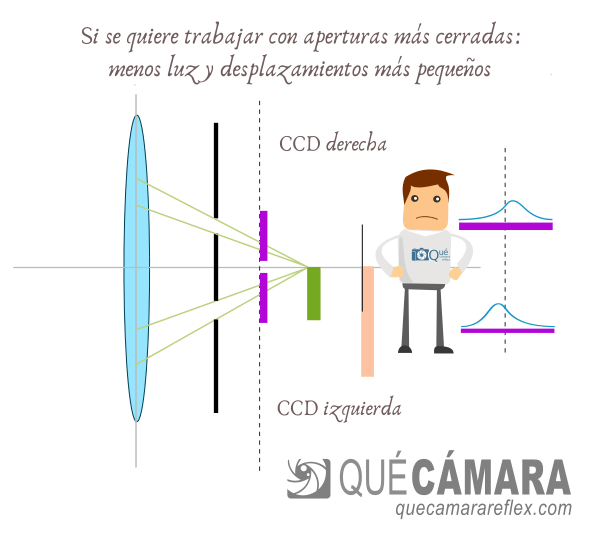

- Por una cuestión geométrica: una menor apertura implica que no podremos usar los rayos más externos, la diferencia de fase entre las señales será más pequeña y difícil de medir, y que tendremos que hacer todos los cálculos con ángulos más estrechos (márgenes de error más altos a la hora de triangular una distancia)

- Por una cuestión de cantidad de luz: menor apertura implica que llegará menos luz a cada sensor CCD, la señal será más débil y será más difícil encontrar la correlación (el desfase) entre la pareja de sensores.

En el diseño de una cámara se tiene en cuenta cuáles serán las aperturas mínimas para las que se garantiza una cierta precisión en el enfoque.

Si diseñamos para aperturas más cerradas, los agujeros de la máscara tienen que estar más juntos entre sí.

Y como hemos comentado, trabajando a aperturas más cerradas cabe la posibilidad de que llegue menos luz.

Pero lo más importante es que con los CCDs más próximos entre sí se pierde precisión a la hora de ver las diferencias de fase y de estimar las distancias.

Muchas cámaras réflex tienen puntos de enfoque que están limitados a f/5.6

Eso quiere decir que por ejemplo un objetivo con apertura máxima de f/6.3 no funcionaría correctamente, al menos sobre el papel. Luego hablaremos más sobre esto.

Las cámaras réflex especializadas en fotografía deportiva, de animales salvajes, acción, etc. suelen incluir puntos de enfoque que pueden operar de forma efectiva hasta f/8.

¿Qué hace una cámara para enfocar?

Una estrategia habitual es que la cámara intente enfocar utilizando la máxima apertura posible que tenga el objetivo, o al menos una apertura suficientemente grande. La estrategia depende mucho de cada fabricante e incluso del modelo de cámara, pero vamos a quedarnos con esa idea de partida.

Por ejemplo, imagina que tenemos un objetivo 50mm f/1.8

Estamos en una escena en la que nos interesa configurar una apertura más cerrada, por ejemplo f/11.

Cuando pulsamos para enfocar y disparar en una réflex:

- La cámara le indica al objetivo que abra a máxima apertura

- El objetivo en este caso abre a f/1.8 (su máxima apertura)

- Se realiza el cálculo de correlación / fase y se dan instrucciones al motor de enfoque del objetivo hasta encontrar la correlación máxima: se alcanza la posición de enfoque.

- La cámara determina que se ha adquirido el enfoque (y por ejemplo lo marca en el visor, o lo anuncia con un pitido, etc.)

- El objetivo cierra a su apertura de trabajo, la que habíamos configurado nosotros para esta escena: f/11

- Se levanta el espejo y la imagen queda proyectada en el plano del sensor (si se utiliza obturador mecánico, todavía está cerrado y no llega la imagen al sensor)

- Se abre el obturador el tiempo programado

- Se obtiene la foto

Además, en las réflex es importante que el visor óptico reciba toda la luz posible de la escena (porque sería muy incómodo encuadrar sin ver apenas la escena cuando usamos aperturas cerradas), así que normalmente el diafragma permanece abierto al máximo todo el tiempo, excepto en el instante de hacer la foto.

Módulo de enfoque por detección de fase

Vamos a dejar aparcado el sistema de juguete y vamos a pensar ya en un sistema más realista.

El principio de funcionamiento es el mismo.

En un sistema real, detrás de cada agujero de la máscara hay una lente que se encarga de dirigir (enfocar, por decirlo de alguna forma) la imagen hacia el centro de su sensor CCD.

También es necesaria una lente adicional para corregir efectos no deseados en los puntos de enfoque que están fuera del eje óptico principal (p.e. para los puntos de enfoque que están fuera del centro).

En un sistema real hay bastantes puntos de enfoque.

Así que imagina la complejidad que tiene que tener un módulo de enfoque real: las máscaras para cada pareja de sensores, los sensores en sí, colocados en una determinada posición en la superficie del chip, etc.

Y todo eso tiene que ir encapsulado en un módulo pequeño, que quepa en la parte inferior de la cámara.

Además hay que colocar una serie de espejos adicionales para llevar la imagen proyectada por el objetivo hacia la zona del módulo de detección de fase: el espejo secundario, que normalmente está situado debajo del espejo principal de la réflex. Y a veces hay un tercer espejo para acomodar mejor la óptica del módulo de enfoque.

Funcionamiento del sistema real

El principio es el mismo que el que hemos visto en el detector de enfoque de juguete.

Vamos a ir viendo una serie de casos que nos servirán para entender un poco mejor el comportamiento.

Imagina que tenemos una cámara con 5 puntos de enfoque.

Tenemos activado el punto de enfoque central (en muchas cámaras es el que tiene las mejores características de sensibilidad y precisión).

Desde nuestro visor elegimos el elemento de la escena que queremos enfocar y apuntamos con el punto de enfoque central.

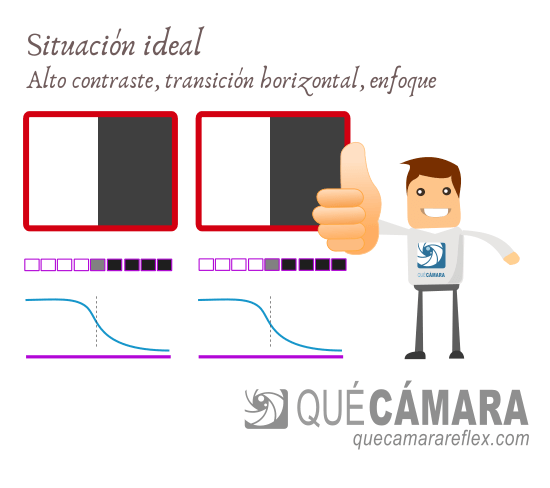

Si nuestro sistema de enfoque utiliza pares de sensores colocados en horizontal (izquierda / derecha), el mejor caso posible es cuando la zona que intentamos enfocar tiene una transición horizontal de alto contraste (por ejemplo un borde vertical muy destacado)

Situación ideal para el detector

Vamos a imaginar que tenemos una cartulina negra con una línea vertical blanca. Desde el punto de vista de los sensores CCD se trata de un punto blanco (un pico de señal), ya que sólo ven en una dimensión.

Un caso mucho más habitual sería un borde. Algún tipo de textura en la superficie del objeto que implica una transición de alto contraste:

Fíjate que esa señal ya no es tan clara, no es un pico. Es una transición, una especie de escalón entre valores claros y valores oscuros.

Pero igualmente, cuando el objeto está enfocado el algoritmo de correlación dará un valor muy alto. Con este tipo de señales limpias es relativamente fácil determinar si están en fase.

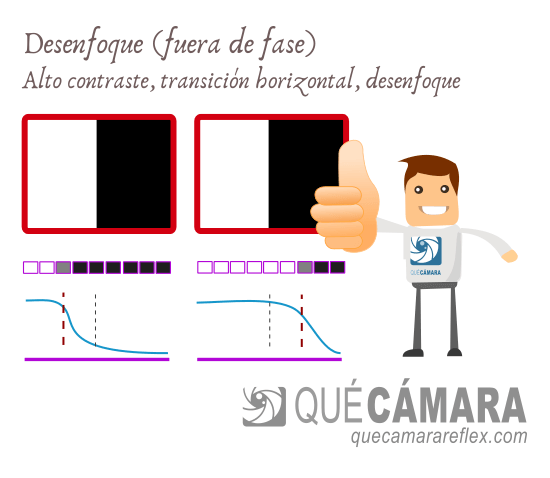

Apuntamos a un elemento desenfocado

Imagina que ahora nos movemos nosotros con respecto al objeto que estaba enfocado o que apuntamos a otro objeto de la escena, situado a una distancia diferente.

Vamos a seguir con el ejemplo de transición de alto contraste.

Para esa zona de la escena, lo que veríamos a través del visor (y lo que verían los sensores CCD) estaría desenfocado, pero voy a seguir dibujando la transición de alto contraste, para dar a entender que forma parte de la textura del objeto.

Como apuntamos hacia una zona fuera del plano de enfoque, las señales se desplazan para cada sensor, como habíamos visto (y también se ensancharán debido a que corresponden a una imagen no enfocada).

Pero también es relativamente sencillo calcular la correlación entre las dos señales, detectar la transición (el escalón) y evaluar la diferencia de fase.

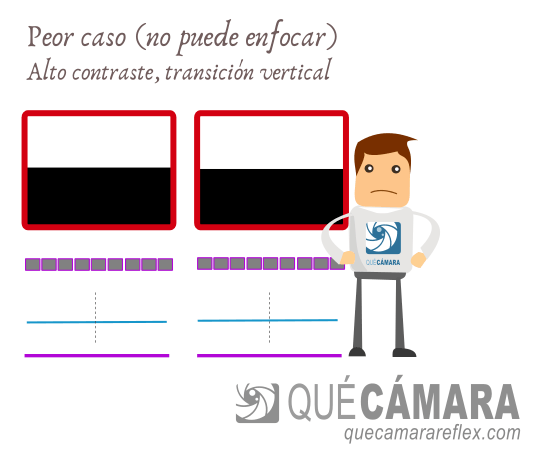

Fallo del sistema

El peor escenario para esa pareja de sensores sería una zona de la escena totalmente homogénea, sin ningún tipo de textura, bordes, etc.

Y lo mismo ocurriría con este sistema para una escena con transiciones verticales de contraste (bordes horizontales).

En esos casos los sensores van a generar una señal muy plana.

Y el algoritmo será incapaz de saber qué tiene que hacer para enfocar y tampoco sabrá cuándo ha llegado a la situación de enfoque.

En ese caso la cámara informaría de que no ha podido adquirir el enfoque.

Cuando se usan parejas de sensores horizontales y la escena tiene transiciones de contraste en sentido vertical podemos solucionarlo rotando la cámara, por ejemplo colocándola en posición vertical, haríamos el enfoque sin ningún problema, lo mantendríamos mientras reencuadramos en apaisado, y dispararíamos.

Es un apaño que funciona perfectamente, pero quizás puede resultar algo molesto y podemos perder algunas tomas.

Cross type focus points

Para evitar esto, algunas cámaras incluyen puntos de enfoque de tipo en cruz (cross type focus points), que son en realidad dos parejas de sensores CCD (con su correspondiente máscara con 4 agujeros)

Más abajo veremos en un sistema real cómo están dispuestos los sensores en el chip.

El algoritmo calcula la correlación de las dos parejas y elige la que sea más robusta.

Con este tipo de puntos de enfoque disminuye bastante la probabilidad de fallo de detección.

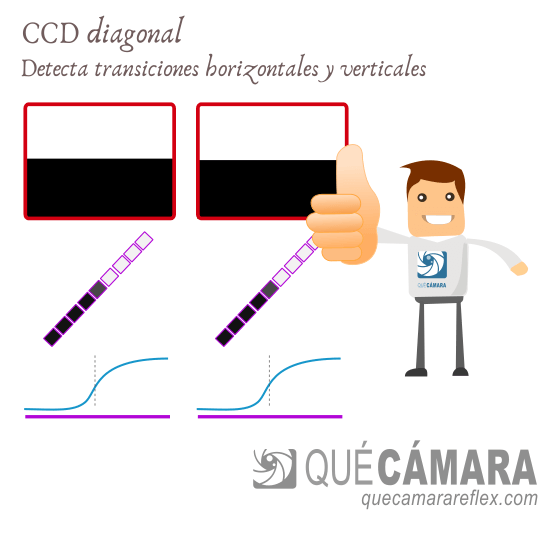

Puntos de enfoque en diagonal

Otra opción consistiría en utilizar sensores CCD colocados en diagonal en el chip.

Una pareja de sensores en diagonal detectaría todas las transiciones horizontales y verticales.

Fallaría en transiciones diagonales de la escena que sean paralelas con respecto a la pareja de CCDs.

Por eso se suelen utilizar como pareja doble formando un sensor de tipo en cruz diagonal: diagonal cross type focus points.

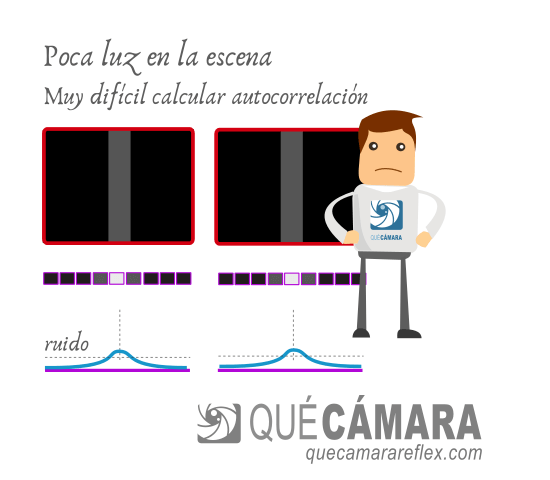

Enfoque con poca luz en la escena

Hemos visto que la cosa se complica cuando encontramos elementos con muy poca textura o muy poco contraste en esa textura (por ejemplo tonos muy homogéneos, superficies muy lisas, etc.)

En esos casos tendríamos unas señales muy poco diferenciadas, muy planas.

Lo mismo ocurre cuando hay muy poca luz en la escena.

El algoritmo que calcula la correlación entre señales y la diferencia de fase tendrá muchos más problemas para hacer sus cálculos: menor precisión, mayor probabilidad de fallo y mayor probabilidad de que la cámara avise de que no ha podido adquirir el enfoque.

En este caso además puede entrar en juego el ruido electrónico asociado a los sensores CCD y su circuitería.

Si el nivel de la señal es muy bajo, del mismo orden que el nivel de ruido del sistema, los algoritmos verán una señal muy alterada por el ruido y serán incapaces de encontrar correlación o encontrarán falsos positivos.

Todos los sistemas tienen muchos problemas para conseguir un enfoque preciso cuando las condiciones de iluminación son malas. Pero los sistemas de enfoque de las réflex son especialmente vulnerables en estas situaciones críticas.

Resolución del sensor CCD

Los sensores CCD tienen una determinada resolución: un determinado número de celdas por unidad de longitud.

Son capaces de captar transiciones de contraste de la escena hasta una determinada frecuencia espacial.

A partir de esa frecuencia, por ejemplo texturas con patrones repetitivos de alta frecuencia, el sensor CCD simplemente ve una señal continua, como ocurriría con un fondo totalmente homogéneo, y el sistema sería incapaz de enfocar.

Hay que tener en cuenta que esa textura estará inicialmente desenfocada desde el punto de vista de los sensores CCD, con lo que habrá perdido toda la información útil, las transiciones de contraste estarán diluidas.

La cámara lo único que puede intentar es un barrido a ciegas (como haría un sistema de enfoque por detección de contraste) para ver si tiene suerte de detectar alguna transición de contraste.

Es decir, a efectos prácticos, la frecuencia espacial del patrón repetitivo tiene que ser bastante más baja (con respecto a ese máximo teórico marcado por la resolución del CCD).

El diseño del sensor CCD es un compromiso entre resolución espacial (más celdas, más pequeñas) y rendimiento con poca luz (celdas más grandes).

Y además en el diseño del módulo completo intervienen muchos más factores, incluyendo las limitaciones del espacio físico.

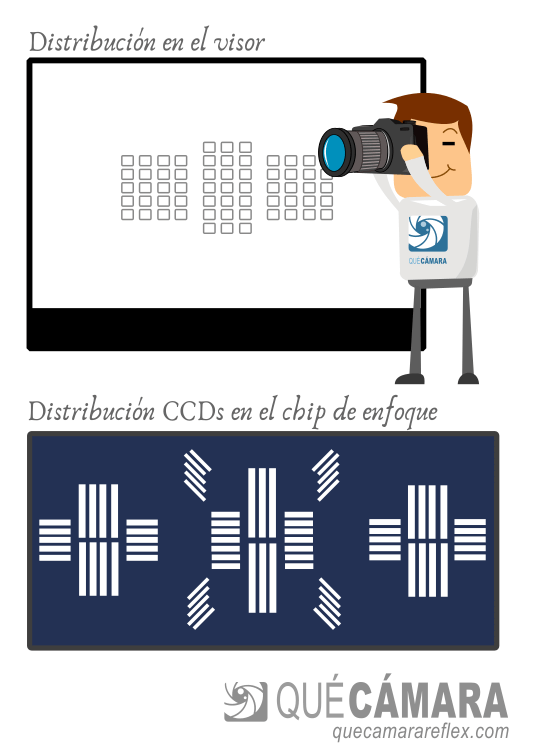

Un módulo de enfoque real, Canon EOS 1D X

Por simple curiosidad, vamos a ver por encima cómo es un sistema real de enfoque por detección de fase.

Este módulo creo que estaba inicialmente en la Canon EOS 1D X y posteriormente en la 5D mark III (o al menos uno similar).

El sistema incluye 61 puntos de enfoque. 41 de ellos son de tipo en cruz (cross type), cada uno de ellos formados por 2 parejas de sensores, una pareja de sensores en vertical y una pareja en horizontal.

Además, 5 de los puntos de la zona central incluyen cuartetos de sensores en diagonal (diagonal cross type) de alta precisión.

Esta es la distribución orientativa de puntos de enfoque en el visor y la distribución de sensores CCD en el chip del módulo de enfoque:

Ten en cuenta que el chip del módulo de enfoque es pequeñísimo, aquí está dibujado muy grande para poder apreciar la distribución de parejas y cuartetos de sensores.

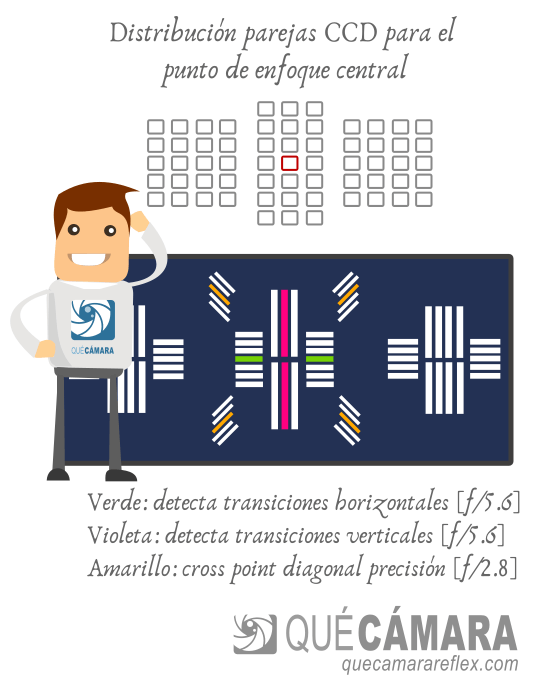

Para que te hagas una idea de la disposición de los sensores nos vamos a quedar con el punto central, ya que incluye los sensores para cross type (horizontal + vertical) y los sensores de tipo diagonal (diagonal cross type) de alta precisión.

En el esquema vienen indicadas las parejas con colores.

El cross type normal está formado por la pareja de sensores verdes: detector horizontal.

… y la pareja de sensores violetas: detector vertical.

Los 4 sensores amarillos forman 2 parejas de detectores diagonales. El cuarteto forma el sensor en cruz diagonal.

La separación entre los sensores de cada pareja determina la precisión y también limita la apertura mínima que se necesita para operar correctamente.

Por ejemplo, los 4 sensores amarillos están muy separados entre sí y ofrecen una precisión más alta (permiten triangular con menor margen de error). Pero sólo pueden funcionar con objetivos que tengan una apertura máxima igual o mayor a f/2.8 (f/2.8, f/2, f/1.8, etc.)

Algunos de los sensores horizontales de los grupos laterales (más separados del centro) están limitados a f/4 o mayor.

Y todas las demás parejas de sensores están limitadas a f/5.6 o mayor.

Algunos CCD son compartidos por varios puntos de enfoque.

Por ejemplo, la pareja de sensores violeta es compartida por todos los puntos de enfoque de la columna vertical central.

Cuando activamos un determinado punto de enfoque, el sistema leerá de la combinación de parejas de CCDs que tenga asignada para ese punto.

Los 5 cuartetos de sensores diagonales están asignados a los 5 puntos de la columna vertical central.

Funciones avanzadas: enfoque por zonas

En la mayoría de las cámaras réflex modernas existe la posibilidad de configurar modos de enfoque por zonas.

Cada zona agrupa una serie de puntos de enfoque y los algoritmos de la cámara se encargan de decidir en cada momento qué puntos tendrán preferencia a la hora de determinar el enfoque.

Esto es muy importante por ejemplo en fotografía deportiva, fotografía de aves y animales salvajes, etc. para poder hacer el seguimiento de objetos que se mueven muy rápido.

Toda esta parte computacional depende sobre todo de la potencia de cálculo del procesador principal de la cámara.

Y las cámaras réflex de gama alta de las últimas generaciones incluyen funciones increíblemente complejas y efectivas.

Una limitación de este sistema es que realmente los sensores reciben una información muy pequeña de la escena. La capa de software que se encarga de analizar estas señales tiene muy complicado implementar funciones de reconocimiento por ejemplo (reconocimiento de caras, ojos, etc.)

Esa parte de análisis y reconocimiento es mucho más sencilla y efectiva trabajando sobre la imagen completa de la escena proporcionada por el sensor de imagen de la cámara, como ocurre con los sistemas híbridos que integran el enfoque automático en el sensor de imagen.

¿Puede usar mi cámara objetivos con poca apertura máxima?

Este caso se da bastante con teleobjetivos.

Los teleobjetivos ‘asequibles’ suelen tener aperturas máximas bastante justitas.

Por ejemplo, piensa en un 150-600mm f/5.6-6.3, que es un tipo de objetivo muy utilizado en fotografía de aves y fauna salvaje por su relación calidad precio.

Por otro lado, las cámaras réflex de gama media y algunas cámaras de gama alta de propósito general incluyen puntos de enfoque limitados a f/5.6

Los modelos especializados en fotografía deportiva suelen incluir puntos de enfoque (al menos en la zona central) limitados a f/8. Estas cámaras no habría ningún problema.

La ley…

Algunos fabricantes incluyen en sus cámaras instrucciones para deshabilitar el sistema de AF si detecta que el objetivo actual no alcanza al menos la apertura máxima que necesitan sus sensores de enfoque.

A esto se le suele conocer como el corte de AF (AF cut).

Vamos a poner un ejemplo para entenderlo. Imagina que tienes una cámara réflex de Canon con sensores de enfoque limitados a f/5.6

Si la cámara detecta que el objetivo actual no puede abrir al menos a f/5.6: desconecta el sistema AF principal y sólo podríamos usar el objetivo en manual o podríamos usar la cámara en modo LiveView, con el sistema de enfoque que esté integrado en el sensor de imagen (detección por contraste en el peor de los casos).

¿Motivos?

Motivo comercial: si quieres usar ese objetivo, compra uno de mis modelos de cámara de gama superior…

Motivo comercial: si quieres usar esa cámara, compra uno de mis objetivos de gama superior…

Por temas de imagen de marca: si usas esos objetivos y el sistema de enfoque falla mucho, le vas a echar la culpa a mi cámara… y eso genera mala imagen. Así que desactivo el sistema AF.

Y la trampa…

Los objetivos fabricados por terceras marcas, por ejemplo objetivos Sigma, Tamron, etc. diseñados para cámaras réflex de Canon o Nikon, incluyen en sus protocolos de comunicación con la cámara una pequeña triquiñuela para hacer creer a la cámara que se trata de objetivos que pueden abrir diafragma hasta f/5.6

Eso evita el corte de AF por parte de la cámara y el objetivo funciona perfectamente.

¿Qué rendimiento de AF tienen esas combinaciones cámara-objetivo?

Las parejas de sensores con límite en f/5.6 tienen margen suficiente para operar perfectamente con aperturas un poco más cerradas.

Entre f/5.6 y f/6.3 sólo hay un tercio de paso de luz. En la práctica la diferencia es mínima.

Lógicamente una cámara más especializada, con sensores que pueden operar a f/8, tendrá mucho más margen y la tasa de aciertos será superior.

Además, cuando las condiciones de luz empeoren un poco, los sensores con límite en f/5.6 van a notarlo un poco más. Sus señales ya están un poco deformadas por el tema geométrico de la apertura, y con menos luz aumentará un poco más la probabilidad de fallo.

Pero en condiciones normales la combinación de cámara y objetivo será totalmente operativa.

Así que puedes usar perfectamente ese tipo de objetivos en tu cámara réflex de gama media o de entrada.

Si con el tiempo te especializas en ese tipo de fotografía probablemente te interesará sustituir tu cámara actual por un modelo más especializado: por este tema del límite de apertura y porque su módulo de enfoque será más avanzado.

Dentro de las réflex, en Canon serían por ejemplo las 7D, la 90D, o la serie 1D.

En Nikon serían por ejemplo las cámaras de la serie D7000, la D500, la serie de un dígito, por ejemplo la D6.

Resumen del sistema de enfoque por detección de fase

Recuerda que nos estamos centrando en los sistemas de enfoque dedicados de las cámaras réflex (el enfoque que funciona cuando estamos usando el visor óptico)

Características positivas

- Muy rápido, porque el sistema sabe hacia dónde se tienen que mover las lentes de enfoque y cuándo se llega a un enfoque ‘perfecto’ (señales en fase, alta correlación)

- Muy preciso

- Muy buena opción para seguimiento de objetos en movimiento. El sistema tratará de mantener la fase de una forma continua y sin focus hunting.

Ésas creo que serían sus principales virtudes.

Sobre todo la velocidad.

Si las condiciones son adecuadas es un sistema que funciona muy muy bien, y por lo tanto se ha estado usando en todas las cámaras réflex digitales.

Características menos positivas

- Muy complejo.

- Utiliza como referencia una imagen que está situada en un plano diferente del plano del sensor. Todo tiene que estar calibrado perfectamente para que las dos partes se entiendan, de lo contrario todas las imágenes aparecerán desenfocadas en el plano del sensor.

- Por el motivo anterior: para cada objetivo el comportamiento puede ser un poco diferente, con lo que puede haber problemas de micro ajuste (front focus, back focus…)

- Es bastante dependiente de la cantidad de luz de la escena, necesita cierta cantidad de luz mínima y cierto contraste para operar correctamente.

- Los sensores sólo son efectivos en la zona central del encuadre. No son efectivos hacia las esquinas. Por ese motivo las réflex, aunque tengan muchos puntos de enfoque, los tienen en la parte más central del encuadre.

- Es un sistema muy preciso, pero no tan preciso como el enfoque por detección de contraste (dependiendo de la situación, escena, etc.) En la detección por contraste se utiliza la imagen captada por el propio sensor de imagen y los algoritmos pueden determinar cuándo se alcanza el máximo contraste. En la detección de fase una correlación alta no implica el enfoque perfecto.

- El sistema ‘réflex’ no se puede usar para vídeo, ya que en vídeo el espejo está siempre levantado.

- Es muy complicado añadir al sistema una capa computacional ‘inteligente’, por ejemplo para reconocimiento de cara, reconocimiento de ojos, etc.

Visto así parece un sistema con más defectos que virtudes, pero hay que tener en cuenta que sus virtudes (velocidad) compensan de sobra en la mayoría de las situaciones que encontramos en fotografía.

Sistemas de enfoque híbridos

La evolución natural es integrar el sistema de enfoque por detección de fase en el propio sensor de imagen de la cámara.

Algunas celdas del sensor de imagen se utilizan exclusivamente para realizar detección de fase, en combinación con otras celdas distribuidas por el sensor para conseguir una triangulación precisa.

Este sistema PDAF aporta la velocidad de respuesta y las ventajas en la parte de seguimiento.

Sobre esa capa PDAF opera el sistema de enfoque por detección de contraste y por encima están todos los algoritmos de reconocimiento (caras, ojos, objetos…) y predicción de movimiento.

Aunque son sistemas complejos, se elimina toda la complejidad que suponía operar en un plano diferente al del sensor de imagen.

Trabajando en el plano del sensor no puede haber problemas de micro ajuste (front focus / back focus) porque se utiliza como referencia la misma imagen óptica que luego se utilizará para generar la imagen digital.

Más información y referencias

- Autofocus Systems Part II, by Exclusive Architecture (Markus Kohlpaintner)

- Enfoque PDAF integrado en el sensor de imagen

- Cómo funciona el sistema de enfoque Dual Pixel