¿Cómo funcionan los sistemas de enfoque automático por detección de fase integrados en el sensor de imagen?

En un artículo anterior vimos el principio de funcionamiento de los sistemas de enfoque por detección de fase que utilizan un sensor especializado (diferente del sensor de imagen de la cámara).

También vimos qué ventajas e inconvenientes tenía ese sistema.

La principal ventaja es la velocidad de enfoque.

Pero también tenía algunas desventajas.

La principal desventaja, al menos desde mi punto de vista, es que este módulo utiliza como referencia un plano de imagen independiente del plano de imagen del sensor. Por decirlo de alguna forma: el módulo de enfoque ve una imagen de la escena que llega por un camino independiente de la que ve el sensor de imagen.

Eso implica que hace falta un ajuste muy fino para que el módulo de enfoque y el sensor de imagen estén perfectamente sincronizados. Cualquier mínimo desajuste hará que la cámara tenga problemas de front-focus / back-focus. Es decir, el módulo de enfoque estará enfocando en un punto, pero el sensor de imagen estará viendo una imagen ligeramente desenfocada justo en ese punto de la escena.

Hay otros muchos inconvenientes: complejidad de todo el sistema, es muy difícil colocar sobre ese sistema una capa adicional de software de reconocimiento de imágenes, en las réflex ese sistema no funciona en vídeo, etc.

Si se pudiera integrar de alguna forma ese sistema en el sensor de imagen se solucionarían muchos de esos inconvenientes…

Y es lo que se ha ido haciendo progresivamente a lo largo de los años.

Así que vamos a ver cómo se puede hacer esto.

Detección de fase – PDAF

En el artículo sobre PDAF en las réflex ya comenté cómo es el principio de funcionamiento básico de estos sistemas (recomiendo que lo leas si no lo has hecho previamente, porque entenderás mejor lo que viene a continuación).

A modo de resumen:

PDAF se basa en recoger la información de al menos dos puntos de vista diferentes de la escena (a modo de paralaje).

Nuestros ojos funcionan así para determinar la distancia de objetos cercanos: el ojo derecho y el ojo izquierdo tienen cada uno un punto de vista diferente de la escena. El cerebro combina la información para generar una única imagen, y además puede estimar la distancia a los objetos (cercanos) de la escena.

El módulo de enfoque hace básicamente lo mismo.

Compara la información de la imagen que le llega desde un punto de vista (por ejemplo de la izquierda), con la información de la imagen que le llega desde el otro punto de vista (por ejemplo de la derecha).

Si la zona de la escena que queremos enfocar está realmente enfocada, las dos versiones de la imagen (de esa zona de la escena) casan perfectamente. Están en fase.

Cuando la zona no está enfocada, cada versión de la imagen estará ligeramente desplazada: tendrán un desfase espacial entre sí.

La principal ventaja es que midiendo ese desfase se puede saber en qué dirección tenemos que mover el objetivo (la lente de enfoque o lo que corresponda) y si estamos muy alejados o muy cerca del punto de enfoque óptimo.

Un único punto de vista

Hay un pequeño problema: la detección de fase necesita (al menos) dos puntos de vista, y las cámaras sólo tienen un punto de vista de la escena en cada instante.

Sólo hay un objetivo y sólo hay un sensor de imagen. El sensor sólo ve una versión de la escena, un único punto de vista.

El módulo de enfoque de las cámaras réflex utiliza un sistema muy ingenioso para conseguir los dos puntos de vista:

- Utiliza una máscara opaca con dos agujeros relativamente separados entre sí

- Detrás de cada agujero está colocado un sensor (como un sensor de imagen pero más simple y más especializado)

Es una forma de colocar dos ‘ojos’, cada uno de los cuales ve una versión de la escena: izquierda y derecha (o arriba y abajo, diagonal, etc. dependiendo de la colocación de la máscara y los sensores)

¿Máscaras en el sensor de imagen?

Si lo pensamos, como idea loca, podríamos hacer un sistema similar utilizando el sensor de imagen.

Colocamos una máscara con dos agujeros delante del sensor justo en el momento de realizar el enfoque (podría ser por ejemplo una cortinilla similar a la del obturador).

Podríamos usar la zona de imagen justo detrás de cada máscara para comparar entre sí y estimar el desfase (como hace el módulo de enfoque de las réflex).

Y luego retiraríamos la máscara en el momento de hacer la foto…

Vale, este sistema tiene algunos pequeños (grandes) inconvenientes: mientras enfocamos perdemos la visión de la escena, no se podría usar para vídeo, añade mucha complejidad mecánica, etc.

Así tal cual es un desastre de sistema de enfoque.

Pero ahora veremos que no vamos muy desencaminados…

El efecto de las microlentes en los sensores de imagen

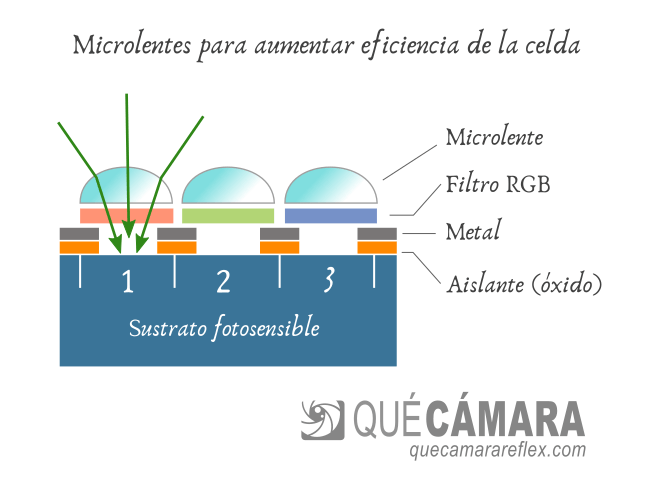

La mayoría de los sensores incluyen en su diseño una capa de microlentes que permiten aumentar la eficiencia de cada celda.

Aquí tienes más información sobre el funcionamiento de los sensores de imagen.

Cada microlente permite concentrar la luz que corresponde a ese punto de la imagen y la hace llegar a la parte activa de la celda, la parte fotosensible.

Sin la lente, una parte de la luz se dispersaría por la superficie no fotosensible de la celda (circuitería, etc.) y no contribuiría a la formación de la imagen. Los sensores sin microlentes suelen tener una eficiencia de conversión menor.

Las microlentes tienen además un efecto secundario interesante.

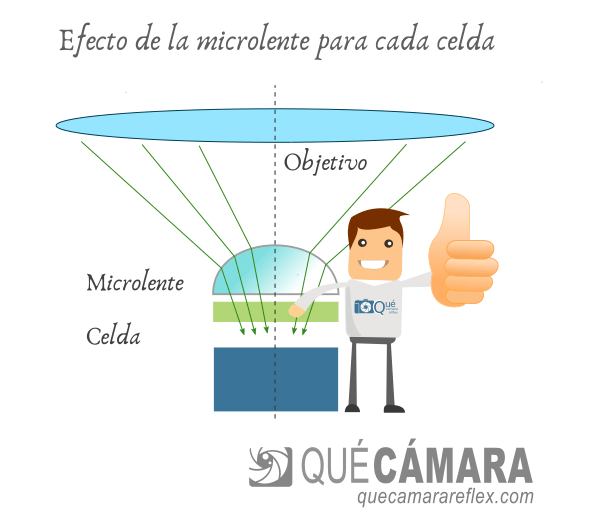

Vamos a centrarnos por un momento en una de las celdas, con su propia microlente, y vamos a imaginarla como un sensor de imagen independiente.

En la imagen está muy exagerado a propósito, para visualizar el concepto. Lógicamente la microlente y la lente principal que representa al objetivo no están a escala.

Debido al efecto de la microlente, la ‘imagen’ que se proyecta en ese pequeño sensor conserva de alguna manera algo de información sobre el ángulo de entrada de los rayos que convergen sobre ese punto.

Ahora es cuando volvemos a la idea loca de la máscara…

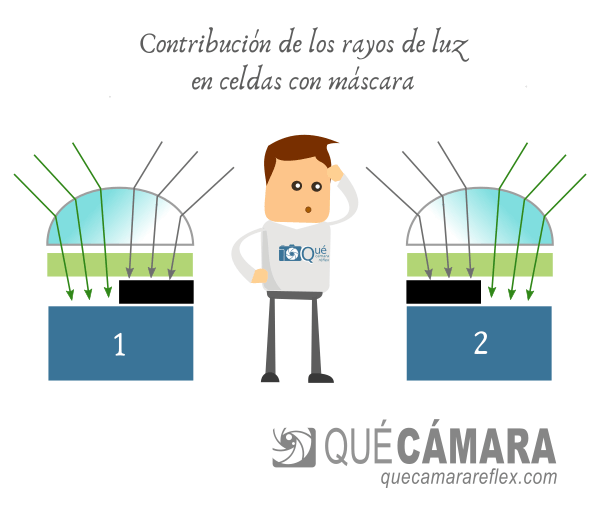

¿Qué ocurre si colocamos una pequeña máscara opaca sobre una de las mitades de la celda?

Por ejemplo tapando la parte derecha, la contribución de la luz que viene de la parte izquierda del objetivo será más importante.

Si tapamos la parte izquierda de otra celda ocurrirá lo contrario, en esa celda la contribución de la luz que llega desde la parte derecha será mayor.

El efecto sería similar a tapar la mitad derecha o la mitad izquierda de la entrada del objetivo.

Tenemos una pareja de celdas especializadas, que nos recuerdan de alguna manera a las parejas de detectores CCD que utilizan los módulos de enfoque de las cámaras réflex.

Cada una de esas celdas ‘ve’ una versión ligeramente diferente de ese punto de la escena.

La clave está en las microlentes

De todo lo que voy a comentar en el artículo, creo que lo más importante es quedarse con la idea de que todo esto funciona por el efecto de la microlente sobre la celda.

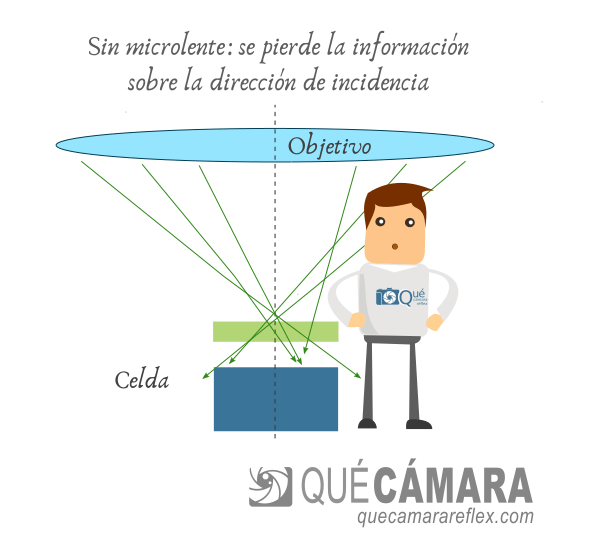

Si no hubiera microlente (como ocurría en los sensores más antiguos) la superficie fotosensible de la celda simplemente integra toda la luz que llega a ese ‘pixel’, y se pierde cualquier tipo de información sobre la dirección de entrada de la luz.

Y el otro punto clave es que debajo de esa microlente tiene que haber alguna forma de discriminar o de separar la luz según la dirección (o ángulo si lo quieres ver así) con que llega desde el objetivo.

Una celda normal del sensor, cada celda individual con su propia microlente, no puede capturar tampoco información de fase (porque integra toda la luz por igual).

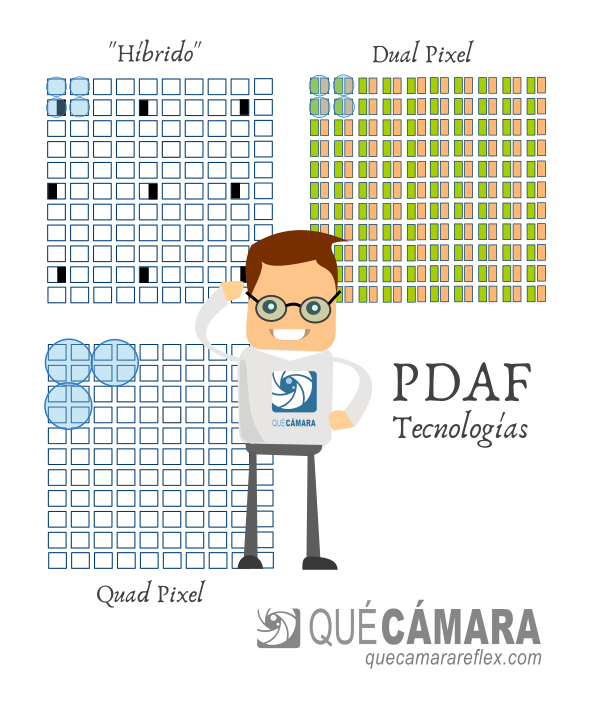

Hay varias técnicas para discriminar o recoger esa información:

- Hemos visto la técnica de enmascarar la mitad de la celda por parejas

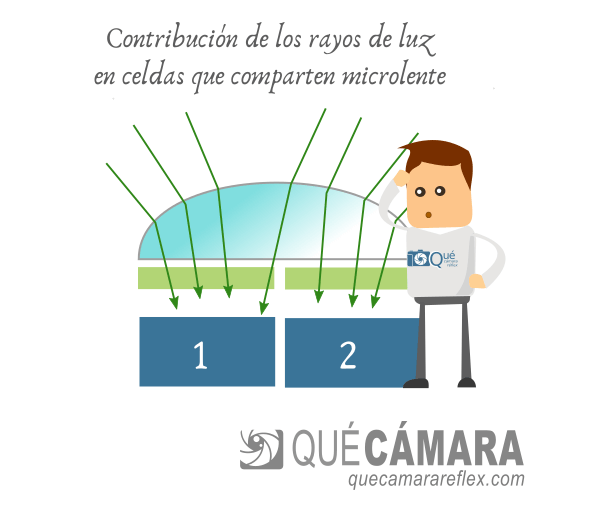

- Se pueden agrupar dos celdas (completas) dentro de una misma microlente, que sería equivalente a tener una celda ‘izquierda’ y una celda ‘derecha’ adyacentes

- Se puede dividir cada celda en dos subceldas (subcelda izquierda – subcelda derecha) como en el sistema Dual Pixel

- Se pueden agrupar más celdas debajo de una microlente, como en los sistemas Quad Pixel

- …

Éste sería un ejemplo de celdas especializadas (celdas AF) que comparten una única microlente:

En la figura anterior también quiero representar el hecho de que cada parte recibe también una pequeña contribución del lado opuesto. Lo importante aquí es que hay una contribución neta diferente entre las celdas ‘derecha’ y las celdas ‘izquierda’.

De momento vamos a seguir con nuestro ejemplo de celdas enmascaradas, pero el principio de funcionamiento es el mismo en todos esos casos.

Matriz de celdas con máscara

Tenemos todavía un problema: cada celda es en realidad un sensor de 1 pixel, con lo que no nos sirve para determinar nada útil.

Piensa que sería como una única celda de un sensor CCD lineal de los que se utilizan en los módulos PDAF de las cámaras réflex.

Con una pareja de celdas no podemos determinar desfase de ningún tipo porque la señal no tendría resolución espacial.

Es como comparar dos imágenes de un pixel cada una: es imposible determinar algún tipo de correlación espacial, y es imposible detectar que una esté desplazada (desfasada) con respecto a la otra.

Para que esta idea funcione necesitamos un grupo (a ser posible grande) de parejas de celdas ‘enmascaradas’.

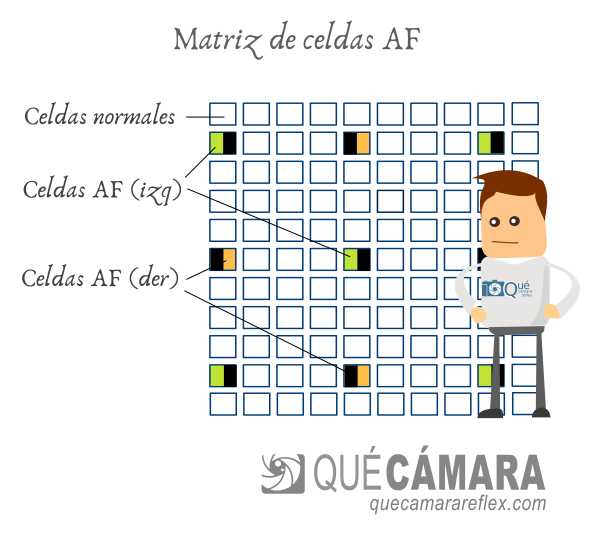

Lo que se hace en los sensores comerciales es integrar una matriz de parejas de celdas especializadas (con su máscara izquierda y derecha), distribuidas de forma homogénea por el sensor.

Cuando elegimos un punto de enfoque en la cámara (o mejor dicho, una zona de enfoque), esa zona incluye un grupo de parejas de celdas especiales, con máscara o con la técnica que corresponda, que llamaremos celdas AF para distinguirlas de las celdas normales que se utilizan para generar la imagen final.

Internamente esas celdas AF no tienen nada especial. Son celdas exactamente iguales que el resto de las celdas del sensor.

La única diferencia está en la máscara que se hace ‘crecer’ sobre la mitad de su superficie. El proceso de fabricación es relativamente sencillo (no añade complejidad al proceso normal).

La distribución y características de las celdas AF depende de cada fabricante, modelo de sensor, etc.

Detección de fase con las celdas AF

Vamos a imaginar que queremos enfocar un determinado elemento de la escena.

Elegimos una zona de enfoque en la cámara. Vamos a suponer que es un pequeño recuadro del centro del encuadre.

El sistema de enfoque (el procesador de la cámara por ejemplo) genera dos imágenes diferentes de esa zona de la escena, a partir de la información que le proporciona el sensor.

Una imagen está formada por los píxeles correspondientes a las celdas con máscara en la parte derecha.

Otra imagen está formada por los puntos correspondientes a las celdas con máscara en la parte izquierda.

Son imágenes de baja resolución (comparadas con la imagen normal de la escena), ya que la densidad de celdas AF suele ser relativamente pequeña.

Las dos imágenes se comparan utilizando algún tipo de algoritmo de correlación para determinar su desfase.

Si en lugar de usar imágenes (2D) utilizáramos sólo una fila de celdas especiales, agrupadas según su máscara, tendríamos algo muy similar a las parejas de sensores CCD que incluyen los módulos de enfoque de las cámaras réflex.

Y se podrían aplicar en principio las mismas técnicas de correlación de señales y estimación de la fase. Esos módulos utilizan sobre todo técnicas de análisis de señales (de alguna forma lo podríamos imaginar como un sistema que trabaja con información de una dimensión).

La ventaja de los sistemas que estamos viendo aquí es que pueden trabajar con información de dos dimensiones, es decir, con técnicas de análisis de imagen.

Ejemplo práctico de PDAF integrado en el sensor

Intentar visualizar el comportamiento de estos sistemas a través de esquemas de trazados de rayos o similar es muy complicado (al menos yo no sé cómo hacerlo).

Pero si entendemos el principio básico podemos simular el comportamiento de una forma relativamente sencilla.

Vamos a necesitar:

- Una cámara (que permita enfoque manual)

- Preferiblemente con un objetivo de gran apertura (que configuraremos a su máxima apertura)

- Un trípode o alguna forma de mantener la cámara en un lugar estable

- Un trozo de cartulina negra

Lo vamos a ver todo mejor si elegimos una escena con un fondo homogéneo (p.e. una pared blanca) y un objeto que contraste mucho (p.e. de color negro, podría valer una tira vertical).

O podemos elegir un objeto con letras o símbolos que contrasten bastante.

Yo por ejemplo he elegido una batería negra con letras de color blanco.

Colocamos la cámara en un punto fijo (y no la moveremos).

Ponemos la cámara en enfoque manual y enfocamos al objeto de interés hasta que lo veamos lo más nítido posible, en el centro del encuadre aproximadamente, para facilitar las cosas.

Si utilizas un objetivo con una apertura muy grande (que es lo ideal en este caso) hay que tener en cuenta que la profundidad de campo puede ser muy pequeña. Nos tenemos que fijar siempre en la zona de interés, la que queremos mostrar perfectamente enfocada.

Ahora cogemos la cartulina negra y tapamos la mitad izquierda de la entrada del objetivo (no hace falta sujetar con celo ni nada, se puede colocar simplemente con la mano).

Tapar la parte izquierda del objetivo tiene un efecto equivalente al de un sensor que tuviera todas sus celdas con una máscara izquierda (y con microlentes, claro)

Dependerá de la focal, etc. pero en general la imagen que recibe el sensor no cambiará mucho, se verá un poco más oscura (hemos perdido 1 paso de luz) y con un cierto viñeteo en el lateral.

Hacemos una foto.

Ahora tapamos la mitad derecha del objetivo y hacemos otra foto.

Esta segunda foto correspondería a un sensor en el que todas sus celdas tienen una máscara derecha.

Repetimos el proceso pero con el objeto desenfocado

Movemos el enfoque hacia ‘infinito’. El objeto aparecerá desenfocado en la pantalla de la cámara.

Tapamos la parte izquierda, foto.

Tapamos la parte derecha, foto.

Movemos el enfoque hacia nosotros, hacia la posición de la distancia mínima de enfoque.

Tapamos la parte izquierda, foto.

Tapamos la parte derecha, foto.

Tendremos 6 imágenes, 2 para cada escenario.

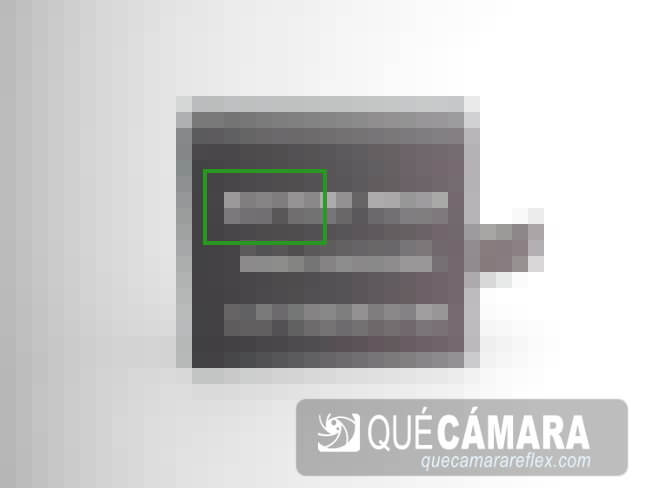

Como en este tipo de sensores la densidad de celdas AF es baja, lo voy a simular pixelando las imágenes.

Eso también nos va a ayudar a identificar mejor el ‘contenido’ de las imágenes y hacernos una idea del desplazamiento relativo.

Escenario 1: objeto enfocado

La primera imagen corresponde a lo que ven las celdas con máscara izquierda.

La segunda imagen corresponde a lo que ven las celdas con máscara derecha.

Recuerda además que nos tenemos que fijar en una zona concreta del encuadre, donde estaría el punto (zona) de enfoque.

Si la zona de interés está perfectamente enfocada, las dos imágenes (dentro de ese recuadro verde) tendrían que coincidir: tendrán una correlación muy alta y un desfase mínimo (idealmente cero).

Si haces el experimento, podría haber pequeñas variaciones porque entre foto y foto puede haber ligeros cambios de iluminación, etc. El sistema real ve las dos imágenes a la vez, con las mismas condiciones.

Además, el sistema sabe que está analizando la misma porción de la escena. Es decir, sabe que las dos versiones representan el mismo objeto de interés.

Escenario 2: desenfoque

En el segundo escenario tenemos el objeto de interés totalmente desenfocado.

La imagen correspondiente a las celdas con máscara derecha (pixelada para simular la resolución que ve el sistema de enfoque):

Y la que corresponde a celdas con máscara izquierda:

Si comparamos el interior del recuadro y elegimos un punto característico:

Vemos que hay un desplazamiento, un desfase espacial, entre las dos imágenes.

He marcado con diferentes colores (verde y rojo) el desplazamiento correspondiente a cada tipo de celda (con máscara derecha: verde, con máscara izquierda: rojo)

Lo que nosotros vemos a simple vista también lo puede ver un algoritmo de análisis de imágenes (pero mucho mejor), por ejemplo calculando la correlación para encontrar el desfase espacial entre las imágenes.

Escenario 3: desenfoque

Imagen desenfocada original:

Imagen correspondiente a las celdas con máscara a la derecha:

Imagen para las celdas con máscara a la izquierda:

Y si volvemos a comparar las dos versiones:

Vemos que efectivamente se vuelve a producir un desplazamiento relativo, pero esta vez en el sentido contrario.

Si la imagen ‘izquierda’ se movía antes hacia la derecha, ahora se mueve a la izquierda y viceversa.

El desfase permite determinar la dirección en enfoque

Como hemos visto, analizando los desplazamientos relativos podemos saber si el desfase es positivo o negativo.

O lo que es lo mismo, la cámara puede saber hacia dónde tiene que mover el enfoque.

Ésta es la principal ventaja de los sistemas PDAF con respecto a los sistemas basados exclusivamente en detección por contraste, que tienen que hacer siempre un proceso de prueba y error para determinar la dirección de enfoque correcta.

El sistema PDAF también puede estimar cuánto recorrido tiene que cubrir (si el desfase es mayor o menor)

Enfoque híbrido integrado en el sensor de imagen

Ya hemos visto cómo funciona el sistema.

En la actualidad, la mayoría de los sensores de imagen de móviles y cámaras (excepto casos como los de Panasonic, que utiliza su propio sistema DFD) incluyen alguna variante de este sistema PDAF integrado.

Canon suele usar su propia versión, el sistema de enfoque Dual Pixel, del que hablaré un poco más adelante.

¿Por qué se llama enfoque híbrido?

Tradicionalmente el sistema PDAF sólo estaba en las cámaras réflex, como un módulo independiente, sin relación con el sensor de imagen.

En las demás cámaras, y en las propias réflex en vídeo o en modo Live View, se utilizaba el sistema de detección por contraste: análisis puro y duro de la imagen de la escena para determinar cuándo alcanza el máximo contraste en la zona de interés.

El sensor de imagen era sinónimo de detección por contraste (que en cámaras antiguas solía ser bastante lento).

Poco a poco se fueron introduciendo las capacidades PDAF en el sensor de imagen.

Era un sistema híbrido, porque combinaba la parte PDAF con la parte de detección por contraste.

Limitaciones de PDAF integrado en el sensor de imagen

Por lo general, las celdas con máscara que forman parte del sistema de enfoque no participan en el proceso de generación de la imagen (foto / vídeo)

Esas celdas suelen estar colocadas estratégicamente en posiciones que corresponden con el filtro verde del mosaico de Bayer, que son las que tienen más redundancia (mosaico RGGB).

En la información RAW de una imagen, ese píxel se interpola a partir de información de las celdas que tiene alrededor (p.e. de su vecino G más próximo)

Si el sensor incluye muchas celdas PDAF estará afectando en cierta forma a la calidad de imagen. Por ejemplo, además de la pequeña pérdida de información de la escena, la distribución de celdas AF puede crear patrones visibles cuando hay cierto nivel de ruido en la imagen.

Si por el contrario incluye pocas celdas AF, el sistema de enfoque tendrá que trabajar con muy poca resolución espacial, y tendrá un rendimiento menor, al menos sobre el papel.

Se suele elegir un compromiso.

Del orden del 2-5% podría ser una cifra orientativa de celdas PDAF con respecto al número total de celdas del sensor.

En la práctica no suele ser algo tan crítico.

Una de las ventajas de la integración PDAF en el sensor de imagen es que se pueden diseñar sistemas realmente complejos (algoritmos) con varias capas, combinando varias tecnologías.

La parte PDAF es importante para determinar la dirección en la que se tiene que mover el enfoque y hacer una estimación de cuánto se tiene que desplazar.

Dependiendo de la resolución espacial y otros factores, es posible que PDAF no tenga suficiente precisión para clavar el enfoque.

Ahí entra en juego la parte de detección por contraste, que puede maximizar la nitidez de la zona de interés.

Y sobre esas capas estaría toda la parte de reconocimiento de imagen: reconocimiento de caras, ojos, animales, objetos, seguimiento, etc.

Otra limitación es que estos sistemas híbridos necesitan una elevada potencia de cálculo.

El procesador tiene que llevar a cabo un procesamiento de imagen bastante intenso, sólo para el sistema de enfoque.

Los sistemas de enfoque híbridos iniciales eran un poco lentos comparados con los sistemas especializados de las réflex, en parte porque era una tecnología emergente y en parte por la limitación de los procesadores de generaciones más antiguas.

En la actualidad son sistemas rapidísimos y fiables, tanto en fotografía como en vídeo.

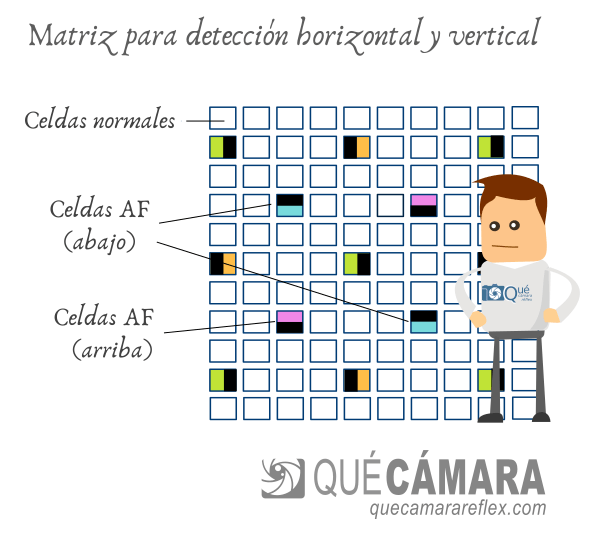

Detección de patrones horizontales y verticales

Como vimos en el artículo del sistema PDAF de las réflex, la colocación de las máscaras y los sensores CCD (distribución horizontal, vertical o diagonal) afecta a cómo el sistema es capaz de detectar las transiciones de contraste de la escena.

Cualquier sistema de enfoque pasivo necesita que la escena tenga cierta textura: bordes, transiciones con un contraste mínimo, etc.

Si la máscara estaba colocada horizontalmente podía detectar transiciones horizontales (líneas o bordes verticales de la escena) pero tenía muchos problemas con las líneas horizontales.

Si la máscara estaba colocada verticalmente podía detectar bordes horizontales de la escena, pero tenía problemas con los bordes verticales.

Luego había combinaciones que daban lugar a diferentes puntos de enfoque: cross type, diagonal cross type, etc. para ofrecer el mejor rendimiento posible en prácticamente cualquier tipo de patrón o textura de la escena.

En los sistemas PDAF integrados en el sensor se suelen utilizar matrices que combinan celdas con máscaras izquierda-derecha y celdas con máscaras arriba-abajo.

Hasta donde yo sé, la combinación de ambos y el hecho de que se analiza información 2D (se analizan imágenes realmente, no líneas como en los sensores CCD del módulo de enfoque) hace que el sistema sea muy fiable en prácticamente cualquier situación.

Además, como he comentado, el sistema es redundante. Si la parte PDAF falla por el motivo que sea y no tiene información suficiente, el sistema recurre a la parte de detección por contraste o a los algoritmos que considere necesarios.

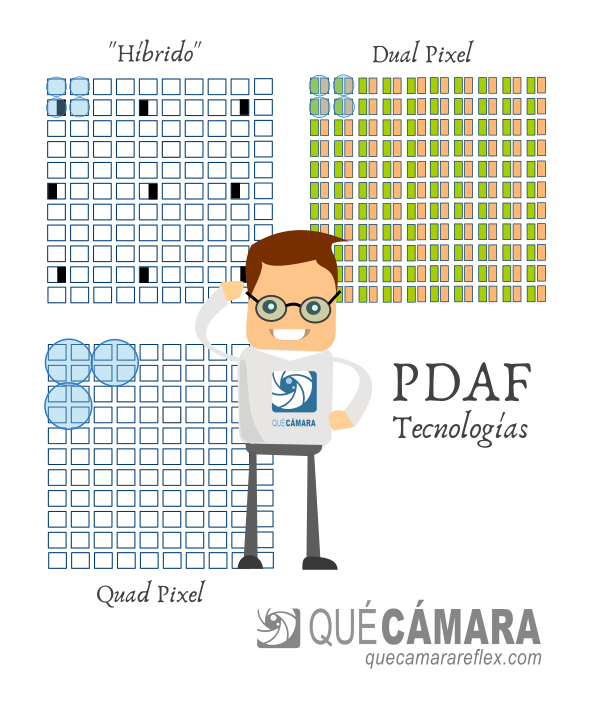

Sistema de enfoque Dual Pixel

Es el que utiliza Canon en muchos de sus sensores. También muchos móviles suelen usar sensores con Dual Pixel.

El principio de funcionamiento es básicamente el mismo que hemos estado viendo.

Pero en lugar de usar algunas celdas con máscara izquierda-derecha, el sistema Dual Pixel se basa en sensores en los que cada una de las celdas del sensor está dividida en realidad en dos celdas independientes que comparten una misma microlente.

![]()

La clave de todos estos sistemas está en el efecto de la microlente, que puede transmitir cierta información sobre la dirección desde la que llega la luz.

![]()

Para cada celda, la subcelda de la izquierda recibe sobre todo la contribución de la luz que llega desde la parte izquierda del objetivo.

La subcelda de la derecha recibe sobre todo la contribución de la parte derecha del objetivo.

Para la zona de enfoque elegida, el sistema realiza la comparación de la imagen ‘derecha’ con la imagen ‘izquierda’.

Aplicando algoritmos de análisis de imágenes puede determinar el desfase relativo (de forma similar a los sistemas que hemos comentado anteriormente)

La imagen final (fotografía o fotograma de vídeo) se construye a partir de todas las celdas del sensor. La información de las dos subceldas se combina para dar un rendimiento similar al que tendría una celda normal.

Ventajas de Dual Pixel

- En los sensores Dual Pixel, la resolución con la que trabaja el sistema de enfoque es máxima, la del propio sensor de imagen.

Sobre el papel, estos sistemas tendrían más precisión que los sistemas de enfoque híbridos

En la práctica intervienen otros factores, la resolución no es un factor tan determinante - Todas las celdas contribuyen a la formación de la imagen

No se pierde resolución y no se generan artefactos o patrones de ruido relacionados con la distribución de celdas AF

Desventajas de Dual Pixel

- Como se analizan imágenes con mayor resolución se necesita una potencia de cálculo mayor

- Sólo pueden discriminar en la dirección izquierda-derecha

En algunas situaciones, por ejemplo si la escena sólo tiene líneas horizontales, pueden tener más problemas - Mayor complejidad de diseño y fabricación

Aquí tienes más información sobre el sistema de enfoque Dual Pixel

Sistema de enfoque Quad Pixel

Estos sistemas se están empezando a implementar en algunos sensores de imagen para móviles.

El funcionamiento sería muy similar a los Dual Pixel.

En un sensor Quad Pixel cada microlente está sobre un grupo de 4 celdas (o subceldas, según cómo lo queramos interpretar)

Cada una de esas celdas recibe más contribución de uno de los cuadrantes de la escena.

El sistema puede decidir por ejemplo usar las imágenes ‘izquierda-derecha’. O las imágenes ‘arriba-abajo’. O usar las imágenes que corresponden a las celdas opuestas en diagonal…

Con esto se soluciona el problema de detección que puede ocurrir en el sistema Dual Pixel cuando encontramos una escena en la que sólo hay líneas o bordes horizontales.

Más información y referencias

- Sensor-Based Auto-Focusing System Using Multi-Scale Feature Extraction and Phase Correlation Matching.

Jinbeum Jang , Yoonjong Yoo, Jongheon Kim and Joonki Paik (Sensors 2015, 15, 5747-5762; doi:10.3390/s150305747) - A Simple Model for On-Sensor Phase-Detection Autofocusing Algorithm.

Przemysław Śliwiński, Paweł Wachel (Journal of Computer and Communications, 2013, 1, 11-17) - Autofocus Systems Part III, by Exclusive Architecture (Markus Kohlpaintner)

- Cómo funciona el sistema de enfoque Dual Pixel