Vamos a comparar y analizar el comportamiento de varias cámaras comerciales con sensores de diferentes tamaños: Full Frame, APS-C, Micro 4/3 y sensores de 1 pulgada.

Este artículo forma parte de la serie sobre sensores de imagen.

Recomiendo leer primero el artículo inicial de la serie para tener una idea global del funcionamiento de un sensor de imagen.

Si buscas información sobre el comportamiento de un sensor en función de su tamaño, lee primero este otro: Tamaño de sensor, cantidad de luz y exposición.

Éste es un artículo un poco técnico, pero con conceptos muy sencillos y unas matemáticas básicas. No huyas. Síguelo paso a paso, con tranquilidad. Ya verás que es mucho más sencillo de lo que parece. Y creo que el hecho de usar cámaras comerciales te va a ayudar a entender mejor todos esos conceptos, aplicados a sensores reales.

- Tamaño de sensor y SNR

- Comparar sensores

- Análisis de los datos

- Estimaciones con nuestro modelo

- ¿Influye realmente el área de la celda en el SNR global?

- ¿Cómo influye la tecnología del sensor?

- Estimaciones con nuestro nuevo modelo

- Conclusiones

Tamaño de sensor y SNR

Resumen muy resumido:

- El tamaño de celda influye directamente sobre la SNR local.

Celdas más grandes (mayor superficie) ofrecen una SNR mayor. - El reescalado, pasar la imagen de una resolución mayor a una resolución menor, tiene como efecto aumentar el SNR global de la imagen.

- El tamaño del sensor influye en la SNR global de la imagen.

Para estimar la SNR global tomamos la SNR local y la ajustamos con la ganancia debida al reescalado. - La percepción visual humana impone un umbral de SNR (30dB) a partir de la cual la imagen se considera excelente y el ruido es apenas perceptible en las condiciones de visualización estándar.

Todo esto está explicado con más detalle aquí: Tamaño de sensor, cantidad de luz y exposición.

Comparar sensores

Lo ideal sería hacer medidas reales de cada sensor (de cada cámara), pero no es algo trivial.

Por suerte tenemos acceso a medidas de sensores de muchas cámaras comerciales conocidas.

Tenemos los datos de DXOMARK y tenemos los datos y gráficas de photonstophotos.net

Vamos a elegir varias cámaras más o menos actuales (en el momento de escribir el artículo) con diferentes sensores:

- 1 pulgada: Canon G7 X, Sony RX100 VII

- Micro 4/3: Panasonic GX800, Panasonic GH5, Olympus E-M1 mark II

- APS-C: Sony a6400, Nikon D3500

- Full Frame: Canon EOS RP, Sony a7S, Sony a7R 4

Los modelos los he elegido básicamente al azar, los primeros que se me han ocurrido y de los que he encontrado información en DXOMARK para cada tipo de sensor.

Por ejemplo, dentro de las micro 4/3 hay cámaras de gama profesional (E-M1 para foto, GH5 para vídeo) y cámaras de gama de entrada (GX800).

Y en APS-C la Sony a6400 sería una gama media alta, mientras que la Nikon D3500 es una gama de entrada.

Criterio para comparar

Un mismo sensor puede tener diferente comportamiento dependiendo del régimen de trabajo.

Por ejemplo, en situaciones con muy poca luz en la escena y tiempos de exposición no muy largos, el ruido de lectura es el que tiene más influencia. Una situación típica sería cuando hay poca luz en la escena y necesitamos una velocidad de obturación relativamente alta.

En situaciones de poca luz y larga exposición (p.e. en astrofotografía de cielo profundo), el ruido térmico (dark current) puede ser un problema si no se utiliza una cámara con sensor refrigerado.

En el resto de situaciones, es decir, la inmensa mayoría de las situaciones típicas, el ruido predominante es el ruido fotónico.

Nosotros vamos a comparar en ese régimen de ruido fotónico.

La cámara recogerá suficiente luz como para que el ruido de lectura sea despreciable, pero el tiempo de exposición será muy corto, con lo que no afectará el ruido térmico.

Aquí tienes más información sobre las principales fuentes de ruido en un sensor de imagen.

Queremos hacer lo siguiente:

- Vamos a tomar como referencia una determinada SNR para la imagen final

- Elegimos una SNR lo suficientemente elevada como para que la imagen se perciba con una calidad excelente (30dB)

- Nos interesa saber qué exposición mínima necesitamos configurar para alcanzar dicha SNR

- Fijamos la iluminación de la escena y la apertura del objetivo

- Sólo ajustamos el tiempo de exposición y el valor de ISO para compensar (para tener la misma exposición aparente en todas las imágenes)

- A partir de esos datos intentaremos ver qué margen de maniobra (en SNR y en exposición) nos ofrece cada sensor.

Valores de DXOMARK

Para cada cámara vamos a utilizar valor Sports (Low-Light ISO) de DXOMARK

¿Qué es ese valor?

Es el valor de ISO máximo que podemos configurar en la cámara para conseguir al menos una relación señal a ruido de 30dB en la imagen resultante.

No nos tenemos que despistar con lo de ISO.

Subir ISO no añade ruido ni empeora la SNR. Lo que añade ruido y empeora la SNR es bajar la exposición real.

Es decir, imagina que tenemos configurada una determinada exposición en cámara:

f/5.6 | t=1/125s | ISO 100

Podemos subir el ISO un paso y bajar el tiempo de exposición un paso, y la exposición aparente de la imagen será la misma.

f/5.6 | t=1/250s | ISO 200

Pero esa exposición implica que llegan la mitad de fotones al sensor.

Y por lo tanto, la SNR será menor, la imagen tendrá más ruido (que se perciba o no dependerá del valor absoluto de la SNR, si está por encima de 30dB probablemente no se percibirá ruido).

De hecho, subir ISO sí puede mejorar la SNR, ya que disminuye la contribución del ruido de lectura. Pero no nos vamos a meter en este charco. Puedes echar un vistazo al artículo de fuentes de ruido para entender por qué subir ISO mejora la SNR de la imagen. Hemos dicho que estamos en un régimen en el que no afecta el ruido de lectura, así que no nos vamos a complicar.

A lo que vamos…

Tomamos el valor de ISO como referencia para no tener que dar valores exactos de iluminación de la escena, apertura y tiempo de exposición.

Simplemente tenemos que quedarnos con la idea de que ISO más alto implica menor número de fotones en el sensor.

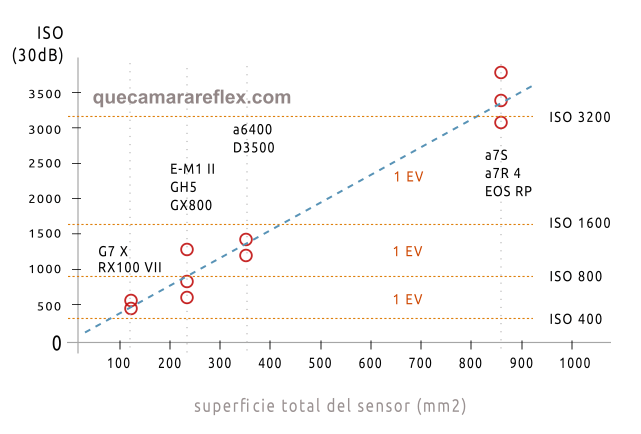

Apuntamos los datos que buscamos y los representamos en una gráfica:

El eje horizontal representa la superficie del sensor (en milímetros cuadrados)

El eje vertical representa el valor de ISO de la cámara en escala lineal.

Los puntos rojos corresponden con cada una de las cámaras.

Representan ese valor de ISO máximo para el que conseguimos una SNR de 30dB en la imagen final en su soporte final (por ejemplo en papel fotográfico con unas determinadas dimensiones y a una distancia de visualización estándar).

He incluido en color naranja las líneas que corresponderían a los valores ISO típicos (ISO 400, 800, 1600 y 3200) para tener una estimación más clara de las diferencias entre cámaras en pasos de luz.

Por ejemplo, la Sony a6400 está situada en los 667 mm2 y el valor de ISO máximo para conseguir 30dB de SNR está alrededor de ISO 1500.

Eso quiere decir que en esas mismas condiciones de exposición, si configuramos ISO 1600 y ajustamos el tiempo de exposición para tener la misma exposición, el resultado tendrá una SNR por debajo de 30dB.

Otro ejemplo, para la Sony A7R IV, en esas mismas condiciones podemos configurar un ISO máximo de alrededor de 3400.

Análisis de los datos

Vemos que los puntos están alineados verticalmente en sus correspondientes tamaños estándar:

- 1 pulgada: 116 mm2

- Micro 4/3: 225 mm2

- APS-C: 367 mm2

- Full Frame: 850mm2

Fíjate que el salto entre los sensores ‘crop’ y el sensor Full Frame en lo que respecta al área de captación es enorme.

La línea azul nos da idea de la correlación que hay entre tamaño de sensor y SNR global de la imagen.

El tamaño de la celda no parece en principio muy relevante, a pesar de que hay sensores con tamaños de celda muy dispares.

Vemos que hay cierta variabilidad entre modelos, para un mismo tamaño de sensor.

Esto ya lo veremos un poco más adelante. Digamos que esa variabilidad tiene que ver con la tecnología del sensor.

Así a ojo, podemos hacer una estimación empírica del margen de maniobra (en exposición, en pasos de luz) que nos da un sensor en función de su tamaño:

- Micro 4/3 tiene una ventaja marginal sobre los sensores de 1 pulgada, no llega a 1 paso.

- Los sensores APS-C tienen una ventaja de menos de 1 paso.

- Los sensores Full Frame tienen una ventaja de algo más de 1 paso y medio, no llega a 2 pasos, sobre los APS-C

- Micro 4/3, APS-C y Full Frame están en un rango de 2 pasos de exposición

Para que no nos perdamos…

Estamos diciendo que para una situación de iluminación concreta en la escena y para una determinada apertura queremos configurar la velocidad de obturación más rápida posible, de tal forma que la imagen final tenga una calidad excelente (30dB de SNR).

Si con la Sony A7R IV podemos configurar ISO 3400 y t=1/500s

Con la Nikon D3500 sólo podría llegar a ISO 1200 (1.5 pasos menos) con un tiempo de exposición de alrededor de 1/175s para compensar la exposición aparente.

Es decir, ese paso y medio de diferencia se traduce realmente en una velocidad de disparo que es un paso y medio más lenta.

Ésa es la idea.

El sensor más grande nos da más margen (velocidad de disparo más rápida) para las mismas condiciones de la escena y manteniendo una determinada calidad en la imagen final.

Estimaciones con nuestro modelo

Nuestro modelo para comparar dos sensores, considerando predominante el ruido fotónico, era muy sencillo:

- Partimos de una determinada exposición (luz en la escena, apertura, tiempo de exposición)

- Calculamos la ganancia de SNR a nivel de celda, a partir de la relación entre el tamaño de celda del sensor 1 y el tamaño de celda del sensor 2

- Calculamos la ganancia de SNR que obtenemos al reescalar la imagen de mayor resolución

- Aplicamos las dos ganancias de SNR para determinar la relación entre la SNR del sensor 1 y la SNR del sensor 2

- El margen en SNR lo podemos pasar a margen en exposición (ISO o tiempo de exposición o apertura)

Voy a hacer los cálculos para un par de casos.

Sony A7R IV vs Nikon D3500

Tomamos los datos de la A7R IV y calculamos el tamaño de celda:

Área sensor: 850mm2

Resolución: 61.2 Mpx

Área celda = 850 mm2 / 61.2 Mpx = 14 um2 (micrómetros cuadrados)

Lo mismo para la Nikon D3500:

Área sensor: 367mm2

Resolución: 24 Mpx

Área celda = 367 mm2 / 24 Mpx = 15.2 um2 (micrómetros cuadrados)

Estimamos la diferencia de SNR debida al tamaño de celda:

SNR1 / SNR2 = raíz (14 / 15.2) = 0.96

Ahora estimamos la ganancia de SNR al redimensionar:

SNRres (A7R con respecto a D3500) = raíz (61.2 / 24) = 1.57

Poniendo todo junto (diferencia de SNR por celda, ajustada por el reescalado):

SNR1 = ( 0.96 SNR2 ) * 1.57 = 1.51 SNR2

Si lo pasamos a pasos de luz (log en base 2):

SNR1 = SNR2 + 0.6 EV

El margen en SNR no nos dice mucho realmente. Nosotros queremos ver el margen en exposición.

En régimen de ruido fotónico es muy sencillo. La SNR debida al ruido fotónico se corresponde con la raíz cuadrada del número de fotones.

No podemos calcular el número de fotones, pero da igual, porque lo que nos interesa es la relación entre el número de fotones captados por´ la A7R y el número de fotones captados por la D3500 para la misma exposición. Al número de fotones le podemos llamar S (de señal)

SNR1 = raíz (S1)

SNR2= raíz (S2)

raíz(S1) = 1.51 · raíz(S2)

Elevamos al cuadrado:

S1 = (1.51)² · S2 = 2.28 · S2

Es decir, según nuestra estimación, la A7R IV ha captado más del doble de fotones, para la misma exposición.

Para que la D3500 pueda conseguir la misma SNR tendrá que ajustar su exposición para recibir esa misma cantidad de fotones. Puede aumentar el tiempo de exposición por ejemplo. El número de fotones recibidos por unidad de área es directamente proporcional al tiempo de exposición.

Para aumentar en un factor 2.28 el número de fotones, tendremos que aumentar el tiempo de exposición en ese mismo factor.

Si lo pasamos a pasos de luz (logaritmo en base 2 de 2.28):

t2 = t1 + 1.19 EV

Dicho de otra forma, el margen en exposición estimado es de aproximadamente 1.2 pasos.

En la gráfica vemos que el margen en exposición es de aproximadamente 1.5 pasos.

No está mal la estimación. Luego veremos si podemos corregir esas discrepancias.

Sony A7S vs Panasonic GH5

Tomamos los datos de la A7S y calculamos el tamaño de celda:

Área sensor: 850mm2

Resolución: 12 Mpx

Área celda = 850 mm2 / 12 Mpx = 71 um2 (micrómetros cuadrados)

Lo mismo para la GH5:

Área sensor: 225mm2

Resolución: 20 Mpx

Área celda = 225 mm2 / 20 Mpx = 11.3 um2 (micrómetros cuadrados)

Estimamos la diferencia de SNR debida al tamaño de celda:

SNR1 / SNR2 = raíz (71 / 11.3) = 2.51

Ahora estimamos la ganancia de SNR al redimensionar:

SNRres (A7S con respecto a GH5) = raíz (12 / 20) = 0.77

Poniendo todo junto (diferencia de SNR por celda, ajustada por el reescalado):

SNR1 = ( 2.51 SNR2 ) * 0.77 = 1.93 SNR2

Ya hemos visto que para estimar el margen en exposición sólo hay que elevar la relación de SNRs al cuadrado:

S1 = 1.93² · S2

Y si lo pasamos a tiempo extra de exposición en pasos de luz:

t2 = t1 + 1.9 EV

En la gráfica vemos que la diferencia medida entre la A7S y la GH5 supera los 2 pasos (sería del orden de 2.2 EV)

¿Influye realmente el área de la celda en el SNR global?

Este procedimiento para estimar el margen de un sensor con respecto a otro va bien para entender qué está ocurriendo: SNR por celda, que luego ajustamos con la ganancia en SNR debida a la resolución, y luego podemos calcular la ventaja o margen en exposición (tiempo de exposición) que nos da un sensor con respecto a otro.

Por eso lo he hecho paso a paso, para entender qué ocurre a nivel de celda y qué ocurre luego con la imagen final en papel fotográfico por ejemplo.

Pero realmente el área total del sensor, la resolución y el área de cada celda no son tres parámetros independientes.

Si te fijas bien, el ajuste que hacemos con el reescalado nos lleva directamente al ratio entre las áreas totales de un sensor y otro.

Todo ese jaleo lo podríamos haber simplificado:

SNR1 / SNR2 = raíz (A1 / A2)

En el último ejemplo:

SNR1 / SNR2 = raíz (850mm2 / 225mm2) = 1.94

Y para estimar el margen en exposición es mucho más sencillo, nos lo da directamente el ratio del área de los sensores:

A1 / A2 = 3.77 = 1.94²

t2 = t1 + 1.9 EV

No es ninguna sorpresa, la verdad.

Suponiendo una tecnología similar, la SNR global de la imagen final, impresa en papel fotográfico o la que veremos publicada en redes sociales o la que vemos en una pantalla (sin ampliar al 100%) depende fundamentalmente de la superficie del sensor, no depende de la superficie de la celda.

Pensarás: «para este viaje no hacían falta alforjas»

¿Para qué hemos enredado con el área de la celda?

Porque una de las leyendas urbanas más extendidas es que lo más importante es el tamaño de celda (para conseguir una determinada SNR) y que el tamaño del sensor es algo irrelevante.

Lo que intento probar con este procedimiento paso a paso es que el tamaño de celda sólo influye muy localmente en la SNR de cada zona de la imagen, pero no en la imagen como un todo.

¿Cómo influye la tecnología del sensor?

Si la diferencia de rendimiento (SNR global) de los sensores sólo depende de su superficie total, ¿por qué hay diferencias entre sensores que tienen el mismo tamaño?

Por ejemplo, la A7S aparece muy arriba en la gráfica (con respecto al rendimiento esperado con nuestro modelo), la Canon EOS RP aparece un poco por debajo, la Olympus E-M1 aparece muy por encima de lo que ‘debería’, etc.

Nuestro modelo funciona bien cuando las tecnologías de los sensores son similares.

Los sensores han ido evolucionando en muchos aspectos. Para lo que nos interesa aquí, podríamos resumirlo en dos apartados:

- Aumentar la eficiencia cuántica (QE)

La eficiencia cuántica del material fotosensible, pero sobre todo aumentar la superficie de captación efectiva: el uso de microlentes, reducir el impacto de la electrónica asociada a cada celda, la tecnología BSI para aumentar la superficie efectiva, etc. - Reducir el ruido de lectura

En los sensores actuales el ruido de lectura es muy bajo y sólo tiene influencia en determinadas situaciones muy concretas.

Los sensores que tienen un ruido de lectura prácticamente despreciable se conocen como sensores invariantes al ISO.

Aquí tienes más información sobre qué tiene que ver el ISO con el ruido de lectura.

Como estamos considerando el régimen de ruido fotónico, el ruido de lectura lo dejaremos al margen en nuestro modelo.

Sí vamos a considerar la eficiencia cuántica.

El eficiencia cuántica nos dice lo siguiente: de todos los fotones que llegan al sensor, ¿qué porcentaje de ellos consiguen generar electrones libres (par electrón – hueco)?

Sólo esos fotones van a contribuir a la información de la imagen. Los demás son absorbidos o reflejados por el material sin que aporten nada a la imagen.

El eficiencia cuántica no es un número, es una curva, una función, que depende de la longitud de onda de cada fotón.

Comparar dos sensores con precisión no es trivial.

Pero para hacer estimaciones no es necesario ir tan lejos.

El pico de eficiencia cuántica suele estar en la zona central del espectro visible, para longitudes de onda en la zona de los 600nm.

Así que se suele tomar un valor de QE como representativo del sensor.

Los valores típicos en sensores relativamente recientes van desde el 50% hasta el 80%

Nos da un poco igual si esa eficiencia viene del tipo de material fotosensible o de la optimización para evitar perder área efectiva (microlentes, BSI…)

¿Cómo afecta la eficiencia cuántica?

La eficiencia cuántica la podemos modelar como un ajuste del área de captación física.

El área de captación efectiva siempre será menor que el área física de la celda o el sensor (porque la eficiencia cuántica no puede ser del 100%).

Por ejemplo, para un sensor con una superficie física A, el área efectiva será:

Ae = QE · A (mm²)

Sólo tenemos que aplicar la eficiencia cuántica a la superficie de cada sensor antes de aplicar nuestro modelo.

Estimaciones con nuestro nuevo modelo

Vamos a ajustar las estimaciones que hicimos, así que necesitamos saber la eficiencia cuántica de algunos de esos sensores:

- A7S : 62%

- A7R IV: 58%

- D3500: 46% (no viene información, utilizo la de la D3400 como referencia)

- GX800: 38%

- E-M1 mark 2: 81%

- a6400: 57%

- EOS RP: 56%

- GH5: 53%

- …_

Ya vamos viendo aquí cositas.

Hay que tener en cuenta que la eficiencia cuántica es uno de los miles de criterios y factores que forman parte del diseño de un sensor. No es que los ingenieros que diseñan sensores digan: ‘voy a hacer un sensor con una eficiencia baja porque me apetece esta mañana‘. Cada decisión de diseño afecta a la arquitectura y a la funcionalidad del sensor.

En sensores para cámaras de propósito general se busca siempre un cierto equilibrio entre muchos factores diferentes, muchos de ellos incompatibles entre sí.

Pero bueno, no nos vamos a complicar la vida.

¿Qué cosas vemos aquí?

Por ejemplo, que la Olympus E-M1 mark II tiene una eficiencia cuántica brutal. Por eso está por encima incluso de la D3500, que lleva un sensor APS-C

Los sensores de las Sony que hemos elegido tienen todos una eficiencia similar, alrededor del 60%.

Entre la A7S (resolución muy baja) y la A7R IV (resolución muy alta), podemos imaginar que el hecho de tener más celdas implica una pequeña pérdida de superficie efectiva (las separaciones o gaps entre celdas por ejemplo)

La Panasonic GX800 tiene una eficiencia cuántica bastante pobre, 38%. Probablemente lleva un sensor bastante antiguo, quizás sin microlentes.

Sony A7R IV vs Nikon D3500

Vamos a calcular directamente el margen en exposición (ventaja en pasos de exposición) por la relación entre áreas, ajustada cada una por la QE

Ae (A7R) = 850mm2 · 0.58 = 493mm2

Ae (D3500) = 367mm2 · 0.46 = 168.8mm2

A1 / A2 = 493 / 168.8 = 2.92

Pasamos a pasos de luz (logaritmo en base 2)

t2 = t1 + 1.55 EV

Vemos que cuadra bastante mejor con la diferencia que aparece en la gráfica.

Sony A7S vs Panasonic GH5

Ae (A7S) = 850mm2 · 0.62 = 527mm2

Ae (GH5) = 225mm2 · 0.53 = 119.3mm2

A1 / A2 = 527 / 119.3 = 4.4

Pasamos a pasos de luz (logaritmo en base 2)

t2 = t1 + 2.14 EV

Sí, bastante mejor. En la gráfica sería del orden de 2.2 EV, pero el error es muy pequeño.

Olympus E-M1 mark II vs Nikon D3500

Ae (E-M1) = 225mm2 · 0.81 = 182.3mm2

Ae (D3500) = 367mm2 · 0.46 = 168.8mm2

A1 / A2 = 182.3 / 168.8 = 1.1

Pasamos a pasos de luz (logaritmo en base 2)

t2 = t1 + 0.14 EV

Efectivamente, la E-M1 mark II, a pesar de ser un sensor Micro 4/3, tiene un área efectiva mayor que la D3500, y la ventaja o margen de exposición es a favor de la E-M1 como vemos en la gráfica.

En la práctica esas diferencias no las notaríamos en absoluto. Es más, las diferencias entre sensores M4/3 y sensores APS-C, para tecnología similar, etc. son básicamente inapreciables en el día a día. Hay muchos otros factores externos que van a tener más efecto probablemente.

Conclusiones

Intenta comparar tú mismo parejas de sensores de cámaras comerciales utilizando este modelo sencillo.

Una primera estimación a partir de las áreas físicas de los sensores ya nos da una aproximación bastante buena.

Con el valor de eficiencia cuántica podemos hacer un ajuste más fino.

Como se suele decir: «El diablo está en los detalles«. Un modelo tan sencillo, estadístico, no puede recoger todos los casos de uso y todas las particularidades.

Si quisiéramos hacer una caracterización más precisa de un sensor o una comparación más precisa entre sensores, tendríamos que medir en un laboratorio. Hay estándares de medición y caracterización de sensores dependiendo de su uso.

En la práctica, cuando estamos fotografiando o grabando en vídeo escenas reales, intervienen muchísimos factores. El tamaño de sensor es quizás de los menos importantes. La parte óptica va a condicionar bastante los resultados y la forma de trabajo (ángulo de visión, profundidad de campo…)

En este artículo simplemente estamos poniendo de manifiesto que el tamaño de sensor (y la eficiencia) es en general más importante que el tamaño de celda.

Dicho de otra forma: estadísticamente hablando, para la mayoría de las fotos que hacemos en el día a día, el tamaño de celda no es tan importante, la calidad global de la imagen (SNR global) viene determinada sobre todo por el área de captación efectiva del sensor en su conjunto.

Si el tamaño de celda no influye, ¿por qué no tienen todos los sensores una resolución muy alta?

No hemos dicho que el tamaño de celda no influya.

El tamaño de celda determina la SNR local.

En el caso del ruido fotónico, su distribución espacial en una imagen no es homogénea. Las zonas más oscuras tendrán un SNR menor, y las zonas más claras tendrán un SNR mayor.

Además, cuando los datos RAW del sensor se utilizan para generar la imagen final (en JPEG por ejemplo) se pasan a un espacio de color, que tendrá asociado una corrección gamma.

La corrección gamma expande la información de las zonas oscuras y comprime la información de las zonas más brillantes.

En una imagen típica, aunque la SNR global sea estadísticamente muy alta, puede haber zonas concretas en las que la SNR esté por debajo del umbral de percepción y sea visible el ruido.

El tamaño de celda también está relacionado con la capacidad máxima del depósito de electrones, que a su vez influye en el rango dinámico que puede capturar el sensor.

Como digo, los sensores de cámaras comerciales de propósito general se diseñan para cubrir (más o menos bien) un montón de situaciones diferentes.

En general se intenta buscar un equilibrio entre SNR local y resolución.

Más información

- Serie sobre sensores de imagen

- ¿Cómo funciona un sensor de imagen? (recomendado como primera lectura para tener una visión global)

- Tamaño de sensor, cantidad de luz y exposición

- Fuentes de ruido en los sensores de imagen y valor ISO