¿Recogen más luz los sensores más grandes? ¿Qué relación hay entre exposición y cantidad de luz? ¿Y cómo afecta el tamaño del sensor al ruido de las imágenes?

Este artículo forma parte de la serie ¿Cómo funciona el sensor de una cámara?, te recomiendo que leas primero ese artículo y este otro: Ruido, ISO y características del sensor de una cámara. Y aquí tienes la serie sobre sensores de imagen.

Si buscas información sobre estos temas en internet (sobre las preguntas que planteamos arriba por ejemplo) te vas a encontrar todo tipo de argumentos y explicaciones, muchas de ellas contradictorias entre sí.

Vamos a intentar aclarar un poco las cosas.

El artículo puede parecer un poco técnico, pero dale una oportunidad, creo que vale la pena el esfuerzo.

- ¿Recogen más luz los sensores más grandes?

- ¿Entonces la imagen del sensor más grande aparecerá más luminosa, más clara?

- Exposición vs Cantidad de luz

- Cámaras diferentes, exposición y tamaño de sensor

- Tamaño del sensor y calidad de imagen

- ¿SNR a nivel de celda o a nivel de sensor?

- Imagen final (imagen útil)

- Tamaño de sensor y tamaño de celda

- Margen en SNR y margen en exposción

- ¿Influye el área de la celda en el SNR global?

- El ISO

- Sensor grande vs sensor pequeño… en el mundo real

- ¿Es tan importante el tamaño del sensor?

- Una cuestión de equilibrio

- Resumen y conclusiones

¿Recogen más luz los sensores más grandes?

Sí.

Suponiendo un flujo homogéneo de luz por unidad de superficie: cuanto mayor es la superficie de captación más fotones inciden por unidad de tiempo.

Dicho de otra forma, para una determinada exposición (iluminación en la escena + apertura + tiempo de exposición) un sensor más grande recibirá en conjunto más fotones.

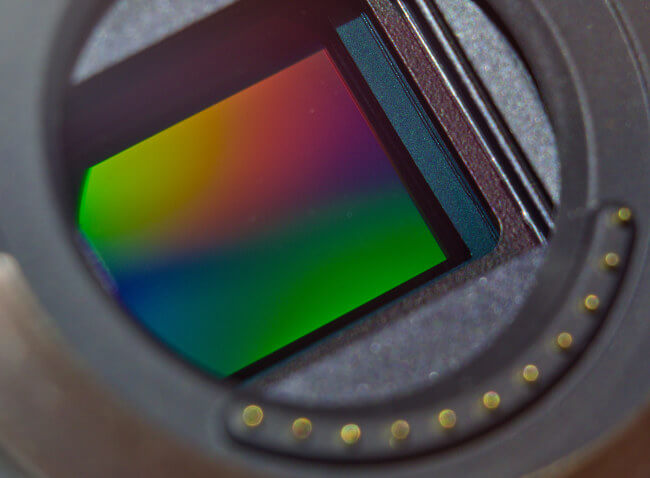

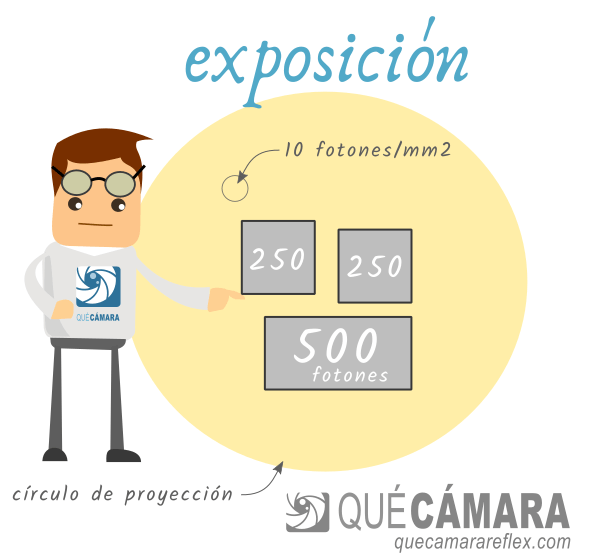

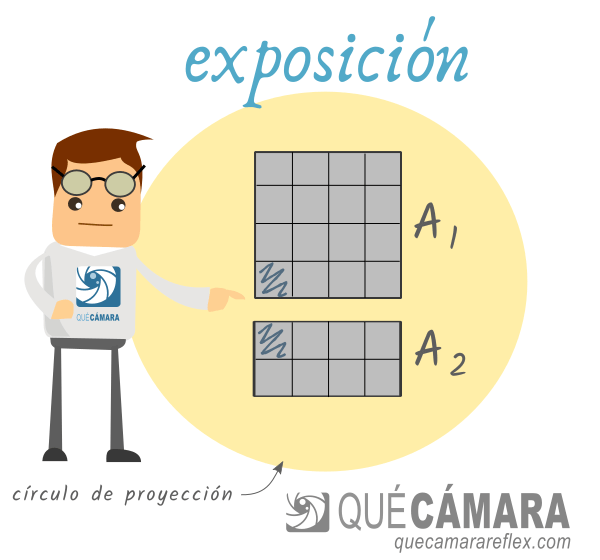

Imagina por ejemplo un sensor formado por una única celda fotosensible.

Este sensor es iluminado perfectamente por el círculo de proyección de un objetivo, en toda su extensión y de forma homogénea.

Habrá un flujo de fotones (fotones por unidad de superficie y por unidad de tiempo) incidiendo sobre el sensor-celda.

I [ fotones / mm² / s ]

En una cámara, ese flujo de fotones vendrá determinado por la iluminación de la escena y por la apertura del objetivo.

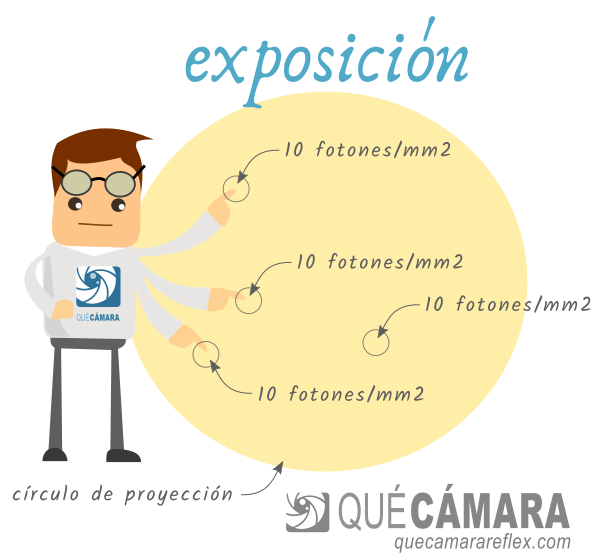

Para un tiempo de exposición dado, tendremos una densidad de fotones que se distribuye por toda la superficie del círculo de proyección. La vamos a llamar exposición:

‘exposición’ = I [ fotones / mm² / s ] * t [s]

‘exposición’ : [ fotones / mm² ]

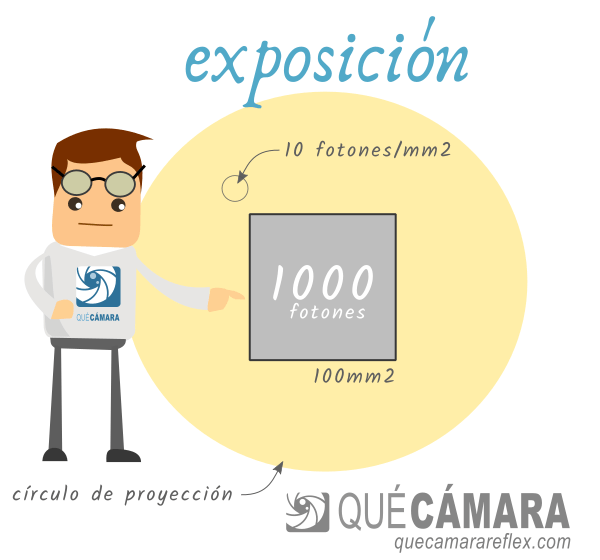

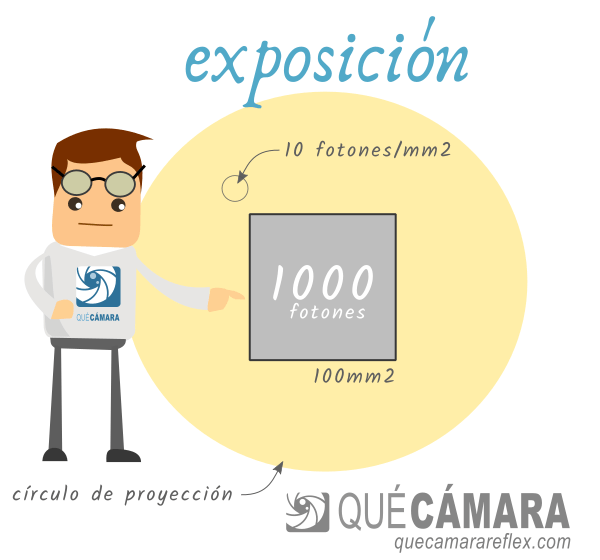

Para calcular el número total de fotones simplemente tendríamos que indicar el área de captación (en mm² por ejemplo) y el tiempo de exposición (en segundos).

fotones totales = E [ fotones / mm² ] * A [mm²]

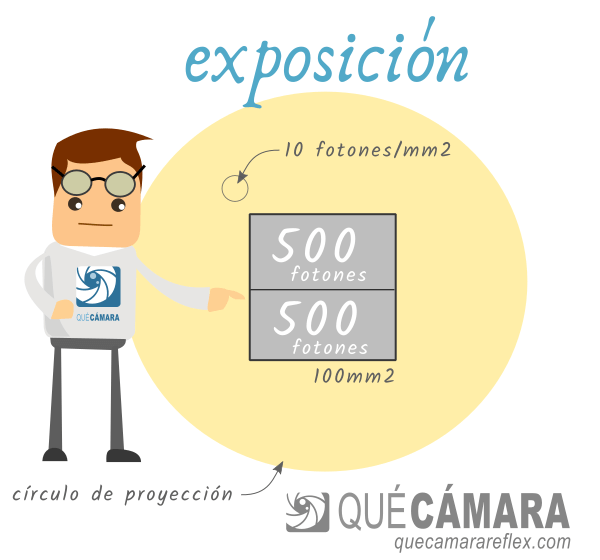

Ahora, como experimento mental, vamos a dividir el sensor en dos celdas iguales.

Cada una de esas celdas recibirá en media la mitad de los fotones.

Y eso lo podemos repetir muchas veces hasta conseguir un sensor con N celdas fotosensibles independientes. El número de celdas nos daría la resolución del sensor.

El número de fotones que recibe cada celda, en media, será:

fotones por celda = fotones totales / N

Pero también podemos ‘cortar’ el sensor inicial y separar los dos trozos. Tendremos dos sensores independientes.

Cada uno de esos sensores recibirá, en media, la mitad de los fotones que recibía el sensor original.

fotones por sensor = fotones totales / 2

En este experimento mental podríamos hacer todas las combinaciones de tamaño y resolución que se nos ocurran.

La conclusión será la misma: para unas determinadas condiciones de iluminación (flujo de fotones) el número total de fotones que recibe una superficie será proporcional al área de dicha superficie.

Por ejemplo, supongamos que el sensor grande lo dividimos en 2 sensores de igual tamaño. Y uno de ellos lo ‘cortamos’ a su vez para tener otros 2 sensores. Es decir, tendríamos un sensor grande y otros dos sensores pequeños, de tal forma que:

fotones en sensor pequeño = fotones totales / 4

fotones en sensor grande = fotones totales / 2

¿Entonces la imagen del sensor más grande aparecerá más luminosa, más clara?

No.

El brillo aparente de la imagen (si aparece más oscura o más clara) viene determinado por la exposición, que nos da idea de la cantidad de luz por unidad de superficie que llega al sensor.

La exposición real nos habla de cantidad de luz (fotones) por unidad de superficie.

Depende exclusivamente de la iluminación de la escena, de la apertura del objetivo y del tiempo de exposición.

La iluminación de la escena y la apertura del objetivo nos dan un determinado flujo de fotones por unidad de área y por unidad de tiempo, que podemos llamar ‘coloquialmente’ intensidad de luz: I [ fotones / mm² / s ]

Y el tiempo de exposición nos da finalmente la exposición que tendrá la imagen final:

‘exposición’ = I [ fotones / mm² / s ] * t [s]

‘exposicion’ : fotones / mm²

La exposición nos da una cantidad de fotones por unidad de superficie.

La exposición no nos dice nada acerca de qué tipo de superficie tenemos que tomar como referencia, no nos habla de la superficie del sensor ni de la superficie de cada celda. Ni siquiera nos habla del soporte sobre el que se proyectan esos fotones: sensor digital, película fotográfica, una pantalla de proyección, una pared…

Exposición vs tamaño del sensor vs cantidad de fotones

Como he comentado, la exposición no tiene nada que ver con la superficie del medio de captación, sensor o película.

Dada una determinada exposición, la cantidad de fotones recibidos (en media) por una determinada superficie colocada dentro del círculo de proyección será proporcional a dicha superficie.

Si quieres verlo de una forma más intuitiva:

- Un sensor más grande recibe más luz, pero la reparte por una superficie mayor

- Un sensor más pequeño recibe menos luz, pero la reparte por una superficie menor

Y lo mismo aplicaría si sustituimos la palabra sensor por la palabra celda, o cualquier otra subdivisión que queramos hacer.

La exposición nos habla del brillo medio de una imagen, y no tiene relación ninguna con el tamaño del sensor o con el tamaño de celda.

El tamaño del sensor y el tamaño de la celda influyen en la relación señal a ruido de la imagen, no en la exposición.

ISO

La exposición aparente incluye el efecto del valor ISO de la cámara (digital) o el ISO/ASA de la película fotográfica.

Las cámaras comerciales de propósito general para fotografía y vídeo están calibradas de tal forma que una misma combinación de apertura, tiempo de exposición e ISO nos ofrecerá una imagen muy similar en cuanto a brillo percibido, sea cual sea la cámara usada.

Para una determinada exposición real (fotones por unidad de superficie), el valor ISO aumenta el brillo aparente de la imagen, simulando de alguna forma el efecto que se conseguiría si hubiéramos utilizado más fotones.

Lo que llamamos coloquialmente parámetro ‘ISO’ hace referencia a un estándar concreto de la International Organization for Standardization, y es precisamente eso, una forma de estandarizar el comportamiento de todas las cámaras comerciales.

Muchas cámaras de astrofotografía o sensores especializados no tienen necesidad de entrar en este tipo de estándares, en su lugar utilizan un parámetro genérico de ganancia (gain).

En las cámaras de película, el valor de ISO es un estándar para la película en sí, no tiene nada que ver con la cámara.

En las cámaras digitales comerciales, el valor de ISO se puede cambiar como cualquier otro parámetro de la cámara.

Exposición vs Cantidad de luz

A modo de resumen:

La exposición de una imagen depende de la intensidad de luz (piensa en ella como fotones por segundo) que recibe el sensor, por el tiempo que está expuesto a esa luz.

La exposición no depende del tamaño del sensor (suponiendo que no hay otros factores que limiten la cantidad de luz que recibe el sensor).

En las cámaras, la exposición real (total de fotones por unidad de superficie) depende de la apertura del diafragma (número f) y del tiempo de exposición (velocidad de obturación)

En la exposición aparente (exposición percibida) de la imagen final también interviene la sensibilidad de la película o del sensor (estándar ISO para calibrar y parámetro ISO para ajustar el brillo aparente).

Es decir, variando el valor de ISO hacemos que la imagen aparezca más clara o más oscura, pero es algo ‘artificial‘ ya que partimos del mismo número de fotones.

Mucha gente habla de cantidad de luz como sinónimo de exposición. Y de ahí vienen muchas de las confusiones relacionadas con estos temas.

Para nosotros, cantidad de luz hace referencia al número total de fotones que han llegado al sensor, que se han transformado en electrones libres en el material semiconductor, y que se han acumulado en la celda, o en el sensor en su conjunto.

Esos fotones que llegan al sensor contienen de alguna forma la información recogida de la escena.

Cámaras diferentes, exposición y tamaño de sensor

Resumen:

Todas las cámaras digitales tienen calibrado el sensor de tal forma que se ajuste (más o menos) al comportamiento de las películas fotográficas.

A igualdad de parámetros:

- Apertura

- Tiempo de exposición

- ISO

… todas las cámaras van a generar una imagen con una exposición ‘idéntica’.

Lo pongo entre comillas porque hay otros factores que influyen, por ejemplo:

- La apertura del objetivo es un parámetro que se basa en la geometría de los elementos ópticos, no tiene en cuenta la luz que se pierde al atravesar las lentes que lo forman (las lentes no son totalmente transparentes)

- Tampoco tiene en cuenta el viñeteo: la zona central recibe más luz que las zonas más alejadas del centro

- Cada fabricante calibra su sensor (valores ISO) con cierto margen de tolerancia

Tamaño del sensor y calidad de imagen

Entonces, si la exposición no depende del tamaño del sensor… ¿qué ventaja tiene un sensor más grande?

Para entenderlo tenemos que hablar de la relación señal a ruido: SNR (signal to noise ratio)

La señal es la información, la escena real que estamos fotografiando.

La información de la escena se transmite a través de la luz. La luz es el canal de transmisión.

El ruido es algo que forma parte de la naturaleza y aparecerá en cualquier sistema físico y canal de transmisión de información.

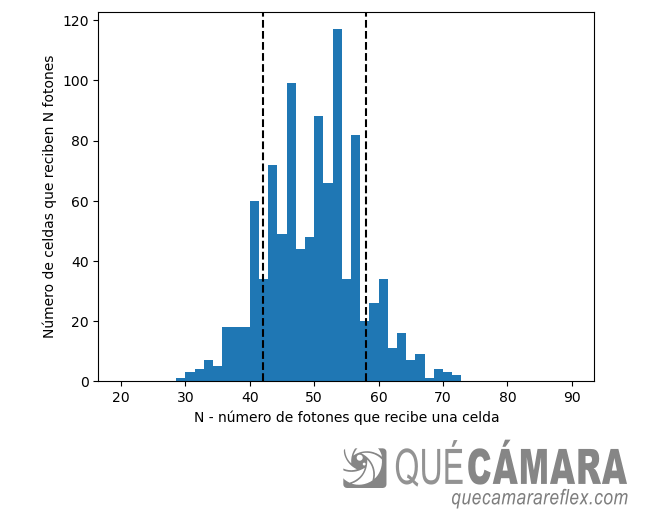

La propia luz incluye en sí misma una componente de ruido: el número de fotones que llega a cada punto del sensor fluctúa de forma estadística (distribución de Poisson) y da lugar a lo que se conoce como ruido fotónico.

Hay otras fuentes de ruido que afectan a la señal eléctrica (una vez que el sensor convierte los fotones en electrones) y que tienen que ver por ejemplo con el comportamiento de los átomos y electrones de un material dependiendo de su temperatura (ruido térmico, ruido de lectura).

Nunca vamos a tener una imagen totalmente fiel a la realidad, siempre contendrá algo de ruido.

Aquí tienes más información sobre fuentes de ruido en sensores de imagen

Relación señal a ruido (SNR) y calidad de imagen

Para evaluar la calidad de la imagen se utiliza la relación señal a ruido, SNR.

Es simplemente una relación entre dos cantidades: el nivel de señal (en las unidades que corresponda) dividido por el nivel del ruido (en unidades equivalentes)

El nivel de ruido por separado no nos dice nada, porque si el nivel de la señal es mucho mayor quedará enmascarado.

La SNR se suele expresar en escala logarítmica, en dB por ejemplo (también se podría medir en pasos de luz, EV, que es otra escala logarítmica).

Para que nos hagamos una idea, cuando la amplitud de la señal es doble que la del ruido, su SNR sería de 6dB. Esta escala está relacionada con el logaritmo en base 10 del valor (de la SNR en este caso)

Esos 6dB equivaldrían a un paso de luz (EV si lo queremos expresar así), un salto de ‘doble o mitad’. La escala de pasos de luz está relacionada con el logaritmo en base 2.

En general querremos obtener imágenes con la mayor SNR posible, de tal forma que el ruido quede totalmente enmascarado, sea indistinguible y no afecte a la información útil de la escena.

En este sistema: la información está en la escena, el canal de transmisión es la luz, y la imagen es el resultado final, que contiene información de la escena y un cierto nivel de ruido.

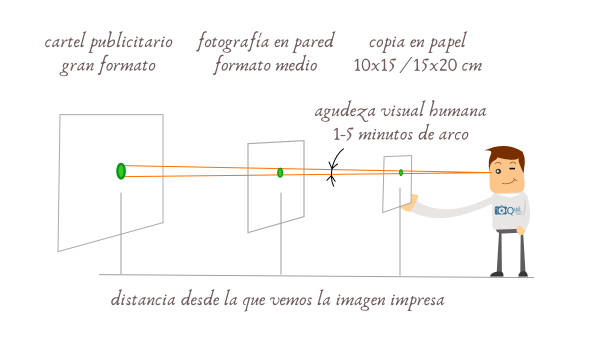

La percepción visual humana

Este concepto es fundamental para entender realmente de qué estamos hablando cuando comparamos sensores (o la parte óptica, o cualquier cosa que tenga que ver con la ‘calidad’ de imagen)

Nuestra percepción visual está limitada por la agudeza visual de cada persona.

El ruido se percibe en la imagen como granulado, puntos que aparecen con diferente tono (claro / oscuro) o diferente color del que correspondería en una imagen ideal sin ruido.

A medida que aumenta la SNR de una imagen, el efecto del ruido es cada vez más pequeño. Su radio de influencia disminuye, cada vez afecta a detalles más pequeños.

Llega un momento en que el límite de agudeza visual impide que percibamos ningún efecto.

Ten en cuenta que este límite de agudeza visual es un ángulo, por lo tanto, la capacidad de percibir el detalle fino de la imagen y la capacidad de percibir el ruido dependerán de las condiciones de visualización: tamaño del soporte físico (foto en papel, pantalla…), resolución del soporte y distancia de visualización.

Para unas condiciones de visualización estándar:

Una imagen se considera que tiene una calidad aceptable a partir de unos 20dB de relación señal a ruido.

Una imagen con una SNR por encima de 30dB se considera excelente y el ruido apenas es perceptible.

Esto quiere decir que una vez que una imagen ha superado ese umbral, por mucho que mejoremos su relación señal a ruido, esas mejoras tendrán un impacto muy pequeño o nulo en la percepción de su calidad.

Dicho de otra forma, una imagen con un SNR de 40dB será indistinguible de una imagen con SNR de 60dB en lo que respecta a percepción de ruido.

Y por ese motivo podemos hacer fotos excelentes con prácticamente cualquier cámara siempre que las condiciones de iluminación de la escena sean adecuadas.

¿SNR a nivel de celda o a nivel de sensor?

Ésta es la eterna cuestión que encontrarás desde el principio de los tiempos en foros y en conversaciones de barra de bar de cuñados y fotógrafos (o de cuñados fotógrafos)… :)

El problema de estas discusiones es que se intenta extrapolar el comportamiento de un sensor a situaciones muy diferentes entre sí, cada uno según su propia experiencia de uso y sus intuiciones.

Otro problema son las analogías. Cuando se usan analogías hay que tener cuidado porque la analogía deja de tener validez en el momento en que intentamos profundizar un poco más o cuando necesitamos tener una visión más global.

Así que vamos a intentar ir piano piano y con pies de plomo.

SNR en la celda

Esta parte creo que la comprende todo el mundo y entiendo que todo el mundo estará de acuerdo.

Para una determinada exposición, la relación señal a ruido en una celda será mayor cuanto mayor sea su superficie de captación.

fotones totales = I [ fotones / mm² / s ] * t [s] * A [mm²]

fotones totales = E * A

Donde E es la densidad de fotones por unidad de área que nos ha proporcionado esa exposición concreta.

El ruido fotónico es el ruido predominante en la inmensa mayoría de las situaciones en fotografía y vídeo. Las demás fuentes de ruido se pueden despreciar en esas situaciones. Así que sólo vamos a tener en cuenta el ruido fotónico. Si tuviéramos en cuenta las demás fuentes de ruido, las conclusiones y el razonamiento serían exactamente los mismos, más reforzados incluso: más fotones, mayor SNR.

Vamos a suponer que dos celdas de diferentes sensores captan el mismo ‘punto’ de una escena, con la misma exposición. Vamos a suponer la misma tecnología en los dos sensores (misma eficiencia cuántica, etc.)

El área de cada celda del sensor 1 es el doble que el área de cada celda del sensor 2: a2 = 2 * a1

fotones celda 1 = E * a1

fotones celda 2 = E * a2

Eso quiere decir que la celda grande habrá capturado, en media, el doble de fotones.

El nivel de ruido fotónico (desviación típica) se corresponde con la raíz cuadrada de la cantidad de fotones.

Como estamos hablando de procesos estadísticos, podemos pensar en una única celda en la que medimos una y otra vez con la misma exposición (cientos o miles de tomas). O también podemos pensar que tenemos cientos o miles de celdas iguales funcionando en paralelo: esto es un sensor de imagen.

La SNR para cada celda la calculamos igual en ambos casos: SNR = S / N

Donde S es el número de fotones que habíamos calculado a partir de la exposición y el área. Y el ruido (N) consideramos que es fotónico, así que es la raíz cuadrada de S.

SNR = S / raíz(S) = raíz(S)

Podemos comparar las dos SNR para ver cuál es mayor:

SNR2 / SNR1 = raíz (2·S) / raíz (S)

SNR2 / SNR1 = raíz(2) = 1.41

Si lo expresamos en dB corresponde a unos 3dB y si lo expresamos en pasos de luz, corresponde a 1/2 paso.

Hasta aquí creo que todos estamos de acuerdo.

SNR en el sensor

Hablar de SNR a nivel de imagen es un poco más delicado. La SNR debida al ruido fotónico depende de la zona de la escena: zonas más oscuras tendrán un SNR menor, zonas más brillantes tendrán un SNR mayor.

Pero todos entendemos que una imagen con mayor SNR se percibirá en conjunto (en media) como una imagen con más calidad con respecto a otra con un SNR medio menor.

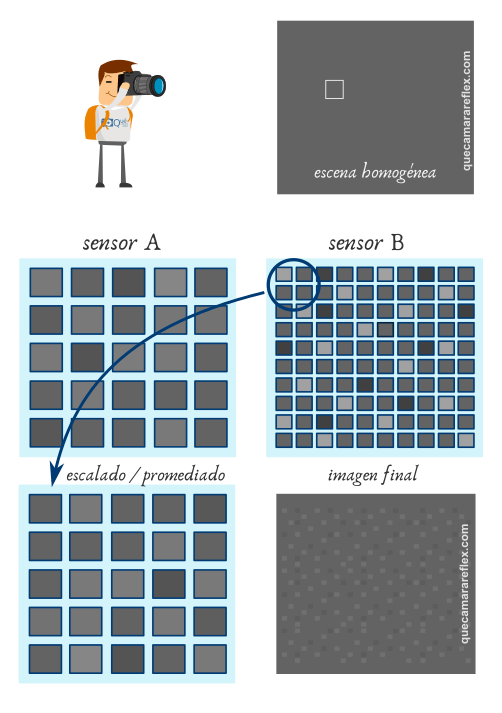

Vamos a imaginar ahora dos sensores que tienen celdas del mismo tamaño y la misma tecnología. Pero uno de los sensores tiene el doble de área.

* Olvida la relación de aspecto de los sensores de la imagen, sólo nos interesa la relación de áreas.

Aquí ya hay que introducir el concepto de resolución. La resolución nos da la relación entre el tamaño del sensor y el tamaño de cada celda. Cuando hablo de tamaños siempre me voy a referir a área, superficie.

Los dos sensores van a captar exactamente el mismo encuadre de la escena y con la misma exposición.

Las celdas son del mismo tamaño, por lo tanto ofrecerán en media la misma SNR, tanto en uno como en otro sensor.

La única diferencia entre las dos imágenes, es que una tiene el doble de resolución.

Si vemos las dos imágenes con lupa, las dos tendrán la misma calidad de imagen local.

Pero ahora te pregunto: ¿Cuál de las dos imágenes tendrá más calidad?

O dicho de otra forma, ¿cuál de ellas nos ofrece más información de la escena?

La imagen del sensor grande contiene más información de la escena: contiene la misma información tonal por punto (SNR local) pero además nos da más detalle. De hecho es como si hubiéramos hecho dos imágenes con el sensor pequeño y las hubiéramos cosido juntas.

¿Podemos estimar la SNR global de la imagen?

Por supuesto.

Podemos ver cuánta señal (fotones) ha captado el sensor en su conjunto, podemos calcular el ruido fotónico correspondiente, calcularíamos la SNR, y compararíamos.

fotones sensor 1 = E * A1

fotones sensor 2 = E * A2

No hace falta repetir los cálculos, porque son exactamente los mismos que para una celda individual. Lo puedes comprobar tú mismo.

Curiosamente, el doble de área implica (como mínimo) una ganancia en SNR de 1.41

SNR2 / SNR1 = raíz(2) = 1.41

La imagen del sensor grande (doble de área) tiene en media una SNR mejorada en 1.41 (medio paso) con respecto a la misma imagen generada por el sensor pequeño.

Un poco más arriba he escrito ‘como mínimo’, porque si se tienen en cuenta las demás contribuciones de ruido, la diferencia sería incluso mayor. Aunque, como digo, en la inmensa mayoría de las situaciones el ruido predominante es el fotónico, y la contribución de las demás fuentes inapreciable.

Imagen final (imagen útil)

A ver, ¿dónde está el truco? ¿dónde está la trampa?

No hay ningún truco.

La información de una escena la podemos recoger en diferentes ‘sabores’:

- Información tonal de cada punto

Celdas más grandes generarán una información tonal (local) más precisa, puntos con menor variabilidad. Aquí entraría la capacidad del sensor para captar un mayor rango dinámico. - Información espacial de la escena

La resolución nos ofrece más información sobre los detalles finos de la escena. - Color

El color lo podríamos considerar una característica que emerge a partir de las otras dos, así que lo vamos a omitir para no complicar.

La información RAW del sensor es una combinación de esos sabores. No tiene sentido pensar en una imagen de un único pixel (con un tono perfecto pero sin información espacial). O en una imagen de resolución tan alta que muchas celdas individuales no lleguen a captar un sólo fotón. Para recogr la información de la escena necesitamos la información espacial (resolución) y la información tonal (SNR en cada punto)

Con esa materia prima fabricamos la imagen final en función de nuestras necesidades.

La imagen final la fabricamos para usarla, no para mirarla con lupa y microscopio.

La sacaremos en papel fotográfico, o la publicaremos en alguna revista en papel, o la publicaremos en internet, etc.

En la inmensa mayoría de los casos, la resolución efectiva de la imagen final será menor que la resolución que proporciona el sensor.

Si no es así, bueno, pues imprimiremos con una calidad un poco inferior (dpi, dots per inch) o redimensionaremos la imagen hacia arriba usando algún algoritmo de interpolación.

Apilado, reescalado, binning

¿Qué efecto tiene el escalado?

El escalado hacia arriba (mediante algún tipo de interpolación) es más difícil de modelar porque literalmente estamos inventando información a partir de la que tenemos. No creamos información nueva, sino que expandimos la que tenemos. Y estaremos haciendo más visible el ruido.

El escalado hacia abajo (pasar de una resolución mayor a otra menor) es mucho más interesante para el tema que estamos tratando.

El ruido de la imagen no tiene normalmente correlación espacial local. La variabilidad es aleatoria y no tiene correlación con los detalles de la imagen.

El ruido fotónico tiene correlación con las zonas oscuras y claras de la escena, pero dada una zona concreta de la imagen, una región pequeña si quieres, sigue siendo un proceso aleatorio.

La cuestión es que cuando redimensionamos hacia abajo usamos la información espacial de varios puntos vecinos de la imagen original para generar un único punto de la imagen final.

Sumamos la señal, la información, de esos puntos.

El ruido medio de esos puntos lo sumamos igualmente, pero recuerda que el ruido suma en cuadratura (ya que no tiene correlación espacial local).

Vamos a suponer un reescalado 2 a 1. Imagina por ejemplo una imagen de 48Mpx reescalada a 24Mpx

Para cada punto tendremos aproximadamente el doble de señal, porque la información espacial sí está fuertemente correlada.

El nivel de ruido aumenta en un factor 1.41 (raíz de 2, ya que estamos haciendo un reescalado 2 a 1 y sumamos las dos contribuciones en cuadratura, como la hipotenusa de un triángulo)

Esta película ya la habíamos visto antes: efectivamente, la mejora media en SNR para cada punto de la imagen final es de 1.41 (medio paso)

Para finalizar, tendríamos normalizar los valores de cada punto de la imagen. Si hemos sumado la información de 2 puntos, tendremos que dividir por 2 para tener el valor de brillo medio de ese punto. Pero esta normalización no implica ningún cambio en el SNR de la imagen (dividimos tanto la señal como el ruido).

Las técnicas de apilado, reescalado y binning (agrupamiento de pixels) tienen un efecto muy similar.

- Apilado: hacer N tomas idénticas de la misma escena. Luego se combinan todas las tomas. La ganancia de SNR en la imagen final corresponde a raíz(N).

- Binning: combinar la información de N celdas vecinas del sensor para generar la información RAW de un único punto. Por ejemplo, en un sensor de 48Mpx podríamos hacer pixel binning 4:1 para generar una imagen de 12Mpx. La ganancia de SNR en la imagen final corresponde a raíz(N).

- Escalado hacia abajo. La técnica que hemos comentado: reescalar una imagen para reducir su resolución. La ganancia de SNR se corresponde con raíz(N), donde N es el ratio entre la resolución mayor original y la resolución menor de la imagen final.

Para hacer reescalado no hace falta que la resolución inicial sea múltiplo de la final, es decir, el ratio N no tiene que ser un valor entero exacto.

El reescalado de la imagen puede parecer algo esotérico que implica alguna edición complicada de la imagen, invocar a algún espíritu y usar la marmita con la pócima mágica.

Nada más lejos de la realidad…

El reescalado tiene lugar constantemente y lo ves todo el tiempo.

Cuando visualizamos una imagen en el monitor de un ordenador, vemos una versión reescalada. Para ver la versión original tendríamos que ampliar al 100% (pixel peeping).

Cuando visualizamos una fotografía en papel, vemos una versión reescalada.

Cuando visualizamos una imagen en la pantalla de un dispositivo pequeño estamos viendo una versión muy reescalada (la SNR de esa imagen final es mucho mayor que la de la imagen con la resolución original).

Nota: Todos estos procesos son estadísticos, y nuestras estimaciones se basan en esa estadística. Fíjate que siempre hablo de nivel medio, desviación típica, etc. La SNR global de la imagen es igualmente un valor estadístico. Puede ocurrir por ejemplo que una imagen tenga una SNR gobal muy buena, pero que haya zonas (zonas oscuras de la escena por ejemplo) con una SNR menor donde puede ser apreciable el ruido en condiciones de visualización estándar.

Nota: Para normalizar tamaño de sensor y resolución (equivalente a comparar con las imágenes en papel fotográfico y condiciones de visualización estándar) podríamos tomar como referencia un círculo de confusión, como hacemos para determinar la profundidad de campo. El círculo de confusión lo tendríamos que ajustar en función del tamaño del sensor. Pero complicaría mucho más la explicación y al final vamos a llegar a conclusiones similares.

Tamaño de sensor y tamaño de celda

A estas alturas del artículo ya deberíamos tener una visión global bastante buena del comportamiento del sensor en lo que respecta a la relación señal a ruido.

A nivel de celda está muy claro.

Y a nivel global de sensor también hemos visto que un sensor más grande recoge más información y que esa información extra se puede utilizar en la imagen final (dependiendo de su uso)

La SNR global de la imagen la marca el tamaño del sensor, no el tamaño de la celda.

El tamaño de celda te da la SNR local directa, la más evidente, que percibimos al visualizar la imagen al 100% de su resolución original (pixel peeping) y también la percibimos más en las zonas más oscuras de la escena.

El tamaño de sensor te da la SNR global de la imagen. De la imagen final que usamos en un determinado soporte físico: papel fotográfico, pantalla, etc.

Intenta probar tú mismo diferentes comparaciones: sensor grande con sensor pequeño, con una resolución o con otra. Para hacer una estimación de la ganancia en SNR.

En este artículo hacemos una comparación con sensores de cámaras comerciales.

¿Qué ocurre si el sensor más pequeño tiene celdas más grandes?

Pues ofrecerá imágenes con una SNR local mayor. Esto se notará sobre todo en las zonas más oscuras de la imagen.

Pero la SNR de la imagen final en su soporte físico de visualización será mayor en el caso del sensor grande.

Vamos a plantearlo en un ejemplo sencillo:

El sensor pequeño tiene N celdas y una superficie A1

El sensor grande tiene el doble de superficie, pero sus celdas tienen la mitad de área.

El área de la celda del sensor pequeño:

celda1 = A1 / N

El área de la celda del sensor grande (es la mitad):

celda2 = A1 / (2N)

Como ya hemos visto en los apartados anteriores, la SNR local del sensor pequeño será mayor:

SNR1 / SNR2 = raíz(2) = 1.41

SNR1 = 1.41 · SNR2

SNR2 = SNR1 / 1.41

¿Cuál es la resolución del sensor grande?

La podemos calcular a partir del área total, que es el doble que la del pequeño (2 · A1), dividida por el área de cada celda ( A1 / 2N )

res2 = (2 · A1) / ( A1 / 2N) = 4N

La resolución es 4 veces mayor.

¿Qué ganancia de SNR tendremos al redimensionar?

Es un reescalado 4 a 1, con lo que la ganancia de SNR es la raíz de 4

SNR res2 = 2 · SNR2

¿Cómo será entonces la SNR en la imagen final?

La imagen final puede ser la imagen directa del sensor pequeño por un lado y la imagen redimensionada (4:1) del sensor grande. Realmente da igual la resolución final, lo que importa es que estamos normalizando para comparar correctamente.

Es decir, comparamos con la misma resolución, que es equivalente a sacar en papel fotográfico o visualizar en una pantalla (sin ampliar al 100%)

La SNR total de la imagen del sensor pequeño corresponderá con su SNR por celda (ya que vamos a tomar su resolución directamente como referencia). Los valores absolutos de SNR tampoco nos interesan en este tipo de comparaciones, lo que queremos saber el la ganancia o diferencia de SNR entre dos sensores.

SNR sensor 1 = SNR1

La SNR total de la imagen del sensor grande la pondríamos en función de la del sensor pequeño. Su SNR local a nivel de celda, tal como habíamos calculado, y luego esa SNR la ajustamos con la ganancia de reescalado:

SNR sensor2 = ( SNR1 / 1.41 ) · 2

SNR sensor2 = 1.41 SNR sensor 1

Como vemos, la SNR global de la imagen final generada por el sensor grande es mayor, y justamente es la que esperaríamos: doble de área implica una ganancia de SNR de raíz de 2 (1.41)

¿Y si el sensor más pequeño tiene más resolución? ¿Y sensores del mismo tamaño? ¿Y …?

Te lo dejo como ejercicio.

Intenta probar diferentes combinaciones de tamaño de sensor y resolución.

Son matemáticas muy sencillas, porque sólo estamos usando relaciones (área de uno con respecto al otro, resolución, SNR de uno con respecto al otro) para comparar.

Puedes intentar probar con datos reales de sensores comerciales para hacer una estimación rápida de la mejora en SNR que tendría un sensor con respecto a otro.

Margen en SNR y margen en exposción

Cuando comparamos dos sensores nos interesa saber qué ventaja o margen de maniobra nos proporciona uno con respecto a otro.

Hemos visto el margen en SNR, por ejemplo:

SNR sensor2 = 1.41 SNR sensor 1

Pero en la práctica, el margen o la ganancia en SNR no nos dice mucho, nos gustaría saber el margen en exposición, es decir, cuántos pasos de luz de ventaja tendremos con un determinado sensor.

Esto es relativamente sencillo.

Como estamos suponiendo ruido fotónico, podemos estimar el número de fotones necesarios para conseguir una determinada SNR

SNR = raíz (S)

Donde S sería la señal, el número de fotones que recibe el sensor en este caso.

Para el ejemplo anterior, podemos sustituir la SNR de cada sensor:

raíz (S2) = 1.41 raíz(S1)

S2 = (1.41)² S1

S2 = 2 S1

¿Qué nos dice esto?

Nos dice que, en ese ejemplo, el sensor 2 recibe el doble de fotones que el sensor 1 para una determinada exposición.

¿Cómo podríamos hacer que la imagen del sensor 2 tuviera la misma SNR que el sensor 1?

Aumentando la exposición real para que reciba más fotones: una apertura mayor o un tiempo de exposición más largo.

Vamos a suponer que ajustamos el tiempo de exposición, que es un parámetro que depende de la cámara.

Para que el sensor 2 reciba los mismos fotones, tenemos que multiplicar el tiempo de exposición por 2 en este ejemplo:

t2 = 2 · t1

En fotografía normalmente estamos más cómodos hablando en pasos de luz. Doblar el tiempo de exposición implica subir un paso el tiempo de exposición.

Por ejemplo, si en el sensor 1 tenemos un tiempo de exposición de t1=1/100s

… en el sensor 2 tendríamos que doblar el tiempo de exposición: t2 = 1/50s

Como hemos visto, la ganancia o margen en exposición la podemos calcular elevando al cuadrado la ganancia total en SNR.

t2 = (SNR1/SNR2)² · t1

Puedes comprobar que si nos dan la ganancia de SNR en pasos de luz, el margen en exposición correspondiente lo calculamos multiplicando por 2. Por ejemplo:

SNR sensor2 = 1.41 SNR sensor 1

t2 = 2 · (1.41) · t1 = 2 · t1

En pasos de luz:

SNR2 = SNR1 + 1/2 EV

t2 = t1 + 2 · (1/2) EV = t1 + 1 EV

En este artículo hacemos una comparación con sensores de cámaras comerciales.

¿Influye el área de la celda en el SNR global?

Lo cierto es que influye muy poco.

En nuestro proceso de cálculo, en nuestro modelo, hemos ido paso a paso: primero SNR local y luego aplicamos la ganancia en SNR del reescalado.

Es una forma muy intuitiva, porque el SNR por celda es fácil de entender, pero la normalización para comparar imágenes de diferentes sensores no es tan evidente y es donde surgen muchas de las dudas y malentendidos.

Ahora ya hemos entendido el proceso.

Pero a poco que juegues con las ecuaciones te darás cuenta de que estamos dando una gran vuelta para llegar al final al punto de partida, porque el área de celda (SNR local) y la resolución son parámetros que están relacionados entre sí, no son parámetros independientes.

Cuando aplicamos la ganancia por reescalado, lo que hacemos realmente es normalizar el tamaño de área de celda.

Es decir, el área de la celda desaparece del modelo. Piénsalo.

Podríamos calcular la ganancia de SNR directamente a partir de los tamaños de los sensores, de sus áreas, sin necesidad de entrar en detalles sobre resolución o tamaño de celda.

SNR1 / SNR2 = raíz (A1 / A2)

Para el ejemplo del sensor con el doble de área:

SNR1 / SNR2 = raíz ( 2·A2 / A2 )

SNR1 / SNR2 = 1.41

Y para el margen en exposición es más sencillo todavía. Como:

t2 = (SNR1/SNR2)² · t1

Nos queda que el margen en exposición nos lo da directamente la relación entre los tamaños de los sensores:

t2 = (A1 / A2) · t1

t2 = (2A2 / A2) · t1

t2 = 2 · t1

El ISO

La mayoría de las veces hablamos de margen de exposición refiriéndonos al parámetro ISO de la cámara.

«Esta cámara la puedo subir a ISO 6400 y me da una imagen ‘perfecta’… pero esa otra sólo la puedo subir a ISO 1600»

Si traducimos, estamos diciendo:

Dadas unas condiciones de iluminación de la escena y un objetivo con una determinada apertura, quiero configurar velocidad de obturación más alta que sea posible (por ejemplo para evitar que la foto salga movida o para evitar trepidación)

El ISO no tiene nada que ver con el ruido. El valor de ISO lo utilizamos para compensar que estamos recibiendo menos fotones (el hecho de recibir menos fotones es lo que baja la SNR)

Para la primera cámara imagina que configuramos:

t1=1/125s | ISO 6400

Para la segunda cámara no podemos subir tanto el ISO, lo tenemos que dejar 2 pasos más bajo, así que tendremos que configurar un tiempo de exposición más lento (2 pasos más lento)

t2 = 1/30s | ISO 1600

Las dos fotos tendrán la misma exposición aparente. Las dos fotos tendrán una SNR global similar.

Pero con la cámara 2, como tenemos menos margen, estamos jugando con fuego con el tema de la trepidación o si tenemos movimiento en la escena (riesgo de foto movida).

Hablamos de ISO habitualmente porque es el parámetro comodín.

Y porque tenemos esa idea intutiva (pero errónea) de que lo que causa el ruido es el ISO. Más ISO, más ruido… y punto pelota, sin pararnos a pensar qué está ocurriendo realmente.

Sensor grande vs sensor pequeño… en el mundo real

¿Todo eso se cumple en el mundo real, con sensores de verdad, escenas reales, etc.?

Todo lo que hemos comentado refleja bastante bien el comportamiento real, sobre todo en el régimen habitual de trabajo de los sensores de cámaras comerciales (en las situaciones típicas que fotografiamos en el día a día, donde predomina el ruido fotónico).

Si entiendes bien todo lo que hemos visto en este artículo (SNR y su relación con el área de captación, el efecto del reescalado y el umbral que impone la percepción visual humana) tendrás ya una visión global bastante acertada del comportamiento de los sensores y lo que entendemos como calidad de imagen en este contexto.

Pero parece lógico pensar que un modelo tan sencillo no puede recoger todos los matices y variantes.

Eficiencia cuántica

Todo lo que hemos comentado se basa en la premisa de que los sensores tienen una tecnología similar, por ejemplo que su eficiencia cuántica es similar.

De los fotones que llegan al material fotosensible, sólo un porcentaje de ellos consigue liberar un electrón. La eficiencia cuántica del material depende de la longitud de onda del fotón, no es constante a lo largo del espectro visible. El pico de eficiencia suele estar en la zona central del espectro.

La eficiencia también tiene que ver con la construcción del sensor. En sensores antiguos, muchos de los fotones ni siquiera llegaban al material fotosensible, eran absorbidos o reflejados por la circuitería que formaba parte de la celda o por las zonas neutras que separan una celda de otra. El uso de microlentes o la tecnología BSI mejoran la eficiencia, haciendo que esos fotones ‘perdidos’ lleguen de forma efectiva al material fotosensible.

La eficiencia cuántica del sensor puede influir bastante.

El rango de eficiencias cuánticas (pico) de diferentes sensores más o menos actuales puede ir desde el 50% al 80%

La eficiencia cuántica la podríamos aplicar directamente en nuestro modelo, multiplicando al área real de la superficie de captación. Eso nos daría el área de captación efectiva, tanto para la celda como para el sensor.

Aquí puedes ver cómo influye la eficiencia cuántica a partir de datos de sensores reales.

Resolución y área efectiva

Las celdas del sensor no forman un continuo, tienen una pequeña separación entre sí.

Eso quiere decir que a medida que aumenta la resolución se pierde una pequeña parte de superficie de captación, se reduce la superficie efectiva total y la superficie por celda.

Si pensamos en dos sensores del mismo tamaño, con la misma tecnología, pero con una resolución muy diferente… Probablemente el sensor con mayor resolución ofrecerá una SNR global un pelín menor, simplemente porque el material fotosensible activo no puede aprovechar toda la superficie física.

Rango dinámico y tamaño de celda

El rango dinámico que es capaz de captar un sensor depende bastante del tamaño de celda (capacidad del depósito de electrones, full well capacity).

El rango dinámico también viene limitado por el ruido (SNR mínimo aceptable), pero este SNR hemos visto que lo podemos compensar con el reescalado.

Así que en general, un sensor con celdas más grandes tendrá probablemente un mejor rendimiento en lo que respecta al rango dinámico (a costa de la resolución).

SNR en zonas oscuras de la imagen

La naturaleza del ruido fotónico hace que la SNR local en zonas oscuras de la imagen sea peor que la SNR local en zonas brillantes.

Además, la corrección gamma que se aplica a la imagen cuando se pasa a un espacio de color tiene el efecto de expandir el ruido en esas zonas oscuras (haciéndolo más visible) y comprimir el ruido en las zonas más brillantes.

Podemos tener una imagen con una SNR global excelente, pero en la que se percibe ruido en determinadas zonas oscuras, sombras profundas.

El tamaño de celda influye en la SNR local.

Por eso, en el diseño de sensores de propósito general se busca un equilibrio entre tamaño de celda y resolución.

Ruido de lectura

La evolución tecnológica de los sensores también ha permitido reducir cada vez más el ruido de lectura.

Este tipo de ruido tiene predominancia en situaciones con muy poca luz, del orden de unos pocos fotones por unidad de área, y tiempos de exposición muy cortos, que se corresponde habitualmente con fotografía con ISO muy alto (pero recuerda que el ruido no es debido a subir el parámetro ISO) .

En esas situaciones, el nivel de ruido de lectura tiene más presencia que el ruido fotónico.

También puede ser predominante en escenas en las que hay zonas tan oscuras que las podemos considerar casi negro puro. Las celdas del sensor que corresponden a esas zonas reciben muy pocos fotones.

El ruido de lectura depende de la circuitería y diseño del sensor (y de la temperatura de uso), en principio no depende de su tamaño.

Eso quiere decir que para determinadas situaciones o para esas zonas de sombras intensas de la imagen, algunos sensores más pequeños con tecnología más moderna pueden tener mejor rendimiento que sensores más grandes pero con tecnología más antigua.

El ruido de lectura ‘disminuye’ a medida que aumentamos el valor de ISO. Dadas unas condiciones en las que no podemos hacer que lleguen más fotones al sensor (no podemos aumentar el tiempo de exposición, ni aumentar la apertura, ni cambiar las condiciones de iluminación), subir el valor de ISO hace que aumente la SNR. Esto sólo se cumple hasta un cierto valor, hasta que se alcanza un umbral de invarianza ISO. Los sensores llamados ISO invariantes (o ISOless, un nombre horrible) tienen un ruido de lectura tan bajo que la invarianza ISO se alcanza muy pronto, con ISO relativamente bajo. En cualquier caso, suele ser siempre preferible subir ISO en cámara en lugar de subexponer para subir la exposición en la fase de revelado RAW y edición.

Sensores Dual ISO

Estos sensores están diseñados de tal forma que su comportamiento está separado en dos regímenes de funcionamiento diferentes.

Para ISOs bajos se supone que el sensor trabaja con luz suficiente, y se maximiza el rango dinámico. El sensor trabaja con un depósito de electrones de gran capacidad y la señal necesita una cierta amplificación electrónica.

A partir de un determinado ISO se supone que el sensor trabaja en situaciones de menos luz y se intenta minimizar el ruido. El sensor comienza a trabajar con un depósito más pequeño y la ganancia electrónica se reduce, lo que reduce a su vez parte de la contribución de ruido y aumenta la SNR de la señal.

Aquí tienes más información sobre los sensores Dual ISO

El salto de un régimen de trabajo a otro lo podríamos entender como un cambio de ‘eficiencia cuántica’ del sensor.

Así que cuando comparamos sensores Dual ISO entre sí o los comparamos con sensores más tradicionales hay que tener en cuenta en qué franja de ISO está trabajando cada sensor en cada situación concreta.

ISO extendido

Los valores de ISO nativos se corresponden con ganancias en la señal debidas a amplificadores electrónicos, al reescalado del depósito o técnicas similares, que tienen que ver con la señal analógica (fotones, electrones, voltajes)

Los valores de ISO extendidos son todos los que realizan algún tipo de interpolación digital a partir de los datos de la señal analógica.

Por ejemplo algunas cámaras sólo hacen amplificación analógica para ciertos valores: ISO 200, ISO 400, ISO 800 … mientras que valores intermedios (p.e. ISO 640) se simulan modificando los valores RAW.

Y en prácticamente todas las cámaras, hay una serie de valores ISO extendidos más allá de un cierto ISO nativo máximo. Por ejemplo, el ISO nativo máximo puede ser ISO 6400 en una determinada cámara, pero luego ofrece la posibilidad de elegir ISOs más altos: 12600, 25600, … Y lo mismo ocurre para ISOs que están por debajo del ISO nativo mínimo (ISO base)

En esos ISOs extendidos no hay ninguna ganancia de SNR ni ninguna ventaja ‘real’ con respecto al ISO nativo más cercano. Estan por conveniencia. Se podría conseguir el mismo resultado usando un ISO nativo y modificando la exposición a posteriori en la fase de revelado RAW.

En esos rangos de ISO extendido (ISO 25600, ISO 51200, ISO 102400…) no sé si tendría mucho sentido la comparación entre sensores.

Reescalado

La eficiencia del reescalado puede ser bastante dependiente del algoritmo utilizado. Los algoritmos de reescalado que suelen usar los programas de edición tienen a potenciar más el contraste y pueden interferir en algunos casos. Pero bueno, en general todos los algoritmos darán una ganancia de SNR.

El reescalado del que he hablado aquí estaría basado exclusivamente en la información que contiene la imagen original.

En la actualidad hay muchos algoritmos de reescalado y limpieza de ruido basados en redes neuronales (inteligencia artificial). Ese tipo de reescalado no utiliza exclusivamente la información contenida en la imagen, sino que de alguna forma aporta información externa a partir de millones y millones de imágenes usadas en el entrenamiento de la red.

Percepción visual

Muy importante también la percepción visual humana y el umbral de SNR.

A partir de un cierto valor de SNR, por ejemplo los 30dB que hemos comentado, vamos a percibir todas las imágenes con una calidad similar (excelentes).

Con las condiciones adecuadas de iluminación de la escena todos los sensores (grandes y pequeños) generarán imágenes con SNR que supera ese umbral y se percibirán excelentes. La diferencia de SNR estará ahí (al menos en los datos RAW del sensor), pero no será perceptible en la imagen final.

Es muy importante entender también que las condiciones de visualización cambian la percepción.

Nos encanta comparar imágenes al 100%, al 200%, al 500% para intentar ver hasta el rastro cuántico de los fotones, pero lo que percibimos en esas condiciones no tiene nada que ver con lo que percibimos cuando vemos la imagen en su soporte final y en las condiciones de uso normales. Recuerda el efecto del reescalado y el umbral de percepción.

Y si hablamos de percepción, hablamos por supuesto de subjetividad.

Cada persona tiene su propio criterio en lo que respecta al nivel de ruido (percibido) aceptable en una imagen.

Y percepción implica también todo tipo de sesgos, que todos tenemos. Por ejemplo, alguien que esté muy ‘obsesionado’ con el ruido, verá ruido en todas las imágenes: en las fotos, en las películas, en las series…

Mientras que alguien que no sepa ni qué es el ruido posiblemente ni será consciente al visualizar las imágenes, ni le dará mayor importancia, a menos que sea ya un ruido catastrófico muy evidente.

Por poner un ejemplo de subjetividad: el grano analógico (ruido en fotos de película fotográfica) es más ‘agradable’ para muchos que el ruido digital. Yo también me incluyo. Y el grano en blanco y negro más agradable que el ruido en color. Pero no deja de ser algo totalmente subjetivo, es ruido igualmente.

Cuando hablamos de percepción de ruido, el componente subjetivo está ahí.

¿Es tan importante el tamaño del sensor?

Respuesta de ingeniero: depende.

Respuesta corta: no, en la inmensa mayoría de las situaciones no es tan importante.

Es decir, en este contexto concreto, en el que estamos hablando de ruido en la imagen, de SNR, de calidad de imagen.

Cuando usamos la cámara con una buena iluminación de la escena, literalmente sobra luz.

Y todas las cámaras, incluyendo las de móviles sin utilizar fotografía computacional ofrecen una calidad de imagen excelente (por encima de esos 30dB de SNR que comentábamos)

Un fotógrafo que trabaje en estudio, con iluminación controlada, puede usar básicamente la cámara que le dé la gana. Puede controlar la cantidad de luz y puede controlar el rango dinámico de la escena.

Si vas a hacer un tipo de fotografía en la que necesitas captar un rango dinámico muy amplio, probablemente un sensor pequeño limitará un poco más.

Por ejemplo, en fotografía de paisaje se busca un equilibrio entre resolución (detalle) y rango dinámico.

Un sensor más grande permite ofrecer una resolución relativamente alta usando celdas relativamente grandes.

¿Cuándo tiene ventaja un sensor más grande?

Imagina que vamos bajando progresivamente la iluminación de la escena.

Vamos a suponer que todas las cámaras montan una óptica similar (apertura) y que los sensores son de tecnología similar.

El tiempo de exposición lo dejamos fijo. Imagina por ejemplo que necesitamos congelar el movimiento de una escena. Así que la exposición real (número de fotones por unidad de área) sólo cambia debido a las condiciones de luz de la escena.

Ajustaremos el valor de ISO cada cierto tiempo para tener una cierta exposición aparente homogénea en todas las fotos.

Como digo, poco a poco baja el nivel de luz de la escena, y por tanto cada vez llegan menos fotones.

Inicialmente todas las fotos se ven perfectas (SNR global por encima de 30dB)

Llegará un momento, un nivel de luz, para el que la cámara con sensor más pequeño, por ejemplo la de un móvil (sin aplicar fotografía computacional), no podrá generar imágenes con esa relación de 30dB, ya se empezará a notar visualmente el ruido.

Mientras tanto, otra cámara por ejemplo con sensor de 1 pulgada seguirá ofreciendo imágenes con SNR > 30dB.

Sigue bajando la iluminación…

Las imágenes del sensor de 1 pulgada ya empezarán a caer por debajo de los 30dB

Luego le llegará el turno al sensor Micro 4/3

Luego al sensor APS-C.

Y finalmente al sensor Full Frame, llegará un nivel de iluminación para el que comienza a generar imágenes con ruido bastante visible.

Si tuviéramos un sensor más grande, por ejemplo una cámara de formato mediano (sí, lo llamo formato mediano, no ‘formato medio‘, ni ‘medio formato‘, me gusta más el término ‘formato mediano‘) tendríamos otro margen adicional.

Y con una cámara de gran formato, por ejemplo una cámara de película de 8 x 10″, tendríamos más margen incluso.

Pero finalmente llegaríamos a un nivel de iluminación en el que ninguna de las cámaras ofrecería imágenes por encima del umbral de 30dB.

Llegados a ese punto, en todas las imágenes sería apreciable el ruido, y podríamos comparar el efecto de las diferencias en SNR.

La imagen del sensor más pequeño se percibirá con una calidad muchísimo peor que la del sensor más grande.

Y si quisiéramos ‘recuperar’ la imagen en edición, sería muy problemático recuperar una imagen en la que su SNR es muy bajo.

Margen de maniobra

Un sensor más grande nos da básicamente un pequeño margen adicional para situaciones de menos luz.

O por ejemplo en situaciones en las que necesitamos una velocidad de obturación alta pero no hay luz suficiente en la escena: fotografía deportiva (sobre todo indoor), niños, mascotas… objetos en movimiento…

A igualdad de condiciones, y si la imagen final queda en cualquier caso por debajo del umbral de los 30dB de SNR, la imagen que viene del sensor más grande tendrá una SNR mayor, el ruido será un poco menos perceptible, será más fácil de recuperar a posteriori (para subir hasta los 30dB)

Ese margen adicional lo podemos medir en ganancia de SNR.

Pero fíjate que para conseguir una ganancia de 1/2 paso de SNR (3dB / ganancia de 1.41) hace falta un sensor con el doble de superficie.

Ganar SNR a partir del área de captación es ‘costoso‘, muy costoso si tenemos en cuenta la parte óptica correspondiente.

Otra forma de medir el margen que nos da un sensor más grande es pensar en la exposición necesaria para conseguir una cierta SNR.

Si pensamos en términos de exposición, un sensor con el doble de superficie necesita la mitad de exposición para generar la misma SNR. Es decir, un sensor con el doble de tamaño tiene 1 paso de luz de margen.

Si el sensor pequeño (mitad) tiene que disparar por ejemplo a 1/125s, el sensor grande puede disparar a 1/250s, subir un paso de ISO para compensar la exposición aparente, y tendrá una imagen con la misma calidad que el sensor pequeño (suponiendo la misma apertura, tecnología, etc.)

¿Qué margen o diferencia real hay entre sensores de diferente tamaño?

Entre un móvil de gama media / alta y una cámara con sensor de 1 pulgada: 2 pasos de luz (aprox. 2 EV)

[OJO: suponiendo que el móvil no utiliza técnicas de fotografía computacional]

Entre un sensor de 1 pulgada y un sensor Micro 4/3: algo más de 1 paso (aprox. 1 EV)

Entre un sensor Micro 4/3 y un sensor APS-C: 2/3 de paso (aprox. 0.7 EV)

Entre un sensor APS-C y un sensor Full Frame: 1 paso y 1/3 aproximadamente (aprox. 1.3 EV)

Estas diferencias son sólo aproximadas y con cámaras / sensores de tecnología similar. Y todas las consideraciones que hemos comentado a lo largo del artículo: régimen de ruido fotónico, etc.

Es sólo para tener una referencia mental…

…y para darnos cuenta de que las cámaras no son algo mágico.

Fíjate que por ejemplo una cámara Micro 4/3, una APS-C y una Full Frame están todas en un margen de unos 2 pasos de luz de diferencia.

Una cuestión de equilibrio

¿El margen adicional que ofrece un sensor grande es mucho o es poco?

Para los sensores típicos: Full Frame, APS-C y Micro 4/3

Hablamos de un rango de 2 pasos en exposición y 1 paso en SNR de diferencia entre Micro 4/3 y Full Frame.

Habrá situaciones, y tipos de fotografía, en los que esos 2 pasos en exposición pueden marcar la diferencia.

Esos 2 pasos también se pueden conseguir con la parte óptica (por ejemplo usando un objetivo con mayor apertura). Hasta ahora estamos suponiendo la misma óptica en nuestras comparaciones.

Pero la parte óptica no escala de forma lineal con el tamaño del sensor. El coste, el tamaño y el peso de la parte óptica crecen de forma exponencial a medida que crece el tamaño del sensor.

El coste, el tamaño y el peso del equipo lo marca sobre todo la parte óptica, no tanto la cámara.

Cuando ponemos en la balanza todos los aspectos: calidad de imagen (SNR), costes, tamaño, peso… y las situaciones particulares de uso (cuándo beneficia el factor de recorte, cuándo beneficia un sensor más grande)…

Es cuando tenemos que valorar realmente qué herramienta es más útil.

Cada persona, cada usuario, tiene unas necesidades, unas preferencias y un presupuesto.

Elegir el equipo es siempre una cuestión de equilibrio: qué ventajas (reales) voy a obtener y qué estoy dispuesto a sacrificar.

¿Por qué no suelo recomendar cámaras con sensor Full Frame? (para alguien que empieza o incluso para la inmensa mayoría de fotógrafos aficionados)

Resumen y conclusiones

Recuerda que en este contexto, cuando hablamos de calidad de imagen nos estamos refiriendo sólo a la percepción de ruido en la imagen.

Ideas clave que hemos visto:

- La exposición no depende del tamaño del sensor

Nos dice la cantidad de luz que recibe el sensor (o lo que quiera que esté ahí colocado) por unidad de área: fotones / mm2 - La exposición que percibimos en la imagen también depende del valor de ISO

Aunque la exposición real mide la luz recibida, en la mayoría de los casos hablamos del triángulo de exposición, incluyendo la apertura del diafragma, el tiempo de exposición (velocidad de obturación) y la ‘sensibilidad‘ (ISO) - Cualquier cámara comercial con los mismos parámetros: apertura, obturación e ISO producirá una imagen similar en cuanto a su brillo / luminosidad.

Los valores de ISO están calibrados de tal forma que cumplan ese criterio de brillo percibido en la imagen final. - Los sensores más grandes reciben más luz

La cantidad de luz total (fotones) depende de la exposición y de la superficie total del sensor.

Mayor superficie implica siempre mayor número de fotones. Da igual si pensamos en términos de fotones por celda o fotones totales captados por el sensor. - La calidad de la imagen depende de la relación señal a ruido

Cuanto mayor es la SNR, mejor será la calidad de imagen.

Cuanto menor es la SNR, más perceptible será el ruido, en forma de granulado y artefactos de color. - Se considera que con SNR > 30dB es una imagen con muy buena calidad

En última instancia la percepción del ruido digital en la imagen es una cuestión subjetiva, cada persona tiene sus propios criterios de lo que considera una imagen excelente, aceptable y mala (no usable) - Sensores más grandes: imágenes con mejor SNR (más calidad)

Como regla general, a igualdad tecnológica y con la misma exposición (iluminación de la escena, apertura y tiempo de exposición), el sensor grande captará más información de la escena.

La SNR global de la imagen será mayor. - Sensores de igual tamaño pero diferente resolución:

Suponiendo tecnología similar, misma exposición, etc. los dos sensores ofrecerán imágenes con una SNR global similar una vez escaladas a una resolución útil.

Aumentar la resolución puede suponer una pequeña pérdida de área efectiva de captación. Un sensor con una resolución muy alta puede tener una pequeña pérdida de SNR con respecto a otro del mismo tamaño pero de una resolución bastante menor. - Regla de oro:

Para comparar la calidad de dos imágenes deberíamos hacerlo con sus copias finales: por ejemplo las copias en papel o las imágenes en su tamaño real de publicación.

O al menos tendríamos que reescalar para comparar a la misma resolución.

No tiene mucha utilidad comparar (al 100% por ejemplo, haciendo pixel peeping) imágenes con diferente resolución. - Todas las cámaras producen imágenes excelentes con buena luz

En esas situaciones la SNR es alta en todos los casos y el nivel de ruido se puede considerar despreciable porque no es perceptible en condiciones de visualización estándar.

Las posibles diferencias estarían más en la calidad óptica de los objetivos o en otros factores externos. - La diferencia de rendimiento (SNR) entre sensores sólo va a ser apreciable en determinadas situaciones

Por ejemplo en situaciones con poca luz o en situaciones en las que se necesitan velocidades de obturación muy altas y no hay luz suficiente en la escena.

En la práctica hay muchísimas variantes y situaciones diferentes, porque la óptica y el criterio artístico (profundidad de campo, ángulo de visión, etc.) va a condicionar mucho los resultados finales. - Las diferencias entre sensores de diferentes tamaños son graduales

Por ejemplo la diferencia entre un sensor APS-C y un sensor Micro 4/3 es mínima, en la mayoría de las situaciones sería inapreciable.

Un sensor Full Frame daría una ventaja de algo más de 1 paso de luz (en exposición) con respecto a un sensor APS-C.

Si lo piensas, es una ventaja marginal.

Más información

- ¿Cómo funciona un sensor de imagen?

- Ejemplos comparando algunos sensores de cámaras comerciales

- ¿Por qué no suelo recomendar cámaras con sensor Full Frame? (aficionados y aficionados avanzados)

- Serie sobre sensores de imagen (todos los artículos relacionados con sensores)

- Fuentes de ruido en sensores de imagen

- Cámaras de fotos recomendadas: guías y criterios de elección

- Cámaras recomendadas para aprender fotografía

- Cámaras réflex recomendadas por gama / tipo de usuario

- Cámara para fotografiar a bebés y niños pequeños

Criterios de elección de cámaras y equipo

- Cámaras réflex: modelos, características y precios

- Cámaras de fotos recomendadas: guías y criterios de elección

- Cámaras recomendadas para aprender fotografía

- Cámaras réflex recomendadas por gama / tipo de usuario

- Cámara para fotografiar a bebés y niños pequeños

- Cámaras recomendadas para vlogging