No hace falta ser físico de partículas para hacer una foto, pero te recomiendo que leas esta información para tener una idea básica de cómo funciona el sensor de una cámara digital, sus limitaciones y los parámetros con los que juega un fotógrafo para sacar partido de la cámara.

Índice rápido de contenidos:

- Cómo funciona el sensor de una cámara digital

- Tamaños de los sensores más utilizados en cámaras réflex y cámaras EVIL

- Ruido, ISO y características del sensor (si no te interesa la parte técnica salta al resumen rápido más abajo)

Señal y ruido

Número de fotones (cantidad de luz) y SNR

Tamaño de celda (densidad de pixel) y ruido

Tamaño de sensor y ruido

¿Qué es más importante, el tamaño de celda o el tamaño de sensor?

ISO y ruido - Resolución del sensor, resolución óptica y nitidez

- Resumen rápido con respecto al rendimiento de los sensores

Funcionamiento del sensor

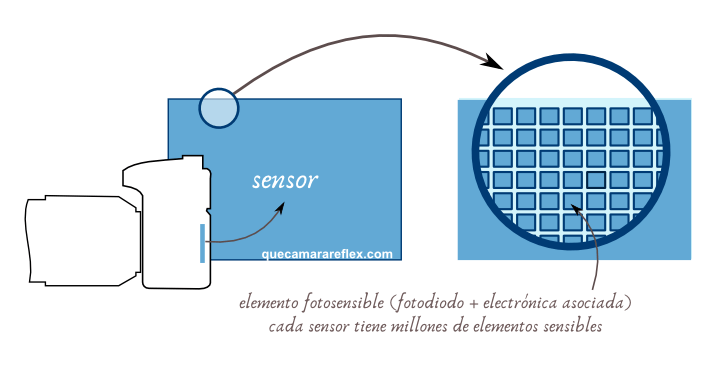

El sensor de una cámara digital es una auténtica obra de ingeniería.

Está formado por millones de celdas fotosensibles, cada una de ellas de tamaño microscópico:

Piensa que cuando nos hablan de megapíxeles (Mpx) se corresponde con los millones de píxeles (celdas) que forman parte del sensor de nuestra cámara.

Por ejemplo una cámara con un sensor APS-C (aprox. 23 x 15 mm) de 20Mpx tiene 20 millones de celdas fotosensibles con un tamaño de unos 4 micrómetros (1 micrómetro es la milésima parte de 1 milímetro)

El término píxel hace referencia a un punto de la imagen digital final. Y aunque no es del todo correcto llamar píxel a la celda del sensor, lo voy a utilizar indistintamente a lo largo del artículo, además en el 99% de la literatura sobre el tema lo vas a encontrar así también.

Conversión de fotones a electrones

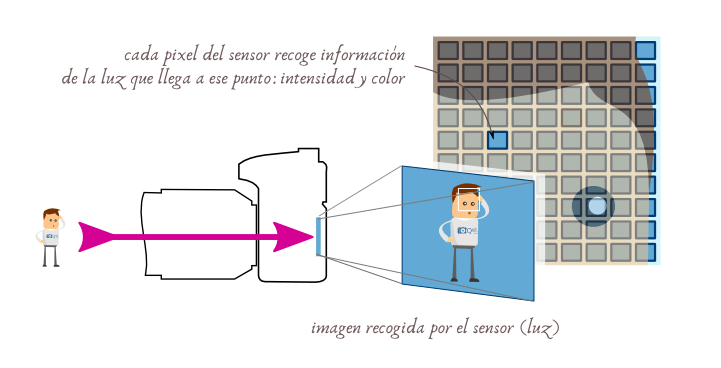

Cuando tomamos una foto, cada celda del sensor analiza la luz que le llega a ese punto: una pequeñísima parte de la imagen de la escena que queremos fotografiar.

Cada celda incluye material fotosensible que convierte la luz en electricidad.

Además incluye la electrónica necesaria para que cada elemento funcione de forma independiente y para poder leer la información de cada píxel cada vez que hacemos una foto.

En la mayoría de los sensores actuales, cada celda incluye además una pequeña lente individual para concentrar la luz en la superficie sensible. ¿Imaginas el tamaño de esas micro-lentes?

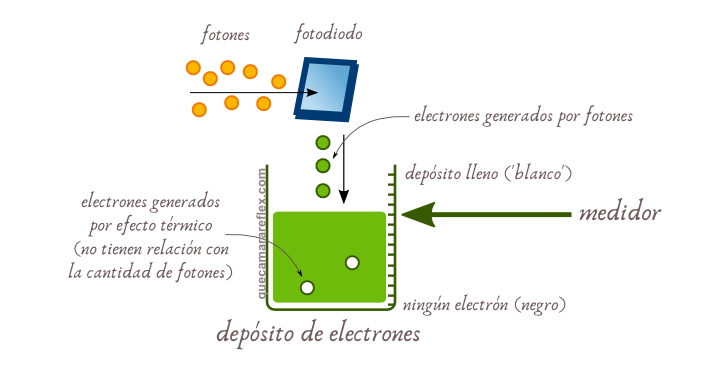

Cada fotodiodo (elemento fotosensible de la celda) funciona como un panel solar: recibe fotones que, al interactuar con los átomos del material, hacen que algunos electrones ‘escapen’ de la zona de influencia del núcleo.

Esos electrones libres se pueden acumular en una parte de la celda, que llamaremos depósito.

Sensores CMOS

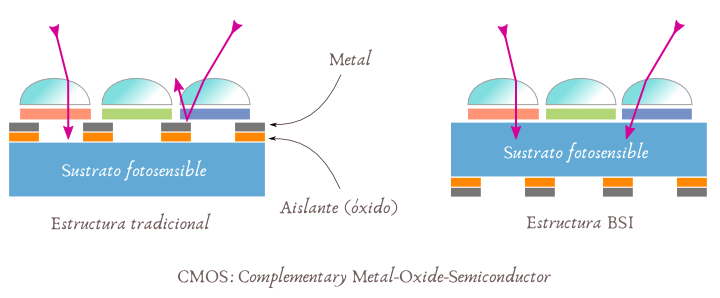

Actualmente la mayoría de los sensores están basados en tecnología CMOS (Complementary Metal-Oxide-Semiconductor).

Sobre el material fotosensible se añade la circuitería electrónica, compuesta por capas de zonas aislantes (óxidos) y metal.

El método tradicional de fabricación consiste en hacer ‘crecer’ la circuitería hacia arriba sobre el sustrato de silicio, y sobre esta estructura electrónica se coloca el filtro RGB (de Bayer por ejemplo, más abajo hablo sobre el color) y la estructura de micro-lentes.

La parte electrónica ocupa una superficie muy pequeña pero incluso así, parte de la luz se refleja o se absorbe en estas capas y no llega al material fotosensible.

Sensores BSI (CMOS BSI)

Los sensores BSI (Back-Side Illuminated sensor) se basan en un método de fabricación diferente: toda la circuitería y estructura CMOS va colocada en la parte inferior del material fotosensible.

Es como si diéramos la vuelta al sensor y lo iluminamos por la parte de atrás, aunque el nombre posiblemente no es muy afortunado y suele llevar a confusión.

En cualquier caso, esta estructura consigue una mejora apreciable de rendimiento, ya que no se pierden fotones en las capas superiores.

Este método de fabricación es más caro y hasta ahora sólo se aplicaba a sensores de pequeño tamaño, pero a medida que se abaratan los costes va estando disponible en los sensores más grandes.

¿Cómo se captura el color?

Las celdas fotosensibles sólo pueden detectar la intensidad de la luz (número de fotones a lo largo de un determinado tiempo), no el color.

Los sensores incluyen filtros ópticos (filtros RGB) que descomponen la luz en tres componentes: rojo, verde y azul.

En la mayoría de los sensores se utiliza un distribución de filtros que sigue un patrón o mosaico de Bayer, de tal forma que unas celdas reciben sólo la luz correspondiente a la componente roja, otras sólo la componente azul y otras sólo la componente verde.

Una variante de filtro RGB es el X-Trans de Fuji, que sigue el mismo principio de funcionamiento pero la distribución de los filtros R, G y B es diferente.

En los sensores Foveon cada celda del sensor incluye los tres filtros, RGB, pero apilados en vertical.

Si te fijas, en los sensores Bayer / X-Trans esa información de color que recoge el sensor es sólo parcial, ya que para cada punto de la escena sólo se recoge la información de uno de los colores primarios.

El color real de cada punto hay que interpretarlo a posteriori con algoritmos de interpolación cromática (demosaicing) y balance de blancos.

Los filtros RGB son en realidad RGGB, hay dos filtros de color verde (G – Green) por cada filtro R (red) y B (blue).

Esto es así sobre todo porque la visión humana otorga mucha importancia a la luminancia (niveles de claro a oscuro) con respecto a la información de color y la zona verde del espectro visible es la que más aporta a la información de luminancia (por encima del 70%).

Hemos comentado que cada fotodiodo recibe una de las componentes (roja, verde o azul) pero desde el punto de vista del fotodiodo es simplemente luz (fotones), así que para los ejemplos de funcionamiento que vienen a continuación da igual si es luz blanca o filtrada. Imagina que retiramos el filtro Bayer de la parte superior y nos quedamos con una imagen en blanco y negro de la escena, donde cada celda del sensor se corresponde con un pixel de la imagen.

¿Cómo se capta la imagen en el sensor?

La celda del sensor funciona de la siguiente forma: cuando pulsamos el disparador de la cámara para hacer una foto abrimos el obturador y dejamos pasar fotones que llegan al fotodiodo.

El fotodiodo los va convirtiendo en electrones, que se acumulan en un pequeño depósito (condensador).

Cuando se cierra el obturador de la cámara (deja de pasar luz) cada celda del sensor tendrá un determinado nivel de electrones almacenados en su depósito.

El número de electrones es proporcional a la cantidad de fotones que ha recibido ese trocito de la imagen.

Si una celda no tiene electrones querrá decir que no ha recibido ningún fotón (zona oscura de la imagen).

Si una celda tiene su depósito lleno de electrones se corresponderá con una zona blanca de la imagen (zona muy brillante).

La electrónica de la cámara se encarga de leer una por una todas las celdas del sensor.

Y a cada uno de esos niveles le asigna un valor numérico.

Por ejemplo en un sensor de 8 bits se asignará un valor entre 0 (negro) y 255 (blanco). En un sensor de 12 bits habría unos 4.000 niveles distintos para cada píxel del sensor.

Finalmente el procesador de la cámara utiliza toda esa información para generar el fichero RAW correspondiente a esa imagen y lo guarda en la tarjeta de memoria. O si tenemos la cámara configurada para que genere una imagen en formato JPEG (algunas cámaras sólo guardan en formato JPEG, no RAW), el procesador se encarga de hacer lo que se conoce como revelado digital y de procesar la imagen para dejarla con el aspecto final: balance de blancos, colores, saturación, contraste, etc.

Fíjate que en el ejemplo de arriba aparecen unos electrones ‘extra’ que no se han generado a partir de los fotones, sino que se han generado por otros efectos, por ejemplo debido a efectos térmicos para simplificar.

Por el momento piensa que esos electrones invitados (ruido) son poquísimos comparados con los electrones que se han generado a partir de la luz de la escena. Más adelante los tendremos en cuenta.

Gestión de la exposición

Vamos a imaginar ahora que la celda representa la luz media de la escena que queremos fotografiar.

Las cámaras tienen dos parámetros que permiten controlar la cantidad de luz que llega al sensor:

- la apertura del diafragma

- el tiempo de exposición (o velocidad de obturación).

El diafragma es como una ventana, se puede regular para que deje pasar mucha luz o poca luz.

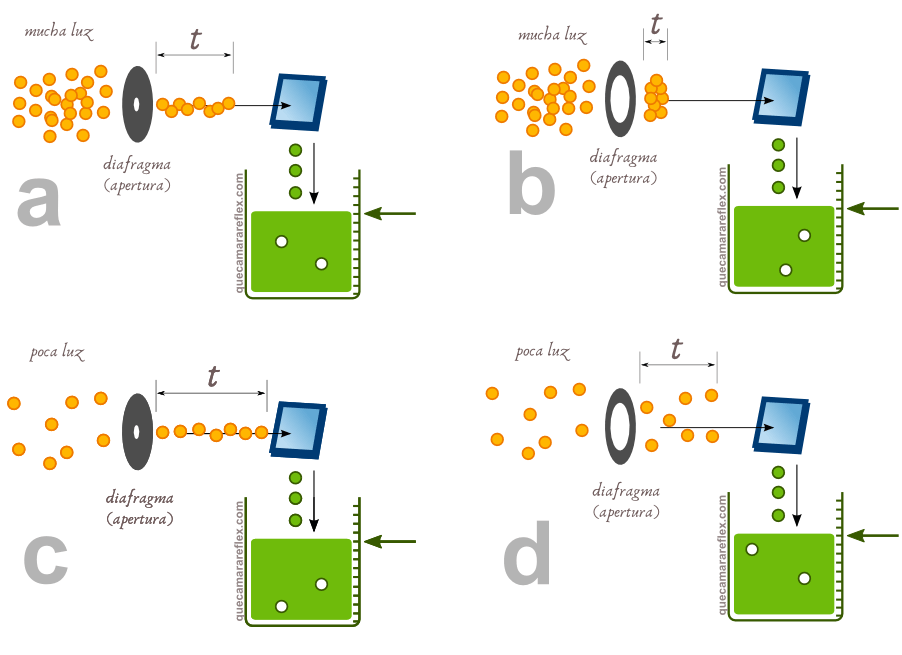

Imagina que en la escena hay mucha luz, hay muchos fotones (ejemplos a y b), y queremos obtener un determinado nivel de ‘claridad’ en nuestra foto.

Podemos cerrar más el diafragma y dejar abierto el obturador un cierto tiempo, o podemos abrir el diafragma y abrir el obturador sólo un instante.

Al final lo importante es el número de fotones que llegan al fotodiodo.

En los ejemplos c y d hay menos luz en la escena.

Si queremos el mismo nivel de claridad tendremos que dejar más tiempo abierto el obturador para que lleguen los mismos fotones que antes.

Si dejamos abierto el obturador durante el tiempo suficiente (incluso si hay poquísima luz) llegará un momento en que todas las celdas estarán llenas.

Ese caso correspondería a una foto totalmente quemada, totalmente blanca.

Se puede jugar con la apertura y el tiempo de exposición en diferentes combinaciones para dar el mismo resultado en lo que respecta a la exposición, es decir, los niveles medios de luminosidad o brillo de la foto.

Sin embargo, cuando la escena tiene mucha luz o muy poca luz habrá combinaciones de diafragma y tiempo de exposición que no serán adecuadas.

Tanto el diafragma como el obturador son elementos físicos que tienen sus propios límites.

En esas situaciones nos saldrían las fotos quemadas o muy brillantes –sobreexpuestas– o muy oscuras –subexpuestas.

Situaciones con muy poca luz

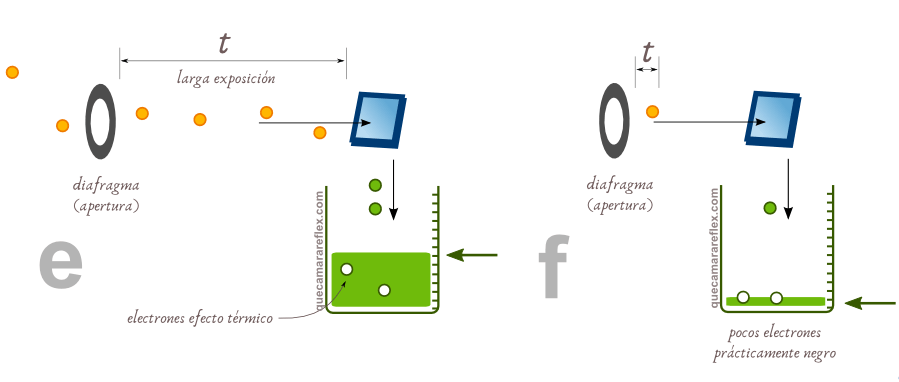

Ahora imagina que queremos hacer una foto en una escena con muy poca luz.

Si se trata de una escena estática podemos subir el tiempo de exposición (minutos, horas incluso) para que vayan entrando poco a poco los escasos fotones que llegan desde el exterior.

Pero si queremos fotografiar una escena en movimiento con muy poca luz tenemos un problema:

- Si dejamos abierto el obturador mucho tiempo (caso e) la foto saldrá movida (porque la escena cambia a lo largo de ese tiempo) y cada celda recibirá información de puntos diferentes a lo largo del tiempo.

- Si programamos un tiempo de disparo muy corto (caso f) entrarán muy pocos fotones: nos quedará una foto muy oscura (subexpuesta)

ISO

Para intentar resolver estas situaciones, los fabricantes de sensores dan la opción de forzar la ‘sensibilidad’ normal de las celdas.

Sensibilidad no es el término más adecuado (porque no se cambia el comportamiento ni la eficiencia de las celdas), pero creo que nos puede dar una idea intuitiva.

Es lo que se conoce en las cámaras como parámetro o valor ISO.

A medida que cambiamos el parámetro ISO en nuestra cámara y vamos subiendo de valor, lo que hacemos es aumentar un factor de multiplicación interno.

Aunque en el ejemplo hemos dibujado una única celda, el efecto multiplicador se aplica a todas las celdas del sensor a la vez.

Es decir se ‘amplifica’ la luz de toda la escena, pero no por métodos ópticos sino por métodos electrónicos.

Se hace una amplificación de la señal eléctrica, que da lugar a un escalado de los valores de cada celda.

Por ejemplo, imagina una situación con buena iluminación.

En esas condiciones vamos a suponer que por cada 1000 fotones obtengo un valor 1 para ese punto de la imagen.

Para llegar al nivel de blanco puro (255, suponiendo 8 bits) necesitaré unos 255.000 fotones.

Si subimos un paso de ISO (la escala de ISO suele partir de 100 y va doblándose en cada paso: 200, 400, 800…) quiere decir que amplificamos la señal de entrada, la multiplicamos por 2.

En estas nuevas condiciones, por cada 1000 fotones obtengo un valor 2.

Para llegar al nivel de blanco puro (255, suponiendo 8 bits) necesitaré la mitad de fotones, unos 125.000.

Y así sucesivamente a medida que aumentamos el valor de ISO.

¿Es como magia, no? … podríamos hacer fotos casi sin luz.

Bueno, no realmente.

Ruido electrónico

¿Te acuerdas de los electrones invitados que habíamos comentado más arriba?

Sí, seguro que ya sospechabas que tendrían un papel en esta historia, y es el papel de ‘malos de la película‘.

En el proceso de captar una imagen aparecen varias fuentes de ruido: ruido fotónico, ruido térmico de diferentes tipos, ruido de muestreo en los convertidores analógico/digital, etc.

Simplemente hay que quedarse con la idea de que se van a generar electrones que no tienen nada que ver con la información de la escena.

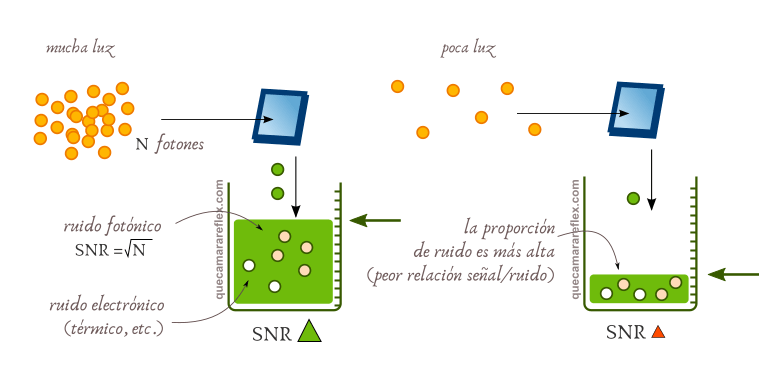

Cuando llegan al sensor muchos fotones, la relación entre la información y el ruido es muy alta (la cantidad de ruido es despreciable con respecto a la cantidad de señal o información).

Cuando llegan pocos fotones de la escena: la cantidad de ruido es proporcionalmente más grande.

¿Qué ocurre cuando forzamos la sensibilidad (ponemos un ISO alto)?.

Pues que multiplicamos la información que nos llega de la escena, pero también multiplicamos el ruido.

Si la proporción entre señal (información) y ruido no es despreciable, al amplificar todo (señal + ruido) estamos haciendo más visible esa parte de ruido.

A medida que subimos ISO las imágenes resultantes aparecerán cada vez más granuladas y con puntos de colores que no corresponden con la escena.

Ten en cuenta que subir ISO no genera ruido, el ruido ya estaba allí.

Lo que hacemos al subir la sensibilidad de forma ‘artificial’ es que el ruido se hace más evidente con respecto a la información útil de la escena.

Dicho de otra forma: la información de la escena viene en los fotones.

Si tenemos muchos fotones, tendremos mucha información, y el ruido será irrelevante (relación señal a ruido muy alta).

Si tenemos pocos fotones, tendremos muy poca información, y de alguna manera estamos ‘inventando’ parte de esa información para generar la imagen final, con lo que ésta tendrá imperfecciones (que percibimos como granulado, etc.)

Tamaños de los sensores más utilizados en cámaras réflex y cámaras EVIL

Es decir, en las cámaras de objetivos intercambiables comerciales.

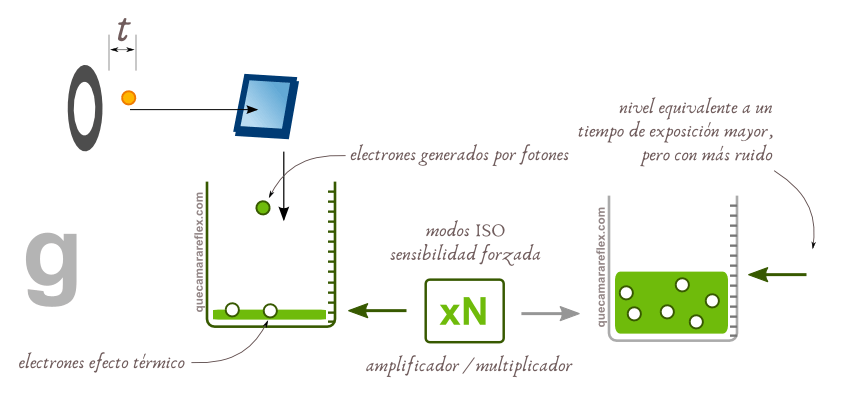

Las cámaras de gamas profesionales suelen utilizar sensores Full Frame, que tienen un tamaño similar a la película analógica (de 35mm), es decir, el sensor mide aproximadamente unos 36 x 24 mm.

Las cámaras de gamas de entrada e intermedia suelen incluir sensores APS-C, que tienen aproximadamente la mitad de superficie que un sensor Full Frame (el 40% aproximadamente)

Las cámaras que siguen el estándar Micro Cuatro Tercios (Micro Four Thirds) usan sensores de 17.3 x 13.8 mm, que tienen aproximadamente el 25% del área de captación de un sensor Full Frame.

Aquí también puedes ver una comparativa de tamaño entre estos sensores y los sensores típicos de las cámaras de los móviles.

En general, cuanta mayor sea la superficie de captación (de cada celda individual y del propio sensor en su conjunto) mejor será la relación señal a ruido de la imagen final, para unas mismas condiciones de exposición: cantidad de luz, apertura, tiempo de exposición, ISO.

Visto así, parece que todos los sensores tendrían que ser enormes, cuanto más grande mejor, ¿no? ¿y por qué no más grandes que Full Frame (p.e. sensores de formato mediano, medium format)?

Más abajo veremos que la ventaja que aporta el tamaño del sensor es relativa y sólo es efectiva en determinadas situaciones concretas.

El tamaño del sensor influye en muchos aspectos del diseño de la cámara: influye en el tamaño de la propia cámara, influye en el tamaño de la parte óptica, influye en el volumen y peso del equipo, influye en el coste del equipo…

En la elección de una cámara (por ejemplo qué sensor es más adecuado) hay que tener en cuenta muchos criterios. Más grande no siempre es mejor.

En fotografía (y vídeo) a la hora de elegir cualquier tipo de elemento o equipo siempre se trata de un compromiso entre ciertas características positivas y otras ‘negativas’ o menos positivas. No hay una cámara o un equipo ideal, perfecto, que sirva para todo.

En general, los equipos basados en sensores APS-C y Micro 4/3 son los que suelen ofrecer una mejor relación entre calidad y la combinación de tamaño + peso + precio…

Pasar por ejemplo a Full Frame implica un salto grande en tamaño + peso + costes, para conseguir un salto relativamente pequeño en calidad o un margen adicional para ciertas situaciones.

Y lo mismo ocurre si pasamos a formato mediano…

Por eso no es tan sencillo como decir que Full Frame es mejor o que el sensor de un móvil no sirve para nada…

Lo mejor es entender cómo funcionan los sensores y las cámaras (y el equipo asociado), y tomar una decisión con criterio, teniendo presentes los pros y contras de cada decisión.

Ruido, ISO y características del sensor

Este apartado está desarrollado con más profundidad en este otro artículo:

Ruido, ISO y características del sensor de una cámara

A modo de resumen…

Lo que llamamos calidad de imagen es un indicador del grado de fidelidad de esa imagen con relación a la escena real que estamos fotografiando (lo mismo aplica a vídeo).

Parámetros que intervienen en la calidad de una imagen:

- Resolución y nitidez: poder apreciar más detalles

- Color: reproducir fielmente los colores de la escena

- Ausencia de artefactos: que la imagen no contenga elementos que no forman parte de la escena real (ruido electrónico, aliasing /Moiré, etc.)

Si hablamos de ruido electrónico…

El ruido forma parte de cualquier imagen generada por una cámara. La propia luz, los fotones que llegan al sensor (o a la película fotográfica), no siguen un patrón continuo y estable.

Suponiendo fuentes de luz totalmente estables y homogéneas, el número de fotones que llega a cada punto del sensor tiene fluctuaciones estadísticas que siguen una distribución de Poisson.

Estas fluctuaciones se conocen como ruido fotónico (shot noise)

Además, cuando el sensor convierte los fotones en electrones (señal analógica) aparecen otras fuentes de ruido electrónico (ruido térmico principalmente)

Finalmente, cuando se convierte la señal electrónica en digital también se añade cierto ruido debido al redondeo: se convierten valores continuos (con decimales) a valores discretos (números enteros)

Señal vs Ruido

Nunca vamos a tener una imagen totalmente limpia, siempre va a incluir ruido.

El parámetro que nos dice de una forma objetiva cómo de limpia es una imagen es la relación señal a ruido (SNR – Signal to Noise Ratio).

En este caso la señal es la información de la escena y el ruido son todas esas pequeñas variaciones aleatorias que se mezclan con ella: ruido fotónico, ruido térmico, etc.

Una imagen con una SNR alta es una imagen con buena calidad, muy limpia.

Una imagen con una SNR baja es una imagen con mala calidad, con ruido apreciable en forma de granulado y puntos de color que no forman parte de la escena real.

Más información aquí:

Tamaño del sensor, exposición y calidad de imagen

Número de fotones vs SNR

El ruido fotónico sigue una distribución de Poisson.

La variabilidad (las fluctuaciones con respecto al número medio de fotones que llegan) no es proporcional al número de fotones, sino a la raíz cuadrada del número de fotones.

Esto quiere decir que cuando tenemos pocos fotones la variabilidad es muy alta (SNR bajo), pero cuando tenemos muchos fotones la variabilidad, en comparación con el número total, es muy baja (SNR alto)

Por otra parte, el ruido térmico y cualquier otra fuente de ruido que aparece al procesar la parte electrónica de la señal, es básicamente independiente de la cantidad de fotones.

¿Qué quiere decir esto?

Que cuantos más fotones tengamos para generar la imagen mejor será su relación señal a ruido, su calidad.

Tamaño de celda, ruido y SNR

Cada celda del sensor la podemos ver inicialmente como un elemento independiente, como un pequeño sensor en sí mismo.

A igualdad de exposición, una celda más grande (con más superficie de captación) recogerá más fotones que una celda más pequeña.

Las celdas más grandes tendrán un mejor rendimiento individual con respecto al ruido, generarán un pixel más limpio, más preciso y más fiel con respecto al tono del punto/zona que corresponda de la escena.

Tamaño de sensor, ruido y SNR

La cuestión es que no podemos tener un sensor de una única celda. La calidad de la imagen viene determinada también por la resolución.

Un sensor de imagen típico está formado por muchísimas celdas.

Dado un tamaño del sensor, el tamaño de cada celda individual viene determinado por la resolución:

- Más resolución: celdas más pequeñas

- Menos resolución: celdas más grandes

Hemos visto que desde el punto de vista de la celda individual interesa que ésta sea lo más grande posible para maximizar la SNR

Sin embargo, si consideramos al sensor como un todo, podríamos evaluar la calidad global de la imagen aplicando el mismo criterio:

Para obtener la mayor relación señal a ruido en la imagen completa necesito capturar el mayor número de fotones que me sea posible.

Como ocurre con las celdas, si tenemos dos sensores con diferentes tamaños, para una determinada exposición se cumple que:

- El sensor más grande recogerá más fotones en total (mejor SNR global)

- El sensor más pequeño recogerá menos fotones (peor SNR)

SNR y percepción visual

He comentado que la ‘calidad de imagen‘ tiene que ver con su SNR.

Mayor SNR en una imagen se corresponde con que la percibimos como una imagen de mejor calidad.

Recuerda que estamos hablando exclusivamente del ruido electrónico y su efecto en la imagen: granulado, pérdida de información de color y de detalle, etc.

Sin embargo, la percepción visual humana tiene un límite a partir del cual ya no podemos distinguir una mejora de SNR.

Por ejemplo, una imagen con una SNR de unos 30dB se percibe como una imagen excelente (da igual la unidad y el valor concreto, es simplemente una relación entre el nivel de señal y el de ruido).

Si comparamos dos imágenes, una con una SNR de 30dB y otra con una SNR de 40dB, es muy probable que no apreciemos ninguna diferencia, o serían muy sutiles en cualquier caso.

Prácticamente cualquier sensor de imagen actual, cuando las condiciones de luz son adecuadas, puede ofrecer imágenes que están por encima de esos 30dB.

La diferencia entre sensores de diferentes características (tamaño de sensor y tamaño de celda) se percibirá sólo en determinadas situaciones y sólo como una mejora (de calidad) relativa.

Es decir, hay que pensar en el tamaño del sensor (o de la celda) como un factor que nos da un pequeño margen extra en determinadas situaciones concretas.

En situaciones ‘normales’ o favorables (buena iluminación), las diferencias de SNR debidas al sensor no se pueden percibir. Dicho de otra forma: todas esas imágenes generadas por diferentes sensores las vamos a percibir como ‘excelentes’, a pesar de que todas ellas tienen SNRs diferentes (pero todas por encima del umbral de percepción)

En esas condiciones, dos sensores muy diferentes, por ejemplo el sensor de un móvil y el sensor Full Frame de una cámara de gama profesional, van a ofrecer una imagen que se percibirá con una ‘calidad’ similar.

A medida que empeoran las condiciones de iluminación o necesitamos exposiciones con menos luz (por ejemplo si necesitamos velocidades de obturación muy altas) los sensores más grandes tendrán una cierta ventaja, porque la SNR de sus imágenes será mayor, y el ruido menos perceptible.

¿Qué es más importante, el tamaño de celda o el tamaño de sensor?

En general es más importante el tamaño del sensor.

Dadas unas condiciones de exposición, una imagen generada por un sensor grande tendrá más calidad (SNR global mayor) que la misma imagen generada por un sensor pequeño (SNR menor) en prácticamente todas las situaciones que podamos imaginar.

Piensa que estamos hablando en términos estadísticos.

El tamaño de celda influye fundamentalmente en la SNR local, a nivel de pixel.

Puede ocurrir perfectamente que una imagen tenga una SNR global excelente, pero que en ciertas zonas (sombras profundas) el ruido sea perceptible.

Y por supuesto, si visualizamos las imágenes al 100%, al 200%, etc. (pixel peeping) lo que veremos será el efecto de la SNR local, no veremos el efecto de la SNR global.

No tiene mucho sentido comparar imágenes pixel a pixel, sobre todo si son imágenes de diferente resolución, porque la imagen útil final, la que verá el cliente o la que verán los usuarios de una web, de una revista o los visitantes de una exposición, será una imagen impresa o redimensionada a una determinada resolución efectiva, en un determinado soporte físico (con sus dimensiones, ancho por alto), con una distancia de visualización típica, etc.

La SNR global afecta a cómo se va a visualizar esa imagen útil.

La regla de oro es que para comparar correctamente las imágenes generadas por dos sensores siempre hay que normalizar de alguna manera: por ejemplo, podemos reescalar las imágenes para que tengan la misma resolución o podemos imprimirlas en papel fotográfico.

Más información:

¿Recogen más luz los sensores más grandes?

¿Más luz significa una exposición mayor en la imagen?

Dos cámaras diferentes con los mismos parámetros de exposición, ¿generan la misma imagen?

¿Qué diferencia o margen hay entre sensores de diferente tamaño?

Ruido vs ISO

El parámetro ISO de las cámaras digitales, su funcionamiento y su efecto real dan lugar a muchísimas confusiones.

Hay varios errores típicos de interpretación asociados al parámetro ISO:

- Subir ISO aumenta el ruido de la imagen: más ISO, más ruido

- Si el ISO es bajo la imagen no tendrá ruido

El nivel de ruido depende de muchos factores. Aquí tienes más información sobre las fuentes de ruido típicas en un sensor de imagen.

Pero el nivel, por sí mismo, no nos dice nada. Lo importante siempre es la relación señal a ruido.

La SNR de una imagen depende fundamentalmente de la cantidad de luz que ha utilizado el sensor para generar dicha imagen.

Si el sensor ha utilizado mucha luz, muchos fotones, la SNR será mayor. Si ha utilizado pocos fotones, la SNR será menor.

El valor de ISO no tiene nada que ver ahí.

Normalmente aumentamos ISO para compensar el hecho de que estamos reduciendo la exposición real.

Por ejemplo, lo típico es que tengamos que configurar un tiempo de exposición más corto: para evitar una foto movida por el tipo de escena (elementos en movimiento) o por la trepidación si no usamos trípode.

Esa menor cantidad de luz es lo que ‘genera’ ruido (disminuye la SNR), no el hecho de subir ISO.

Lo curioso es que subir ISO mejora la SNR en la mayoría de los sensores (reduce el efecto del ruido de lectura), pero ese efecto de mejora no compensa en la mayoría de los casos la pérdida de SNR por haber recibido menos fotones.

Si tomamos una imagen a ISO base (p.e. ISO 100) pero con muy pocos fotones, por ejemplo en un entorno con muy poca iluminación o si subexponemos mucho en el momento de la toma, esa imagen tendrá una SNR muy pobre.

El ruido puede que sea perceptible a simple vista en la imagen original, pero sobre todo será perceptible cuando ‘subamos la exposición’ en revelado/edición para compensar.

Subir ISO en cámara o subir la exposición aparente a posteriori (revelado RAW / edición) no hace que aparezca ruido por arte de magia. Esos procesos no generan ruido. Simplemente hacen visible el ruido que ya está en la imagen, su SNR.

Entonces, ¿es mejor no subir el ISO de la cámara?

Subir el valor de ISO realmente sí afecta de forma positiva a una parte del ruido generado en la electrónica asociada a cada celda.

Subir ISO reduce esa parte de ruido, o mejor dicho, aumenta la SNR de la señal con respecto a esa fuente de ruido (p.e. el ruido de lectura).

Aquí tienes una explicación un poco más técnica de por qué subir ISO ‘disminuye’ el ruido de la imagen.

Sin embargo, la exposición real (número de fotones) siempre va a ser más afectiva a la hora de aumentar la SNR.

La regla de oro sería:

- Siempre que puedas: intenta conseguir la exposición de tu imagen a partir de la luz (fotones)

Por ejemplo aumentando el tiempo de exposición, abriendo más el diafragma o utilizando fuentes de luz adicionales (flash, luz continua, etc.)

Y en esos casos interesa mantener el valor de ISO al mínimo valor nativo posible (por ejemplo al ISO base de la cámara si es posible) para maximizar la exposición real. - Si la situación no permite hacer llegar esa cantidad de luz al sensor por el motivo que sea: entonces aumenta el ISO hasta conseguir la exposición aparente que buscabas.

En general es mejor subir el ISO de la cámara que hacer una foto muy subexpuesta (para intentar recuperarla luego en revelado / edición). La imagen tendrá una SNR mayor, mejor calidad, en el primer caso.

Resumen rápido sobre el rendimiento de los sensores de imagen

- Con buena luz todos los sensores van a generar imágenes de alta calidad

A partir de una cierta relación señal a ruido, el ruido en sí es despreciable y no vamos a apreciar diferencias en las imágenes (reescaladas para comparar, etc.)

Habrá otros efectos que tengan mucha más relevancia: calidad óptica, procesado interno de las imágenes… - Las diferencias entre sensores se aprecian cuando no hay tanta luz en la escena o se trata de una escena con mucho contraste entre zonas claras y zonas oscuras (rango dinámico)

Por ejemplo en interiores, al atardecer, por la noche, escenas de alto rango dinámico (mapeo tonal / subir sombras en edición), situaciones en las que necesitamos velocidades de obturación muy altas (y tenemos que subir ISO), etc. - La evolución tecnológica de los sensores es un factor importante.

- En general, cuanto más grande es el sensor, mayor relación señal a ruido.

Sensores más grandes tienen en general mejor comportamiento en cuanto a ruido (a igualdad tecnológica, exposición, etc. con respecto a un sensor más pequeño) - El tamaño de la celda tiene influencia en las prestaciones, pero su efecto no es tan importante salvo en sensores muy especializados o para tipos de fotografía muy concretos.

- Subir el valor de ISO no aumenta el ruido

El ruido está relacionado con la cantidad e luz que recibe la celda, la cantidad total de luz que recibe el sensor y con la electrónica del sensor (ruido térmico, etc.).

Subir el ISO hace más visible el ruido porque lo escalamos junto con la información de la escena. Si usamos menos fotones para generar la imagen tendremos menor SNR. - En determinadas situaciones (manteniendo constante la cantidad de luz recibida y dependiendo de las características del sensor) subir ISO puede aumentar la SNR: mejora la calidad de la imagen

- El valor de ISO máximo de una cámara es una característica irrelevante.

El parámetro importante es hasta qué ISO puedo subir en una cámara para conseguir imágenes con una calidad aceptable, y esto es algo totalmente subjetivo.

Se toma como referencia una SNR > 20dB para calidad aceptable y SNR>30dB para muy buena calidad

Pero en última instancia es algo subjetivo, que depende de los gustos y criterios de cada uno, así que siempre es importante conocer bien nuestra cámara y nuestro equipo, para saber hasta qué límites podemos llegar manteniendo una calidad aceptable para nosotros. - Comparar el rendimiento de cámaras con sensores diferentes no es sencillo

Intervienen muchos parámetros.

Puedes usar páginas como DXOMARK o photonstophotos.net en las que se utilizan métodos científicos para comparar sensores.

Ten en cuenta también que esos datos sólo te dan una idea global y son datos de laboratorio (en condiciones ideales).

En el día a día de cualquier fotógrafo apenas se aprovechan esos rendimientos máximos que daría teóricamente cada cámara.

Finalmente, la conclusión más importante sería que la clave está sobre todo en la cantidad de luz que llega al sensor.

Si puedes controlar o maximizar la luz que recibe el sensor estarás optimizando su rendimiento y la calidad de las fotos o el vídeo: iluminación, elegir bien los momentos y lugares…

En este sentido los objetivos también juegan un papel muy importante.

La apertura del objetivo determina la cantidad máxima de luz (por unidad de superficie) que llegará al sensor para una determinada escena.

Más información:

La serie sobre el funcionamiento de los sensores de imagen:

- ¿Recogen más luz los sensores más grandes?

- ¿Más luz significa una exposición mayor en la imagen?

- Dos cámaras diferentes con los mismos parámetros de exposición, ¿generan la misma imagen?

- Comparación de sensores de algunas cámaras comerciales

- ¿Qué diferencia o margen hay entre sensores de diferente tamaño?

- Sobre el rango dinámico de los sensores de imagen

- Ruido, ISO y características del sensor de una cámara (versión más simple y fácil de entender)

- ISO y fuentes de ruido en un sensor CMOS (versión un poco más técnica)

- Qué es el fichero RAW de una cámara

- Cómo funciona un sensor Dual ISO

Para profundizar en el tema sobre sensores electrónicos y ruido:

What the DxOMark scores really mean

Sobre el efecto Moiré, aliasing y filtro OLPF en el sensor

Criterios de elección de cámaras y equipo

Cámaras réflex: modelos, características y precios

Cámaras de fotos recomendadas: guías y criterios de elección

Cámaras recomendadas para aprender fotografía

Cámaras réflex recomendadas por gama / tipo de usuario

Cámara para fotografiar a bebés y niños pequeños

Cámaras recomendadas para vlogging